În peisajul digital din 2026, unde inteligența artificială și modelele lingvistice mari (LLM) influențează tot mai mult modul în care motoarele de căutare procesează informațiile, arhitectura informației rămâne pilonul fundamental pentru site-urile cu volum mare de trafic. Pentru marii agregatori, principala provocare constă în SEO Tehnic pentru Portaluri Comparative: Gestionarea Navigării Fațetate (faceted navigation). Acest ghid tehnic este conceput pentru CTO, Manageri SEO și dezvoltatori care activează pe portaluri Fintech (cum ar fi studiul de caz MutuiperlaCasa.com) sau imobiliare, unde milioanele de combinații de filtre se pot transforma în cel mai rău coșmar pentru Bugetul de Crawl (Crawl Budget).

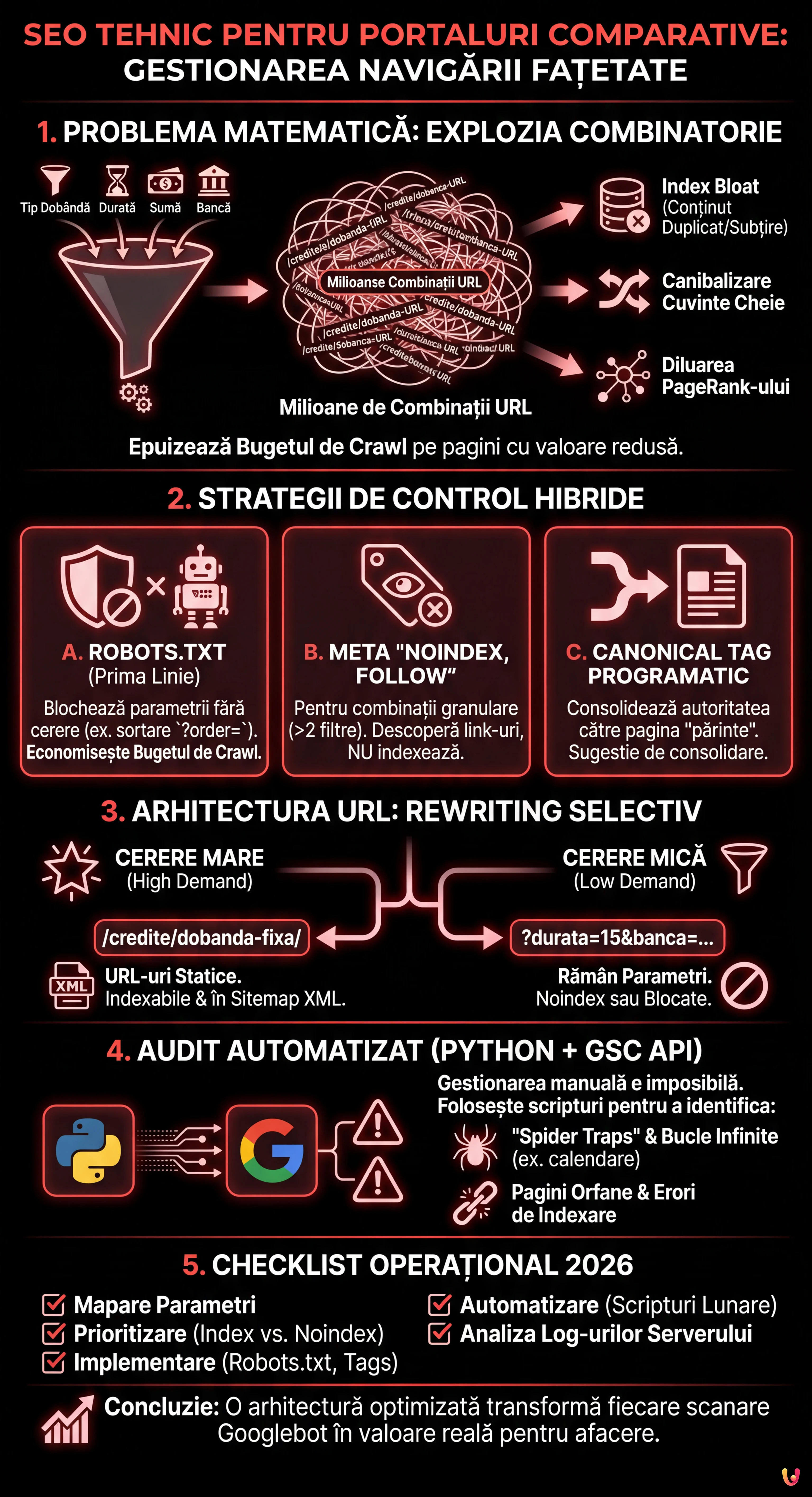

1. Problema Matematică: Combinatorica și Diluarea Autorității

Navigarea fațetată permite utilizatorilor să filtreze rezultatele pe baza mai multor atribute. Într-un portal de credite ipotecare, un utilizator ar putea selecta:

- Tipul dobânzii: Fixă, Variabilă, Mixtă.

- Durata: 10, 15, 20, 25, 30 de ani.

- Suma: Tranșe de 5.000€.

- Banca: 20+ instituții.

Matematic, acest lucru generează o explozie combinatorie. Dacă Googlebot ar încerca să scaneze fiecare permutare posibilă de URL generată de aceste filtre, Bugetul de Crawl ar fi epuizat scanând pagini cu valoare redusă (ex. “Credit dobândă mixtă, 13 ani, Banca X, sumă 125.000€”), lăsând în afara indexului paginile de bază cu conversie ridicată. Acest fenomen duce la:

- Index Bloat: Indexul Google se umple de pagini duplicate sau “thin content”.

- Canibalizarea Cuvintelor Cheie: Mii de pagini concurează pentru aceleași interogări.

- Diluarea PageRank-ului: Autoritatea domeniului este dispersată pe URL-uri inutile.

2. Strategii de Control: Robots.txt, Noindex și Canonical

Nu există o soluție unică. Gestionarea corectă necesită o abordare hibridă bazată pe prioritatea de scanare și indexare.

A. Fișierul Robots.txt: Prima Linie de Apărare

Pentru portalurile comparative, robots.txt este esențial pentru a păstra resursele de scanare. Este necesar să blocați parametrii care nu generează cerere de căutare (search demand) sau care creează conținut duplicat.

Exemplu practic: Într-un portal de credite, sortarea (preț crescător/descrescător) nu schimbă conținutul, ci doar ordinea. Aceasta trebuie blocată.

User-agent: Googlebot

Disallow: /*?order=*

Disallow: /*?price_min=*

Disallow: /*?price_max=*Notă: Blocarea prin robots.txt împiedică scanarea, dar nu elimină neapărat paginile din index dacă acestea sunt link-uite extern. Totuși, este cea mai eficientă metodă pentru a economisi Bugetul de Crawl.

B. Meta Robots “noindex, follow”

Pentru combinațiile de filtre pe care dorim ca Googlebot să le descopere (pentru a urmări link-urile către produse) dar să nu le indexeze, utilizăm eticheta noindex.

Regula de Aur: Aplicați noindex când utilizatorul aplică mai mult de 2 filtre simultan. O pagină “Credite Dobândă Fixă” are valoare SEO. O pagină “Credite Dobândă Fixă + 20 Ani + Intesa Sanpaolo” este probabil prea granulară și ar trebui exclusă din index.

C. Canonical Tag Programatic

Eticheta canonical este o sugestie, nu o directivă. În portalurile comparative, trebuie gestionată programatic pentru a consolida autoritatea către pagina “părinte”.

Dacă un utilizator ajunge pe /credite/dobanda-fixa?session_id=123, canonical-ul trebuie să indice obligatoriu către /credite/dobanda-fixa. Totuși, utilizarea excesivă a canonical-ului pe pagini foarte diferite (ex. canonicalizarea unei pagini filtrate către categoria generală) poate fi ignorată de Google dacă conținutul diferă prea mult.

3. Arhitectura URL și Gestionarea Parametrilor

Conform celor mai bune practici Google Search Central, utilizarea parametrilor standard (?key=value) este adesea preferabilă pentru navigarea fațetată în comparație cu URL-urile statice simulate (/valoare1/valoare2), deoarece permite Google să înțeleagă mai bine structura dinamică.

Logica MutuiperlaCasa.com

În scenariul nostru operațional, am implementat o logică de URL Rewriting Selectiv:

- Landing Page SEO (High Demand): Transformăm parametrii în URL-uri statice.

Ex:?tip=fixadevine/credite/dobanda-fixa/. Aceste pagini sunt prezente în Sitemap XML și sunt indexabile. - Filtre Dinamice (Low Demand): Rămân parametri.

Ex:?durata=15&banca=unicredit. Aceste pagini aunoindexsau sunt blocate prin robots.txt în funcție de volum.

4. Audit Automatizat cu Python și GSC API

Gestionarea manuală a milioane de URL-uri este imposibilă. În 2026, utilizarea Python pentru a interoga API-urile Google Search Console este un standard pentru SEO Tehnic. Mai jos, prezentăm un script pentru a identifica “Spider Traps” și pagini orfane cauzate de filtre.

Cerințe preliminare

- Cont Google Cloud Platform cu API Search Console activat.

- Biblioteci Python:

pandas,google-auth,google-searchconsole.

Scriptul de Analiză

Acest script extrage starea de acoperire a URL-urilor filtrate pentru a identifica anomalii (ex. parametri care ar trebui blocați, dar sunt indexați).

import pandas as pd

import websearch_google_search_console as gsc

# Autentificare (înlocuiți cu propriile credențiale)

account = gsc.authenticate(client_config='client_secrets.json')

webproperty = account['https://www.mutuiperlacasa.com/']

# 1. Extragere date de acoperire (Inspection API)

# Notă: API-ul are limite de cotă, folosiți cu moderație sau pe eșantioane

urls_to_check = [

'https://www.mutuiperlacasa.com/credite?dobanda=fixa&durata=30',

'https://www.mutuiperlacasa.com/credite?dobanda=variabila&order=asc',

# ... listă de URL-uri suspecte generate din log-urile serverului

]

results = []

for url in urls_to_check:

try:

inspection = webproperty.inspect(url)

results.append({

'url': url,

'index_status': inspection.index_status_result.status,

'robots_txt_state': inspection.index_status_result.robots_txt_state,

'indexing_state': inspection.index_status_result.indexing_state,

'user_canonical': inspection.index_status_result.user_canonical,

'google_canonical': inspection.index_status_result.google_canonical

})

except Exception as e:

print(f"Eroare la {url}: {e}")

# 2. Analiza Datelor cu Pandas

df = pd.DataFrame(results)

# Identificare URL-uri unde Google a ales un canonical diferit de cel declarat

canonical_mismatch = df[df['user_canonical'] != df['google_canonical']]

print("Canonical Mismatch Found:")

print(canonical_mismatch)

# Identificare URL-uri indexate care ar trebui să fie blocate

leaking_filters = df[(df['url'].str.contains('order=')) & (df['index_status'] == 'INDEXED')]

print("Filtre 'order' indexate din greșeală:")

print(leaking_filters)

Interpretarea Rezultatelor

Dacă scriptul detectează că URL-uri care conțin order=asc sunt în starea INDEXED, înseamnă că regulile din robots.txt nu au fost aplicate retroactiv sau că există link-uri interne masive care indică spre aceste resurse. În acest caz, acțiunea corectivă este implementarea unei etichete noindex temporare pentru a le elimina, înainte de a le bloca din nou.

5. Gestionarea Spider Trap-urilor și a Buclelor Infinite

Unul dintre cele mai mari riscuri în portalurile comparative este generarea de calendare sau filtre de preț infinite (ex. /pret/100-200, /pret/101-201). Pentru a rezolva această problemă:

- Obfuscation-ul Link-urilor: Utilizați tehnici precum încărcarea filtrelor prin AJAX sau butoane

<button>(în loc de<a href>) pentru filtrele care nu trebuie urmărite de boți. Deși Googlebot poate executa JavaScript, tinde să nu interacționeze cu elemente care nu par link-uri de navigare standard dacă nu este forțat. - Aplicarea Limitelor: Pe partea de server, dacă un URL conține parametri invalizi sau combinații ilogice, trebuie să returneze un cod de stare

404sau410, nu o pagină goală cu status200(Soft 404).

Concluzii și Checklist Operațional

Gestionarea navigării fațetate pentru portaluri comparative nu este o activitate de tip “set and forget”. Necesită o monitorizare constantă. Iată checklist-ul definitiv pentru 2026:

- Mapare: Listați toți parametrii URL generați de CMS.

- Prioritizare: Decideți ce combinații au volum de căutare (Index) și care nu (Noindex/Block).

- Implementare: Configurați

robots.txtpentru economisirea bugetului șinoindexpentru curățarea indexului. - Automatizare: Rulați scripturi Python lunare pentru a verifica dacă Google respectă directivele.

- Analiza Log-urilor: Analizați log-urile serverului pentru a vedea unde își petrece Googlebot timpul. Dacă 40% dintre hit-uri sunt pe pagini

?order=, aveți o problemă de buget.

Adoptând aceste strategii inginerești, portaluri complexe precum MutuiperlaCasa.com pot domina SERP-urile, garantând că fiecare scanare a Googlebot se traduce în valoare reală pentru afacere.

Întrebări frecvente

Navigarea fațetată generează un număr exponențial de combinații URL, ducând adesea la epuizarea Bugetului de Crawl și la fenomenul de Index Bloat. Acest lucru împiedică Google să scaneze paginile importante cu conversie ridicată, diluează PageRank-ul pe resurse inutile și creează canibalizarea cuvintelor cheie între mii de pagini similare.

Gestionarea optimă necesită o abordare hibridă: fișierul robots.txt trebuie să blocheze parametrii care nu generează cerere de căutare, cum ar fi sortarea după preț, pentru a economisi resurse de scanare. Meta eticheta noindex, în schimb, trebuie aplicată paginilor pe care dorim să le descopere boții pentru a urmări link-urile, dar care sunt prea granulare pentru a fi indexate, cum ar fi cele cu mai mult de două filtre active.

Depinde de volumul de căutare. Cea mai bună strategie este URL Rewriting Selectiv: combinațiile cu cerere mare (High Demand) trebuie transformate în URL-uri statice și incluse în Sitemap pentru a maximiza poziționarea. Filtrele cu cerere mică (Low Demand) ar trebui să rămână ca parametri standard (?key=value) și să fie gestionate cu noindex sau blocate pentru a nu dispersa autoritatea.

Pentru a evita ca Googlebot să rămână blocat în bucle infinite, cum ar fi filtre de preț nelimitate sau calendare, este fundamental să folosiți obfuscation-ul link-urilor. Se recomandă încărcarea acestor filtre prin AJAX sau utilizarea elementelor button în loc de etichetele clasice a href. În plus, serverul trebuie să returneze coduri de stare 404 sau 410 pentru combinații de parametri ilogice.

Pentru a gestiona volume mari de URL-uri este necesar să utilizați scripturi în Python care interoghează API-urile Google Search Console. Acest lucru permite extragerea programatică a stării de acoperire, identificarea discrepanțelor dintre canonical-ul declarat și cel ales de Google, și detectarea parametrilor care sunt indexați din greșeală în ciuda regulilor de blocare.

Surse și Aprofundare

Ați găsit acest articol util? Există un alt subiect pe care ați dori să-l tratez?

Scrieți-l în comentariile de mai jos! Mă inspir direct din sugestiile voastre.