In Breve (TL;DR)

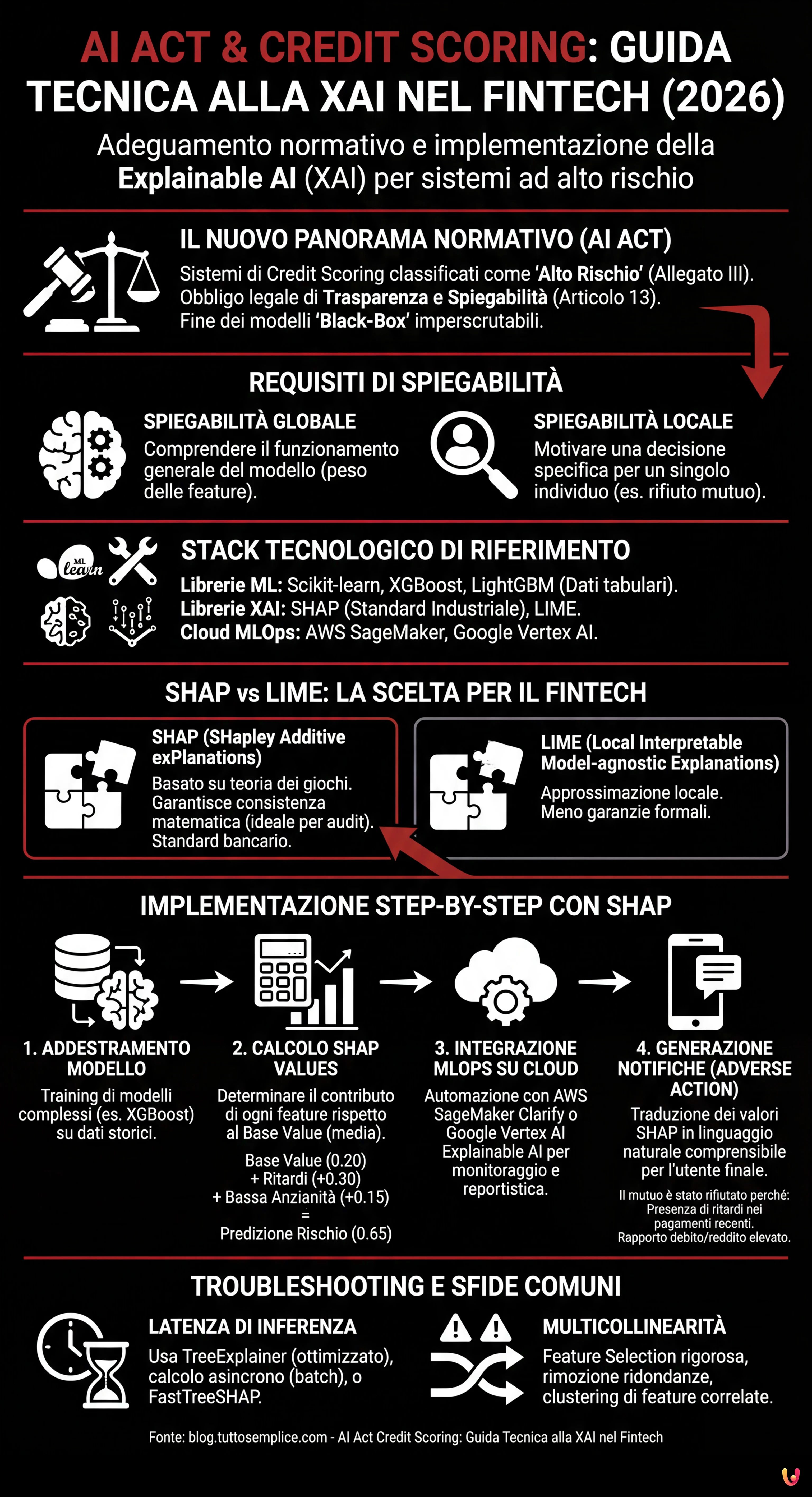

Il Regolamento Europeo sull’Intelligenza Artificiale classifica il credit scoring come sistema ad alto rischio imponendo obblighi rigorosi di trasparenza e spiegabilità.

I Data Scientist devono abbandonare i modelli black-box adottando librerie di Explainable AI come SHAP per garantire decisioni interpretabili e matematicamente consistenti.

L’integrazione di strumenti come AWS SageMaker Clarify nelle pipeline MLOps permette di automatizzare la compliance normativa monitorando bias e spiegabilità in produzione.

Il diavolo è nei dettagli. 👇 Continua a leggere per scoprire i passaggi critici e i consigli pratici per non sbagliare.

Siamo nel 2026 e il panorama del Fintech europeo è radicalmente mutato. Con la piena operatività del Regolamento Europeo sull’Intelligenza Artificiale, l’adeguamento dei sistemi di ai act credit scoring non è più un differenziale competitivo, ma un imperativo legale. I sistemi di valutazione del merito creditizio sono classificati come High-Risk AI Systems (Sistemi ad Alto Rischio) secondo l’Allegato III dell’AI Act. Ciò impone obblighi rigorosi in termini di trasparenza e spiegabilità (Articolo 13).

Per i CTO, i Data Scientist e gli ingegneri MLOps, questo significa la fine dei modelli “black-box” imperscrutabili. Non basta più che un modello XGBoost o una Rete Neurale abbiano un’AUC (Area Under Curve) di 0.95; devono essere in grado di spiegare perché un mutuo è stato rifiutato a uno specifico cliente. Questa guida tecnica esplora l’implementazione della Explainable AI (XAI) nelle pipeline di produzione, colmando il divario tra la compliance normativa e l’ingegneria del software.

Il Requisito di Trasparenza nell’AI Act per il Fintech

L’AI Act stabilisce che i sistemi ad alto rischio devono essere progettati in modo che il loro funzionamento sia sufficientemente trasparente da consentire agli utenti di interpretare l’output del sistema. Nel contesto del credit scoring, questo si traduce in due livelli di spiegabilità:

- Spiegabilità Globale: Comprendere come il modello funziona nel suo complesso (quali feature pesano di più in generale).

- Spiegabilità Locale: Comprendere perché il modello ha preso una decisione specifica per un singolo individuo (es. “Il mutuo è stato rifiutato perché il rapporto debito/reddito supera il 40%”).

L’obiettivo tecnico è trasformare vettori matematici complessi in notifiche di azione avversa (Adverse Action Notices) comprensibili e legalmente difendibili.

Prerequisiti e Stack Tecnologico

Per seguire questa guida all’implementazione, si presuppone la conoscenza di Python e dei principi base di Machine Learning. Lo stack di riferimento include:

- Librerie ML: Scikit-learn, XGBoost o LightGBM (standard de facto per dati tabulari nel credit scoring).

- Librerie XAI: SHAP (SHapley Additive exPlanations) e LIME.

- Cloud Provider: AWS SageMaker o Google Vertex AI (per l’orchestrazione MLOps).

Abbandonare la Black-Box: SHAP vs LIME

Sebbene esistano modelli intrinsecamente interpretabili (come le regressioni logistiche o i Decision Trees poco profondi), spesso questi sacrificano l’accuratezza predittiva. La soluzione moderna è l’utilizzo di modelli complessi (ensemble methods) abbinati a metodi di interpretazione model-agnostic.

Perché scegliere SHAP per il Credit Scoring

Tra le varie opzioni, SHAP è diventato lo standard industriale per il settore bancario. A differenza di LIME, che approssima il modello localmente, SHAP si basa sulla teoria dei giochi cooperativi e garantisce tre proprietà matematiche fondamentali: local accuracy, missingness e consistency. In un contesto regolamentato come quello dell’ai act credit scoring, la consistenza matematica di SHAP offre una garanzia maggiore in caso di audit.

Implementazione Step-by-Step: Da XGBoost a SHAP

Di seguito, un esempio pratico di come integrare SHAP in un modello di scoring del rischio.

1. Addestramento del Modello

Supponiamo di aver addestrato un classificatore XGBoost su un dataset di richieste di prestito.

import xgboost as xgb

import shap

import pandas as pd

# Caricamento dati e addestramento (semplificato)

X, y = shap.datasets.adult() # Dataset esempio

model = xgb.XGBClassifier().fit(X, y)2. Calcolo degli SHAP Values

Invece di limitarci alla predizione, calcoliamo i valori di Shapley per ogni istanza. Questi valori indicano quanto ogni feature ha contribuito a spostare la predizione rispetto alla media del dataset (base value).

# Inizializzazione dell'explainer

explainer = shap.TreeExplainer(model)

shap_values = explainer.shap_values(X)

# Esempio: Spiegazione per il cliente ID 0

print(f"Base Value: {explainer.expected_value}")

print(f"SHAP Values Cliente 0: {shap_values[0]}")Se il Base Value (probabilità media di default) è 0.20 e la predizione per il cliente è 0.65, i valori SHAP ci diranno esattamente quali variabili hanno aggiunto quel +0.45 di rischio (es. +0.30 per ritardi passati, +0.15 per bassa anzianità lavorativa).

Integrazione MLOps su Cloud: Automatizzare la Compliance

Eseguire SHAP in un notebook è semplice, ma l’AI Act richiede monitoraggio continuo e processi scalabili. Ecco come integrare la XAI in pipeline cloud.

AWS SageMaker Clarify

AWS offre SageMaker Clarify, un servizio nativo che si integra nel ciclo di vita del modello. Per configurarlo:

- Configurazione del Processore: Durante la definizione del training job, si configura un

SageMakerClarifyProcessor. - Analisi del Bias: Clarify calcola metriche di bias pre-training (es. squilibri di classe) e post-training (es. disparità di accuratezza tra gruppi demografici), essenziale per l’equità richiesta dall’AI Act.

- Explainability Report: Si definisce una configurazione SHAP (es.

SHAPConfig) che genera automaticamente report JSON per ogni endpoint di inferenza.

Google Vertex AI Explainable AI

Similmente, Vertex AI permette di configurare l’explanationSpec durante il caricamento del modello. Google supporta nativamente Sampled Shapley e Integrated Gradients. Il vantaggio qui è che la spiegazione viene restituita direttamente nell’API response insieme alla predizione, riducendo la latenza.

Generazione Automatica delle “Adverse Action Notices”

Il passaggio finale è tradurre i valori numerici di SHAP in linguaggio naturale per il cliente finale, soddisfacendo l’obbligo di notifica.

Immaginiamo una funzione Python che elabora l’output:

def genera_spiegazione(shap_values, feature_names, threshold=0.1):

spiegazioni = []

for value, name in zip(shap_values, feature_names):

if value > threshold: # Contributo positivo al rischio

if name == "num_ritardi_pagamento":

spiegazioni.append("La presenza di ritardi nei pagamenti recenti ha influito negativamente.")

elif name == "rapporto_debito_reddito":

spiegazioni.append("Il rapporto tra i tuoi debiti e il reddito è elevato.")

return spiegazioniQuesto layer di traduzione semantica è ciò che rende il sistema conforme all’articolo 13 dell’AI Act, rendendo l’algoritmo trasparente all’utente non tecnico.

Troubleshooting e Sfide Comuni

Nell’implementare sistemi di ai act credit scoring spiegabili, si incontrano spesso ostacoli tecnici:

1. Latenza di Inferenza

Il calcolo dei valori SHAP, specialmente il metodo esatto su alberi decisionali profondi, è computazionalmente costoso.

Soluzione: Utilizzare TreeExplainer (ottimizzato per alberi) invece di KernelExplainer. In produzione, calcolare le spiegazioni in asincrono (batch processing) se non è richiesta una risposta real-time immediata all’utente, oppure utilizzare versioni approssimate come FastTreeSHAP.

2. Multicollinearità

Se due feature sono altamente correlate (es. “Reddito Annuo” e “Reddito Mensile”), SHAP potrebbe dividere l’importanza tra le due, rendendo la spiegazione confusa.

Soluzione: Eseguire una rigorosa Feature Selection e rimozione delle feature ridondanti prima del training. Utilizzare tecniche di clustering gerarchico per raggruppare feature correlate.

Conclusioni

L’adeguamento all’AI Act nel settore del credit scoring non è solo un esercizio burocratico, ma una sfida ingegneristica che eleva la qualità del software finanziario. Implementando architetture basate su XAI come SHAP e integrandole in pipeline MLOps robuste su SageMaker o Vertex AI, le aziende Fintech possono garantire non solo la compliance legale, ma anche una maggiore fiducia da parte dei consumatori. La trasparenza algoritmica è la nuova valuta del credito digitale.

Domande frequenti

Il regolamento AI classifica i sistemi di valutazione del merito creditizio come sistemi ad alto rischio secondo l Allegato III. Questa definizione impone alle aziende Fintech obblighi severi di trasparenza e spiegabilità, costringendo ad abbandonare i modelli a scatola chiusa. È ora necessario che gli algoritmi forniscano motivazioni comprensibili per ogni decisione presa, specialmente in caso di rifiuto di un prestito.

La spiegabilità globale permette di capire il funzionamento del modello nel suo insieme, identificando quali variabili hanno più peso in generale. La spiegabilità locale, invece, è fondamentale per la compliance normativa poiché chiarisce perché il modello ha preso una specifica decisione per un singolo cliente, permettendo di generare notifiche precise sulle cause di un esito negativo.

SHAP è diventato lo standard industriale perché si basa sulla teoria dei giochi cooperativi e garantisce proprietà matematiche come la consistenza, essenziale in fase di audit. A differenza di LIME che fornisce approssimazioni locali, SHAP calcola il contributo esatto di ogni caratteristica rispetto alla media, offrendo una giustificazione del punteggio di credito legalmente più solida.

Per automatizzare la compliance è possibile utilizzare servizi gestiti come AWS SageMaker Clarify o Google Vertex AI. Questi strumenti si integrano nel ciclo di vita del modello per calcolare metriche di bias e generare automaticamente report di spiegabilità SHAP per ogni inferenza, garantendo un monitoraggio continuo senza intervento manuale eccessivo.

Il calcolo dei valori SHAP può essere computazionalmente oneroso e rallentare le risposte. Per mitigare il problema si consiglia di utilizzare TreeExplainer che è ottimizzato per gli alberi decisionali, oppure di spostare il calcolo in processi asincroni batch se non serve una risposta immediata. Un altra soluzione efficace è l utilizzo di approssimazioni veloci come FastTreeSHAP.

Fonti e Approfondimenti

- Testo ufficiale del Regolamento (UE) 2024/1689 sull’Intelligenza Artificiale (AI Act)

- Autorità Bancaria Europea (EBA) – Discussion Paper sul Machine Learning nei modelli di rischio di credito

- ICO – Guida istituzionale su come spiegare le decisioni prese dall’Intelligenza Artificiale

- Wikipedia – Approfondimento sulla Explainable Artificial Intelligence (XAI)

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.