In Breve (TL;DR)

Analizziamo come i chatbot gestiscono le informazioni degli utenti e offriamo consigli pratici per proteggere i dati sensibili durante l’uso dell’IA generativa.

Scopri come i chatbot gestiscono le tue informazioni e quali strategie adottare per proteggere la tua privacy online.

Scopri i consigli pratici per difendere i tuoi dati sensibili e utilizzare l’IA generativa senza rischi per la tua privacy.

Il diavolo è nei dettagli. 👇 Continua a leggere per scoprire i passaggi critici e i consigli pratici per non sbagliare.

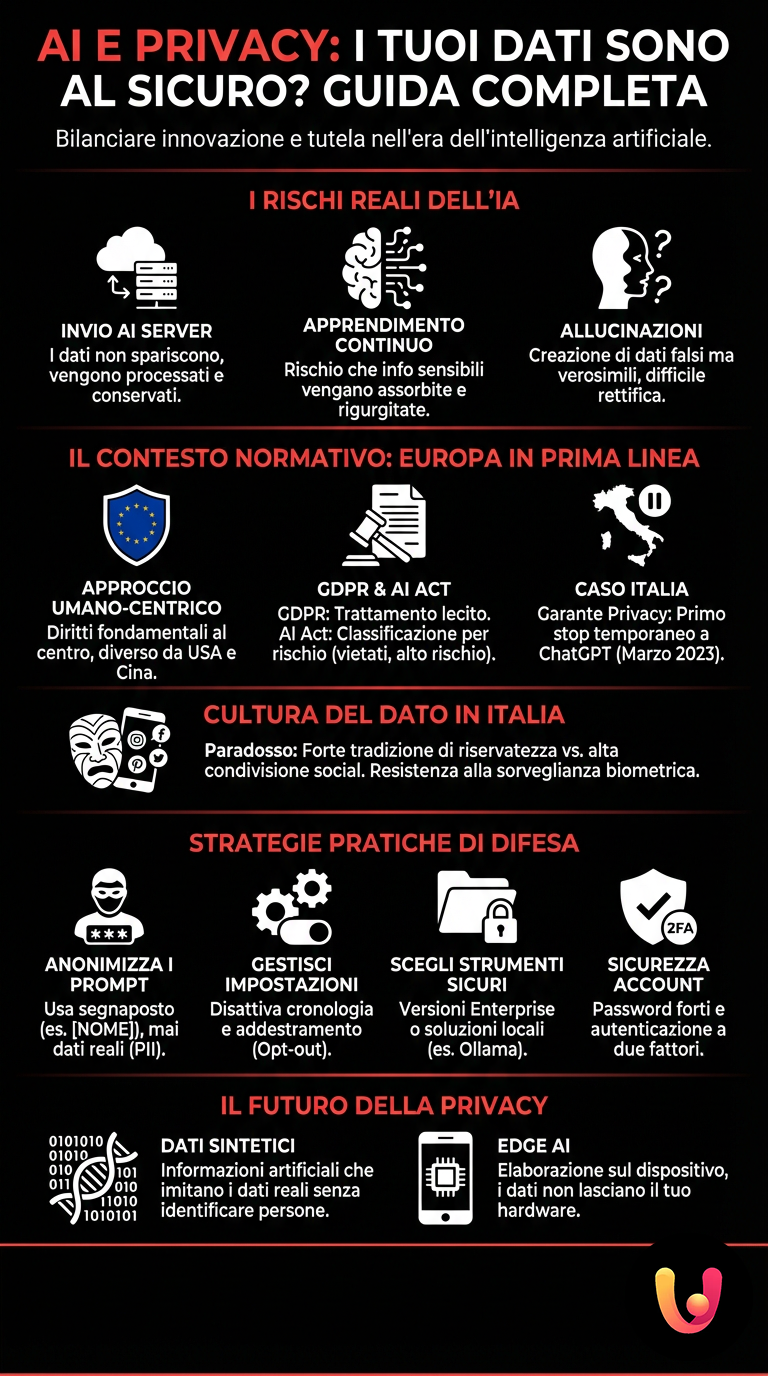

L’intelligenza artificiale è entrata prepotentemente nelle nostre vite, trasformando il modo in cui lavoriamo, studiamo e comunichiamo. Dagli assistenti vocali che accendono le luci di casa ai chatbot avanzati che scrivono email al posto nostro, la comodità è innegabile. Tuttavia, questa rivoluzione digitale porta con sé una domanda fondamentale che spesso viene ignorata: che fine fanno i nostri dati personali?

Ogni volta che interagiamo con un’IA generativa, forniamo informazioni. A volte sono dati innocui, altre volte dettagli sensibili sulla nostra salute, sulle finanze o sulle nostre opinioni politiche. Nel contesto europeo, e specificamente in Italia, la questione della privacy non è solo tecnica, ma profondamente culturale e normativa. Viviamo in un’epoca in cui la tradizione della riservatezza si scontra con l’innovazione della condivisione totale.

In questo articolo analizzeremo i rischi reali per la privacy nell’era dell’IA, esaminando le normative vigenti come il GDPR e il nuovo AI Act, e forniremo consigli pratici per navigare in questo mare digitale senza naufragare. Capiremo come bilanciare l’efficienza degli strumenti moderni con la necessaria tutela della propria identità digitale, esplorando anche le migliori pratiche per l’uso dell’AI generativa in sicurezza.

Il contesto normativo: Italia ed Europa in prima linea

L’Europa si è distinta a livello globale per un approccio “umano-centrico” alla tecnologia. A differenza del modello statunitense, guidato dal mercato, o di quello cinese, guidato dallo stato, il modello europeo pone i diritti fondamentali al centro. Il Regolamento Generale sulla Protezione dei Dati (GDPR) è la pietra miliare di questa difesa.

Il GDPR stabilisce che i dati personali devono essere trattati in modo lecito, corretto e trasparente. Tuttavia, l’addestramento dei grandi modelli linguistici (LLM) spesso avviene su enormi dataset prelevati dal web (scraping), sollevando dubbi sulla legittimità del consenso. Se l’IA ha “letto” i tuoi post sui social media di dieci anni fa per imparare a parlare, ha violato la tua privacy?

Il Garante per la protezione dei dati personali italiano è stato il primo al mondo, nel marzo 2023, a bloccare temporaneamente ChatGPT. Questo atto ha sollevato un dibattito globale sulla necessità di regole chiare per l’addestramento degli algoritmi.

Oggi, con l’approvazione dell’AI Act, l’Unione Europea classifica i sistemi di intelligenza artificiale in base al rischio. I sistemi che manipolano il comportamento umano o sfruttano le vulnerabilità sono vietati, mentre quelli ad alto rischio (come l’IA usata nella selezione del personale o nella giustizia) devono rispettare obblighi severissimi di trasparenza e sicurezza.

Come l’IA gestisce (e rischia di diffondere) i tuoi dati

Per capire i rischi, dobbiamo comprendere come funzionano questi sistemi. Quando scrivi a un chatbot, le tue parole non svaniscono nel nulla. Vengono inviate ai server del fornitore, processate e, in molti casi, conservate. Le aziende utilizzano queste conversazioni per due scopi principali: migliorare il modello e monitorare la sicurezza.

Il rischio dell’apprendimento continuo

Molti utenti credono erroneamente che l’IA sia un contenitore stagno. In realtà, c’è il rischio che le informazioni fornite dagli utenti vengano assorbite dal modello e potenzialmente rigurgitate in conversazioni con altri utenti. Se un medico inserisce i dati di un paziente per farsi aiutare in una diagnosi, o un avvocato carica un contratto riservato, quei dati potrebbero entrare nel ciclo di apprendimento.

Per mitigare questo rischio, è fondamentale conoscere le impostazioni di privacy degli strumenti che utilizziamo. Molte piattaforme offrono ora la possibilità di escludere le proprie chat dall’addestramento, ma spesso è un’opzione che va attivata manualmente (opt-out). Per chi cerca il massimo controllo, l’uso di soluzioni locali è preferibile: una guida utile su questo tema è quella relativa a Ollama e DeepSeek in locale, che spiega come far girare l’IA sul proprio hardware senza inviare dati al cloud.

Allucinazioni e dati falsi

Un altro rischio per la privacy è paradossale: la creazione di dati falsi ma verosimili. Le IA possono “allucinare”, attribuendo a persone reali azioni mai compiute o citazioni mai dette. Questo può danneggiare la reputazione online di un individuo, creando un profilo digitale distorto difficile da rettificare, dato che il “diritto all’oblio” è complesso da applicare all’interno di una rete neurale.

Tradizione e Innovazione: La cultura mediterranea del dato

In Italia, il rapporto con la privacy è complesso. Da un lato, esiste una forte cultura della riservatezza familiare e personale. Dall’altro, siamo uno dei popoli più attivi sui social network e rapidi nell’adozione di nuove tecnologie mobili. Questa dicotomia crea un terreno fertile per i rischi.

La nostra tradizione giuridica e culturale tende a proteggere la dignità della persona. Nel contesto dell’IA, questo si traduce in una forte resistenza contro la sorveglianza biometrica e il riconoscimento facciale indiscriminato negli spazi pubblici, pratiche che l’AI Act limita fortemente. Vogliamo l’innovazione, ma non al costo di diventare numeri in un database.

Le piccole e medie imprese italiane, spina dorsale dell’economia, si trovano spesso impreparate. L’adozione di strumenti di IA per il marketing o la gestione clienti avviene talvolta senza una vera valutazione d’impatto sulla protezione dei dati (DPIA), esponendo sia l’azienda che i clienti a violazioni normative.

Strategie pratiche per proteggere la tua privacy

Non è necessario smettere di usare l’intelligenza artificiale per essere al sicuro. Basta adottare un approccio consapevole e difensivo. Ecco alcune strategie concrete da applicare subito.

Anonimizzazione dei prompt

La regola d’oro è: non inserire mai dati identificativi (PII – Personally Identifiable Information) in un prompt. Invece di scrivere “Scrivi una mail per il cliente Mario Rossi, nato il 12/05/1980, codice fiscale…”, usa dei segnaposto come “[NOME CLIENTE]” o dati fittizi. L’IA lavorerà sulla struttura e sul contenuto logico, e tu potrai inserire i dati reali in un secondo momento, offline.

Gestione della cronologia e delle impostazioni

Controlla regolarmente le impostazioni del tuo account. Su piattaforme come ChatGPT o Gemini, puoi disattivare la cronologia delle chat. Questo impedisce che le conversazioni vengano salvate a lungo termine e utilizzate per l’addestramento. Se usi l’IA per lavoro, verifica se la tua azienda ha un piano “Enterprise”: queste versioni garantiscono contrattualmente che i dati non vengano usati per addestrare i modelli pubblici.

Scegliere lo strumento giusto

Non tutte le IA sono uguali. Alcune sono progettate specificamente per la privacy e la sicurezza, mentre altre sono più “aperte”. Prima di affidare i tuoi dati a un servizio, leggi la privacy policy o consulta comparazioni affidabili, come quella che trovi nel nostro articolo su ChatGPT, Gemini e Copilot, per capire quale piattaforma offre le garanzie migliori per le tue esigenze.

Sicurezza informatica e IA: Un legame indissolubile

La privacy non esiste senza sicurezza. I database delle aziende di IA sono bersagli ambiti per i criminali informatici. Se un hacker violasse i server di un fornitore di servizi AI, milioni di conversazioni private potrebbero essere esposte. È essenziale proteggere i propri account con password forti e autenticazione a due fattori (2FA).

Inoltre, l’IA stessa viene usata per creare attacchi più sofisticati, come email di phishing altamente personalizzate e prive di errori grammaticali, o deepfake vocali per truffe telefoniche. Per approfondire come difendersi da queste minacce evolute, ti consigliamo di leggere la nostra guida su come proteggere privacy e dati online.

La consapevolezza è la prima linea di difesa. Un utente informato è un utente difficile da ingannare e da profilare.

Il futuro: Privatezza sintetica e Edge AI

Il futuro della privacy nell’IA potrebbe risiedere in nuove tecnologie. I “dati sintetici” sono informazioni create artificialmente che imitano le statistiche dei dati reali senza contenere informazioni su persone vere. Questo permette di addestrare le IA senza violare la privacy di nessuno.

Un’altra tendenza è l’Edge AI, ovvero l’elaborazione dei dati direttamente sul dispositivo dell’utente (smartphone o PC) invece che nel cloud. I nuovi processori (NPU) integrati nei computer moderni vanno in questa direzione. Questo riduce drasticamente il rischio di fuga di dati, poiché le informazioni non lasciano mai il tuo dispositivo. Per chi deve gestire grandi moli di dati personali, è fondamentale considerare anche dove questi vengono archiviati, valutando strategie di backup sicuro e cloud privato.

Conclusioni

L’intelligenza artificiale rappresenta una straordinaria opportunità di crescita e semplificazione, ma nel contesto europeo e italiano non può prescindere dal rispetto della persona. La privacy non è un ostacolo all’innovazione, ma la condizione necessaria affinché l’innovazione sia sostenibile e democratica.

Proteggere i propri dati richiede un mix di consapevolezza normativa, igiene digitale e utilizzo di strumenti adeguati. Continuando a informarci e a pretendere trasparenza dalle aziende tecnologiche, possiamo godere dei benefici dell’IA senza sacrificare la nostra libertà digitale. La tecnologia deve rimanere uno strumento al servizio dell’uomo, e mai il contrario.

Domande frequenti

In Italia e in Europa, i servizi di IA devono rispettare il GDPR, garantendo standard di trasparenza elevati. Tuttavia, le conversazioni possono essere utilizzate per addestrare i modelli se non si modificano le impostazioni. È fondamentale evitare di inserire dati sensibili, sanitari o bancari nelle chat.

La maggior parte dei chatbot, inclusi quelli di OpenAI e Google, offre opzioni specifiche nelle impostazioni chiamate Controlli dei dati. Disattivando la cronologia delle chat o l’opzione di addestramento del modello, si impedisce che le proprie conversazioni vengano usate per migliorare l’algoritmo.

Il rischio principale è la fuga di dati aziendali riservati. Se si caricano documenti interni su versioni pubbliche e gratuite dei chatbot, queste informazioni potrebbero diventare parte della conoscenza dell’IA. Per scopi professionali, è consigliabile utilizzare versioni Enterprise che garantiscono la riservatezza dei dati.

L’AI Act è il primo regolamento al mondo che classifica i sistemi di IA in base al rischio. Impone obblighi severi di trasparenza e sicurezza per i sistemi ad alto rischio e vieta pratiche che minacciano i diritti fondamentali, assicurando che l’innovazione tecnologica non calpesti la privacy dei cittadini europei.

Sì, in base al diritto all’oblio previsto dal GDPR, gli utenti possono richiedere la cancellazione dei propri dati personali. Le piattaforme devono fornire moduli o impostazioni accessibili per eliminare l’account o rimuovere specifiche conversazioni dai server.

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.