Im aktuellen Umfeld der Kreditvermittlung ist es ein fataler strategischer Fehler, die Lead-Generierung als reine Marketingaktivität zu betrachten. Wir befinden uns im Zeitalter des Lead-Engineerings, in dem der Prozess der Kundenakquise als geschlossener Regelkreis behandelt werden muss. Dieser technische Leitfaden untersucht, wie man eine Engine für prädiktives Lead-Scoring innerhalb eines fortschrittlichen CRM-Ökosystems wie BOMA entwirft und implementiert, um rohe Verhaltensdaten in mathematische Wahrscheinlichkeiten für eine Hypothekenvergabe umzuwandeln.

Das Ziel ist nicht mehr, Kontakte zu generieren, sondern den Umsatz vorherzusagen. Durch den Einsatz von Algorithmen des maschinellen Lernens und einer soliden Datenarchitektur wechseln wir von der subjektiven Intuition der Vertriebsmitarbeiter zu einem deterministischen, datengestützten Ansatz.

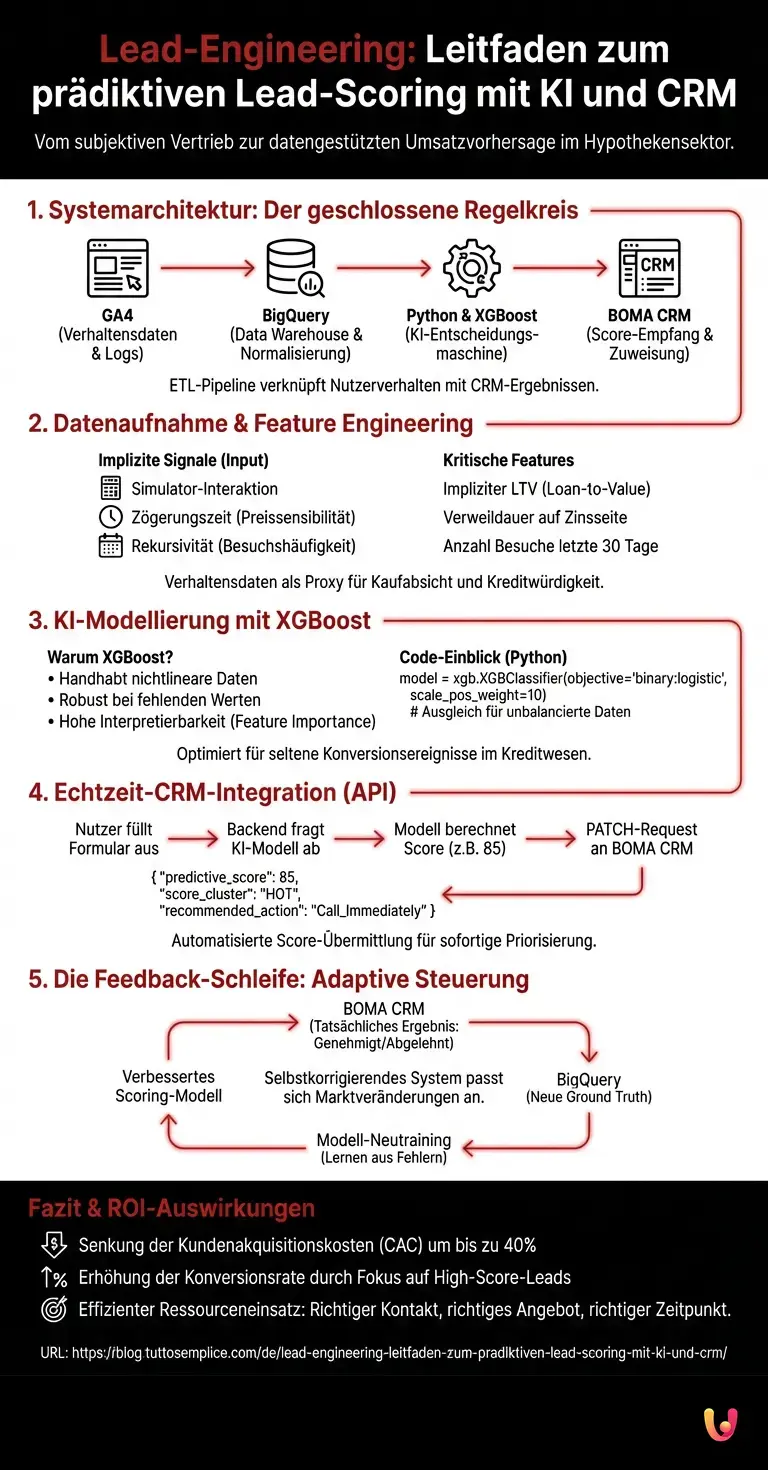

1. Systemarchitektur: Vom Tracking zur Inferenz

Um ein effektives Scoring-Modell zu erstellen, müssen wir zunächst eine Datenpipeline (ETL) etablieren, die das Nutzerverhalten auf der Website mit dem tatsächlichen Ergebnis des Vorgangs im CRM verknüpft. Die vorgeschlagene Architektur basiert auf drei Säulen:

- Datenquelle (Input): Google Analytics 4 (GA4) für Verhaltensdaten und Logs des Hypothekenrechners.

- Data Warehouse (Processing): Google BigQuery für die Speicherung und Normalisierung der Daten.

- Entscheidungsmaschine (Core): Python-Skripte (gehostet auf Cloud Functions oder Vertex AI), die XGBoost-Modelle ausführen.

- Ziel (Output): Das CRM BOMA, das den Score empfängt und die Lead-Zuweisung orchestriert.

Technische Voraussetzungen

Bevor Sie fortfahren, stellen Sie sicher, dass Sie Zugriff auf Folgendes haben:

- Google Cloud Platform-Konto mit aktiviertem BigQuery.

- Täglicher Export (oder Streaming) von GA4 nach BigQuery konfiguriert.

- API-Zugriff auf das BOMA CRM (oder Ihr proprietäres CRM).

- Python 3.9+ Umgebung mit den Bibliotheken

pandas,scikit-learn,xgboost.

2. Datenaufnahme und Feature Engineering

Das prädiktive Lead-Scoring basiert nicht nur auf demografischen Daten (Alter, Einkommen), sondern vor allem auf impliziten Signalen. Im Hypothekensektor ist die Art und Weise, wie ein Nutzer mit dem Simulator interagiert, ein Proxy für seine Kaufabsicht und seine Kreditwürdigkeit.

Extraktion aus BigQuery

Wir müssen die Nutzersitzungen extrahieren und in Features umwandeln. Hier ist eine beispielhafte SQL-Abfrage zum Extrahieren von Verhaltensmetriken:

SELECT

user_pseudo_id,

COUNTIF(event_name = 'view_mortgage_simulator') as simulator_interactions,

AVG(SAFE_CAST(event_params.value.string_value AS FLOAT64)) as avg_loan_amount,

MAX(event_timestamp) - MIN(event_timestamp) as session_duration_micros,

COUNTIF(event_name = 'download_pdf_guide') as high_intent_actions

FROM

`project_id.analytics_123456.events_*`

WHERE

_TABLE_SUFFIX BETWEEN '20251201' AND '20260131'

GROUP BY

user_pseudo_id

Definition kritischer Features

Für ein Scoring-Modell im Kreditwesen gehören zu den prädiktivsten Variablen (Features), die wir entwickeln müssen:

- Impliziter Loan-to-Value (LTV): Wenn der Nutzer im Simulator einen gewünschten Betrag und einen Immobilienwert eingibt, ist das Verhältnis ein starker Indikator für die Machbarkeit.

- Zögerungszeit: Eine übermäßige Verweildauer auf der Zinsseite könnte auf Preissensibilität (Price Sensitivity) hinweisen.

- Rekursivität: Anzahl der Besuche in den letzten 30 Tagen.

3. Entwicklung des algorithmischen Modells (XGBoost)

Warum XGBoost (Extreme Gradient Boosting) statt einer einfachen logistischen Regression verwenden? Weil Verhaltensdaten oft nichtlinear sind und viele fehlende Werte enthalten. Entscheidungsbäume gehen besser mit diesen Unregelmäßigkeiten um und bieten durch die Feature Importance eine bessere Interpretierbarkeit.

Python-Implementierung

Nachfolgend ein Codebeispiel zum Trainieren des Modells. Wir gehen davon aus, dass wir einen DataFrame df haben, der die GA4-Daten mit dem historischen Ergebnis der Vorgänge (0 = verloren, 1 = ausgezahlt), exportiert aus dem CRM, verbindet.

import xgboost as xgb

from sklearn.model_selection import train_test_split

from sklearn.metrics import roc_auc_score

# Trennung von Features und Zielvariable

X = df.drop(['conversion_flag', 'user_id'], axis=1)

y = df['conversion_flag']

# Aufteilung des Datensatzes (Split)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# Konfiguration des XGBoost-Modells

model = xgb.XGBClassifier(

objective='binary:logistic',

n_estimators=100,

learning_rate=0.05,

max_depth=6,

scale_pos_weight=10 # Entscheidend für unbalancierte Datensätze (wenige ausgezahlte Hypotheken im Vergleich zu Leads)

)

# Training

model.fit(X_train, y_train)

# Evaluierung

preds = model.predict_proba(X_test)[:, 1]

print(f"AUC Score: {roc_auc_score(y_test, preds)}")

Der Parameter scale_pos_weight ist im Kreditsektor von grundlegender Bedeutung, wo die reale Konversionsrate unter 2-3% liegen kann. Dies gleicht das Gewicht der Fehler bei den positiven Klassen aus.

4. API-Integration mit dem BOMA CRM

Sobald das Modell eine Wahrscheinlichkeit generiert (z. B. 0.85), muss diese in Echtzeit oder im Batch an das CRM gesendet werden. Im Kontext von BOMA verwenden wir REST-APIs, um das benutzerdefinierte Feld predictive_score zu aktualisieren.

Aktualisierungs-Workflow

- Der Nutzer füllt das Formular zur Angebotsanfrage aus.

- Das Backend sendet die Daten an das CRM und fragt gleichzeitig unser Modell ab (bereitgestellt über Flask/FastAPI).

- Das Modell berechnet den Score basierend auf der Navigationshistorie (abgerufen über

client_idoder Cookies). - Das System sendet einen PATCH-Request an das CRM.

Beispiel für JSON-Payload an BOMA:

{

"lead_id": "102938",

"custom_fields": {

"predictive_score": 85,

"score_cluster": "HOT",

"recommended_action": "Call_Immediately"

}

}

5. Die Feedback-Schleife: Adaptive Steuerung

Die wahre Kraft des System-Engineerings liegt im Feedback. Ein statisches Modell verschlechtert sich mit der Zeit (Model Drift). Es ist notwendig, einen umgekehrten Prozess zu konfigurieren:

Jede Nacht muss ein Skript den aktuellen Status der Vorgänge (z. B. «Prüfung», «Genehmigung», «Abgelehnt») aus dem BOMA CRM extrahieren und in BigQuery laden. Diese Daten werden zur neuen Ground Truth für das Neutraining des Modells.

- Wenn das Modell 90/100 für einen Lead vorhergesagt hatte, der später wegen «Unzureichendem Einkommen» abgelehnt wurde, lernt der Algorithmus, ähnliche Feature-Kombinationen in zukünftigen Iterationen zu bestrafen.

- Dies schafft ein selbstkorrigierendes System, das sich an Marktveränderungen anpasst (z. B. Verschärfung der Kreditrichtlinien der Banken).

Fazit und Auswirkungen auf den ROI

Die Implementierung eines Systems für prädiktives Lead-Scoring ist keine akademische Übung, sondern eine finanzielle Notwendigkeit. Durch die Verlagerung der Call-Center-Ressourcen auf Leads mit einem Score > 70 können Kreditvermittlungsunternehmen die Kundenakquisitionskosten (CAC) um bis zu 40% senken und die Konversionsrate der bearbeiteten Vorgänge erhöhen.

Die Integration von GA4, BigQuery und einem fortschrittlichen CRM wie BOMA repräsentiert den Stand der Technik im Jahr 2026. Es geht nicht mehr darum, alle Kontakte so schnell wie möglich anzurufen, sondern die richtigen Kontakte mit dem richtigen Angebot zum richtigen Zeitpunkt anzurufen, geleitet von der Mathematik.

Häufig gestellte Fragen

Prädiktives Lead-Scoring ist eine Methodik, die Algorithmen des maschinellen Lernens verwendet, um die mathematische Wahrscheinlichkeit zu berechnen, dass sich ein Kontakt in Umsatz verwandelt. Im Kreditsektor analysiert dieses System das Nutzerverhalten, wie z. B. die Interaktion mit dem Simulator, um einen Prioritäts-Score zuzuweisen, wodurch sich Berater nur auf Vorgänge mit hoher Bewilligungswahrscheinlichkeit konzentrieren können.

XGBoost wird bevorzugt, da Online-Verhaltensdaten oft nichtlinear und fragmentiert sind. Im Gegensatz zur klassischen Regression gehen die Entscheidungsbäume dieses Algorithmus besser mit fehlenden Werten um und bieten eine höhere Interpretierbarkeit der Variablen, was sie bei der Vorhersage komplexer Ergebnisse wie einer Hypothekengenehmigung effektiver macht.

Ein robustes Modell erfordert die Kombination von Navigationsdaten aus Tools wie Google Analytics 4 und historischen Daten zu den Ergebnissen der Vorgänge im CRM. Zu den prädiktivsten Features gehören das implizite Verhältnis von Rate zu Einkommen, die Zögerungszeit bei Angeboten und die Häufigkeit der Website-Besuche in den letzten 30 Tagen.

Die Architektur sieht die Extraktion von Rohdaten aus GA4 nach BigQuery zur Speicherung vor. Anschließend verarbeiten Python-Skripte diese Daten und generieren einen Score, der in Echtzeit über eine API an das BOMA CRM gesendet wird. Dies ermöglicht es, die Kundenkartei mit einem prädiktiven Score zu aktualisieren und dem Vertriebsmitarbeiter die beste Vorgehensweise vorzuschlagen.

Die Feedback-Schleife ist ein Prozess, der das tatsächliche Verkaufsergebnis aus dem CRM in das KI-Modell zurückführt. Dies ermöglicht dem System, sich selbst zu korrigieren: Wenn ein Lead mit hohem Score nicht konvertiert, lernt der Algorithmus, ähnliche Profile in Zukunft abzuwerten, was die Kundenakquisitionskosten senkt und die operative Effizienz des Call-Centers erhöht.

Fanden Sie diesen Artikel hilfreich? Gibt es ein anderes Thema, das Sie von mir behandelt sehen möchten?

Schreiben Sie es in die Kommentare unten! Ich lasse mich direkt von Ihren Vorschlägen inspirieren.