Dans le paysage actuel de la business intelligence, l’analyse des données marketing a atteint un point de saturation où les métriques traditionnelles ne suffisent plus pour distinguer la valeur réelle du bruit de fond. Alors que 2026 nous offre des outils d’IA avancés, la véritable révolution réside dans le retour aux fondamentaux de l’ingénierie : le Traitement Numérique du Signal (DSP). Traiter un flux de leads comme un signal électrique nous permet d’appliquer une rigueur mathématique au nettoyage des bases de données, transformant le chaos du Big Data en informations exploitables. Dans cet article, nous explorerons comment les principes des télécommunications et de l’électronique peuvent être transposés directement aux stratégies d’acquisition de clients.

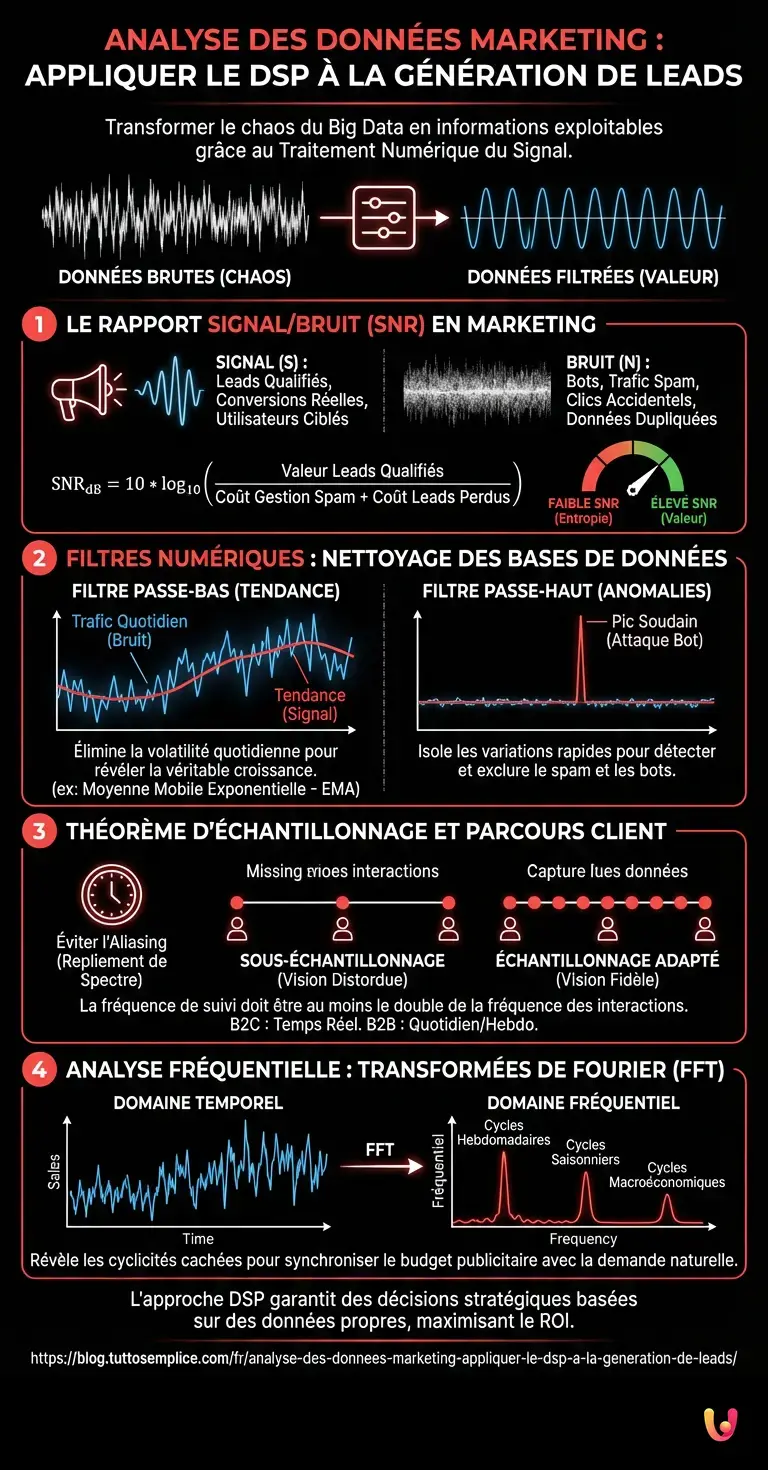

Le Concept de Rapport Signal/Bruit (SNR) en Marketing

En ingénierie électronique, le Rapport Signal/Bruit (Signal-to-Noise Ratio, SNR) mesure la puissance d’un signal utile par rapport à celle du bruit de fond qui le corrompt. Dans l’écosystème du marketing numérique, cette analogie est parfaite :

- Signal (S) : Leads qualifiés, conversions réelles, utilisateurs ciblés.

- Bruit (N) : Bots, trafic spam, clics accidentels, leads hors cible, données dupliquées.

Une approche scientifique de l’analyse des données marketing nécessite de maximiser ce rapport. Mathématiquement, si dans un jeu de données de 10 000 contacts (le « canal »), seuls 1 500 sont des leads qualifiés (SQL), notre SNR est faible. L’objectif n’est pas seulement d’augmenter le volume (amplification), ce qui augmenterait aussi le bruit, mais de filtrer le canal.

Calcul du SNR pour les Sources de Trafic

Nous pouvons quantifier la qualité d’une campagne PPC ou d’une source organique en utilisant une formule logarithmique adaptée :

SNR_dB = 10 * log10( (Valeur_Leads_Qualifiés) / (Coût_Gestion_Spam + Coût_Leads_Perdus) )

Si le résultat est négatif ou proche de zéro, la source de trafic introduit plus d’entropie que de valeur dans votre CRM, quel que soit le volume de trafic généré.

Application des Filtres Numériques aux Jeux de Données

Le cœur du DSP réside dans l’utilisation de filtres pour manipuler le signal. Nous pouvons écrire des algorithmes en Python ou SQL qui agissent comme des filtres numériques sur nos bases de données de contacts.

1. Filtre Passe-Bas (Low-Pass Filter) : Identifier la Tendance

Un filtre passe-bas permet le passage des fréquences inférieures à un certain seuil de coupure, atténuant celles supérieures. Dans l’analyse des séries temporelles marketing, les « hautes fréquences » sont représentées par la volatilité quotidienne, les pics causés par des bots ou des événements aléatoires.

Application Pratique : Utiliser une Moyenne Mobile Exponentielle (EMA) ou un filtre de Butterworth sur les données de trafic quotidien. Cela élimine le « jitter » (le bruit quotidien) et révèle la véritable tendance de croissance ou de décroissance de la demande du marché (le signal à basse fréquence).

import pandas as pd

# Exemple conceptuel de Filtre Passe-Bas sur des données de trafic

data['Trafic_Clean'] = data['Trafic_Raw'].ewm(span=7, adjust=False).mean()

2. Filtre Passe-Haut (High-Pass Filter) : Détection d’Anomalies et Spam

À l’inverse, un filtre passe-haut atténue les composantes lentes (la tendance) et laisse passer les variations rapides. C’est fondamental pour la sécurité et le nettoyage des données.

Application Pratique : Si un formulaire de contact reçoit habituellement 1 lead par heure (basse fréquence), un pic soudain de 50 leads en une minute représente un signal à très haute fréquence. En appliquant un filtre passe-haut numérique, nous pouvons isoler ces pics et les marquer automatiquement comme des attaques probables de bots ou du spam, en les isolant de la base de données principale avant qu’ils ne polluent les statistiques de conversion.

Théorème d’Échantillonnage et Parcours Client

Le Théorème de Nyquist-Shannon stipule que pour reconstruire fidèlement un signal analogique, la fréquence d’échantillonnage doit être au moins le double de la fréquence maximale du signal lui-même. Comment cela s’applique-t-il à l’analyse des données marketing ?

De nombreux marketeurs commettent l’erreur de « sous-échantillonner » (undersampling) le comportement de l’utilisateur. Si un utilisateur interagit avec la marque sur plusieurs points de contact en l’espace de 24 heures, mais que votre système d’attribution n’enregistre les données qu’une fois par jour (ou pire, utilise un modèle simpliste au dernier clic), vous subissez un phénomène d’Aliasing (repliement de spectre).

L’Aliasing en marketing crée une réalité distordue : vous attribuez la conversion au mauvais canal parce que vous avez « perdu » les oscillations intermédiaires du comportement utilisateur. Pour éviter cela, la fréquence de suivi (taux d’échantillonnage) doit être adaptée à la vitesse du cycle de vente :

- B2C (Impulsion rapide) : Nécessite un échantillonnage en temps réel ou quasi temps réel.

- B2B (Cycle long) : Un échantillonnage quotidien ou hebdomadaire peut être suffisant sans violer Nyquist.

Analyse dans le Domaine Fréquentiel : Transformées de Fourier (FFT)

L’un des outils les plus puissants et les moins utilisés en marketing est l’analyse spectrale. En transformant une série temporelle de leads du domaine temporel au domaine fréquentiel via la Fast Fourier Transform (FFT), nous pouvons découvrir des cyclicités invisibles à l’œil nu.

Étude de Cas : La Demande de Crédits Immobiliers

Imaginons que nous analysions la demande de crédits immobiliers. Dans le domaine temporel, nous ne voyons qu’une ligne irrégulière qui monte et descend. En appliquant la FFT, nous pourrions découvrir des pics de fréquence spécifiques qui correspondent à :

- Cycles Hebdomadaires : Pics de recherche le week-end.

- Cycles Saisonniers : Augmentations corrélées à des mois spécifiques de l’année.

- Cycles Macroéconomiques : Corrélations avec les annonces de taux d’intérêt des banques centrales.

Identifier ces « fréquences dominantes » permet d’anticiper la demande, en allouant le budget publicitaire en phase (en synchronisation) avec la vague de la demande, plutôt qu’en opposition de phase (gaspillant du budget lorsque la demande naturelle est faible).

Conclusion : Vers un Marketing Déterministe

L’adoption de filtres numériques et de concepts de DSP dans l’analyse des données marketing n’est pas un simple exercice académique. C’est une nécessité opérationnelle pour quiconque gère de grands volumes de données en 2026. Passer d’une vision purement statistique à une vision basée sur le traitement des signaux permet de :

- Nettoyer les jeux de données à la source (Filtres).

- Évaluer objectivement la qualité des canaux (SNR).

- Éviter les erreurs d’attribution (Échantillonnage de Nyquist).

- Prévoir des cyclicités complexes (FFT).

L’avenir du marketing appartient à ceux qui savent traiter la donnée non pas comme un nombre statique, mais comme un signal dynamique à traiter, nettoyer et interpréter avec une précision d’ingénieur.

Foire aux questions

Utiliser le DSP en marketing signifie traiter les flux de leads comme des signaux électriques à élaborer avec une rigueur mathématique. Cette approche d’ingénierie permet de distinguer les contacts qualifiés, considérés comme un signal utile, du trafic spam ou des bots qui représentent le bruit de fond, garantissant des décisions stratégiques basées sur des données propres et non sur des métriques de vanité.

Le Rapport Signal Bruit, ou SNR, mesure la qualité réelle d’une source de trafic en comparant le volume de leads qualifiés à celui des données inutiles comme les clics accidentels et les bots. Une valeur SNR élevée indique que la campagne génère une valeur concrète, tandis qu’un résultat faible suggère que le désordre et les coûts de gestion du spam dépassent les bénéfices des nouveaux contacts acquis.

Les filtres numériques agissent sur les algorithmes pour séparer les tendances réelles des anomalies momentanées. Un filtre passe-bas élimine la volatilité quotidienne pour montrer la véritable tendance de croissance, tandis qu’un filtre passe-haut isole les pics soudains de trafic, souvent indicatifs d’attaques de bots, permettant de les exclure des statistiques de conversion avant qu’ils ne polluent le CRM.

Le Théorème de Nyquist suggère que la fréquence de suivi doit être adaptée à la vitesse des interactions du client pour éviter le phénomène d’Aliasing. Si l’on échantillonne le comportement utilisateur trop lentement par rapport à la réalité, en particulier dans le B2C, on obtient une vision distordue du parcours d’achat, attribuant de manière erronée les ventes aux mauvais canaux.

La Fast Fourier Transform, connue sous le nom de FFT, permet de passer de l’étude temporelle à celle des fréquences, révélant des cyclicités cachées dans les données de vente. Cet outil aide à identifier des modèles récurrents hebdomadaires ou saisonniers invisibles à l’œil nu, permettant aux marketeurs de synchroniser les budgets publicitaires avec les pics naturels de la demande du marché.

Sources et Approfondissements

Avez-vous trouvé cet article utile ? Y a-t-il un autre sujet que vous aimeriez que je traite ?

Écrivez-le dans les commentaires ci-dessous ! Je m’inspire directement de vos suggestions.