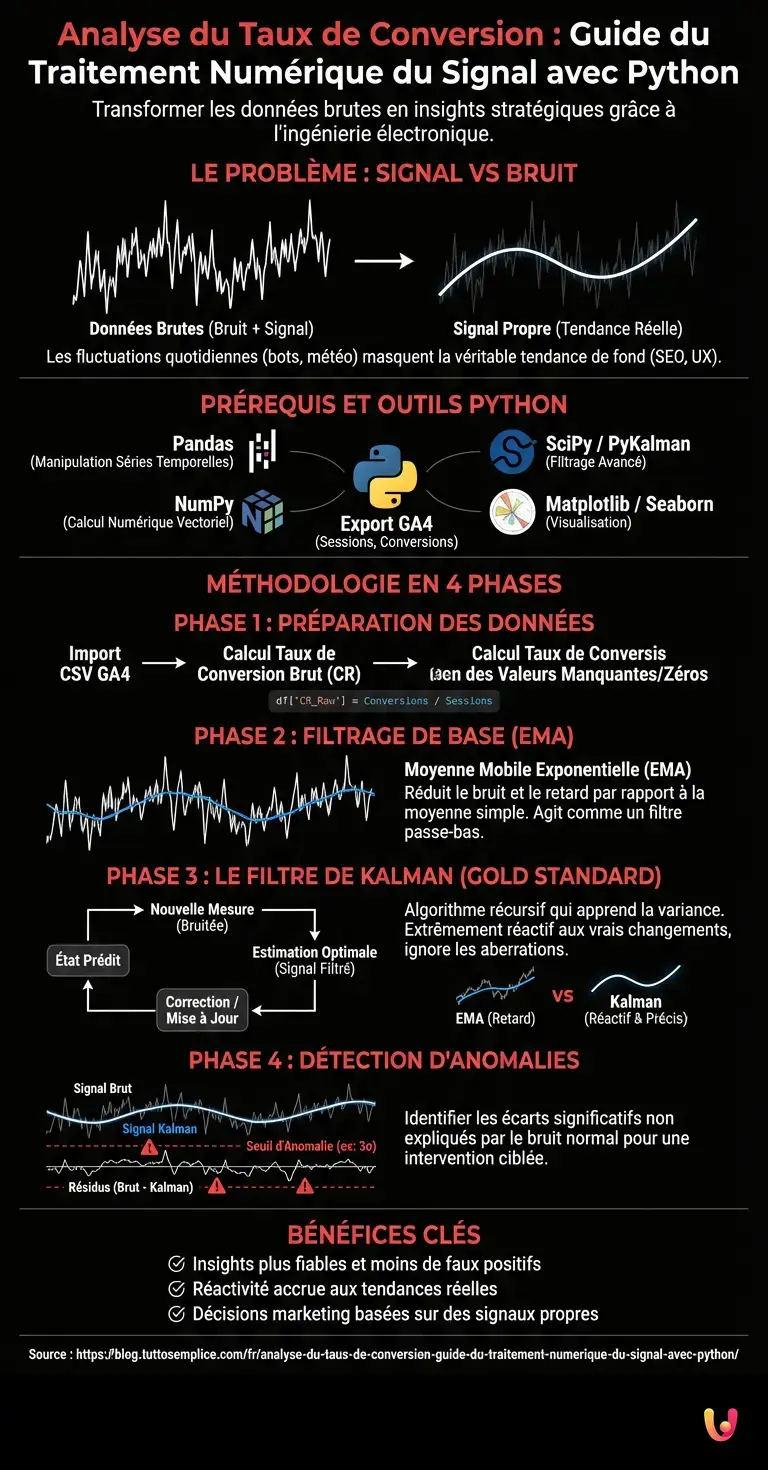

Dans le paysage actuel du marketing numérique, l’analyse du taux de conversion souffre souvent d’un problème fondamental : une mauvaise interprétation de la variance. Trop souvent, les marketeurs réagissent à des fluctuations quotidiennes aléatoires comme s’il s’agissait de tendances structurelles, conduisant à des décisions hâtives et coûteuses. Pour élever la qualité des insights, nous devons regarder au-delà des outils standards et puiser dans l’ingénierie électronique. Dans ce guide technique, nous explorerons comment traiter les données exportées de Google Analytics 4 non pas comme de simples chiffres sur un tableur, mais comme des signaux continus à traiter, filtrer et optimiser.

Le Problème : Signal vs Bruit en Marketing

Lorsque nous observons un graphique de l’évolution des conversions sur une base temporelle, ce que nous voyons est la somme de deux composantes :

- Le Signal (Signal) : La véritable tendance de fond déterminée par la qualité du trafic, le SEO et l’UX du site.

- Le Bruit (Noise) : Variations aléatoires dues aux bots, aux jours fériés, à la météo ou à la simple stochasticité du comportement humain.

L’approche classique se limite à calculer des moyennes simples. L’approche avancée, dérivée du Digital Signal Processing (DSP), applique des filtres mathématiques pour réduire le bruit et révéler la véritable nature du signal. Cela nous permet de répondre à la question : « La baisse d’hier est-elle une anomalie statistique ou le site a-t-il cessé de fonctionner ? ».

Prérequis et Stack Technologique

Pour suivre ce guide, un environnement de développement Python configuré est nécessaire. Nous utiliserons les bibliothèques suivantes, standards de facto en data science :

- Pandas : Pour la manipulation des séries temporelles.

- NumPy : Pour le calcul numérique vectoriel.

- SciPy / PyKalman : Pour l’implémentation des algorithmes de filtrage avancés.

- Matplotlib/Seaborn : Pour la visualisation des signaux.

Assurez-vous d’avoir un export CSV de vos données quotidiennes (Sessions et Conversions) depuis GA4.

Phase 1 : Préparation du Dataset

La première étape consiste à importer les données et à calculer le taux de conversion brut (CR). Souvent, les données brutes sont « sales » et discontinues.

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

# Chargement des données (simulation d'un export GA4)

# Le CSV doit avoir les colonnes : 'Date', 'Sessions', 'Conversions'

df = pd.read_csv('ga4_data_export.csv', parse_dates=['Date'])

df.set_index('Date', inplace=True)

# Calcul du Taux de Conversion (CR) Quotidien

# Nous gérons la division par zéro dans le cas de jours sans trafic

df['CR_Raw'] = np.where(df['Sessions'] > 0, df['Conversions'] / df['Sessions'], 0)

print(df.head())

Phase 2 : Filtres à Réponse Impulsionnelle Infinie (RII) – La Moyenne Mobile Exponentielle

Le premier niveau de nettoyage est l’application d’une Moyenne Mobile Exponentielle (EMA). Contrairement à la moyenne mobile simple (SMA), l’EMA attribue plus de poids aux données récentes, réduisant le retard (lag) dans la détection des tendances. En termes de DSP, cela agit comme un filtre passe-bas de base.

# Application d'une EMA avec une portée de 7 jours (cycle hebdomadaire)

df['CR_EMA'] = df['CR_Raw'].ewm(span=7, adjust=False).mean()

# Visualisation

plt.figure(figsize=(12,6))

plt.plot(df.index, df['CR_Raw'], label='CR Brut (Bruité)', alpha=0.3, color='gray')

plt.plot(df.index, df['CR_EMA'], label='EMA 7 Jours (Signal Propre)', color='blue')

plt.title('Analyse Taux de Conversion : Raw vs EMA')

plt.legend()

plt.show()

L’EMA est utile pour des visualisations rapides, mais souffre encore d’un retard intrinsèque. Si le taux de conversion s’effondre aujourd’hui, l’EMA mettra quelques jours pour refléter pleinement le changement.

Phase 3 : Le Filtre de Kalman (L’Approche Gold Standard)

Ici, nous entrons sur le territoire de l’ingénierie avancée. Le Filtre de Kalman est un algorithme récursif qui estime l’état interne d’un système dynamique linéaire à partir d’une série de mesures bruitées. C’est le même algorithme utilisé pour la navigation des missiles et le suivi GPS.

Dans l’analyse du taux de conversion, le filtre de Kalman considère le CR non pas comme un nombre fixe, mais comme une estimation probabiliste qui se met à jour constamment, équilibrant l’incertitude de la mesure (la donnée d’aujourd’hui) avec la prédiction du modèle (la tendance historique).

Implémentation Python du Filtre de Kalman

Nous utiliserons la bibliothèque pykalman (ou une implémentation personnalisée simplifiée) pour appliquer ce concept.

from pykalman import KalmanFilter

# Configuration du Filtre

# Transition Covariance : à quelle vitesse nous attendons-nous à ce que le vrai CR change

# Observation Covariance : combien de bruit y a-t-il dans les données quotidiennes

kf = KalmanFilter(transition_matrices=[1],

observation_matrices=[1],

initial_state_mean=df['CR_Raw'].mean(),

initial_state_covariance=1,

observation_covariance=0.01,

transition_covariance=0.001)

# Calcul des états (le signal filtré)

state_means, state_covariances = kf.filter(df['CR_Raw'].values)

df['CR_Kalman'] = state_means

Pourquoi le Kalman bat-il la Moyenne Mobile ?

En observant les résultats, vous remarquerez que la ligne du Kalman (CR_Kalman) est incroyablement plus réactive aux changements réels par rapport à la moyenne mobile, mais ignore presque complètement les valeurs aberrantes d’un seul jour (ex. une attaque de bots qui gonfle les sessions en abaissant le CR). Le filtre « apprend » la variance du système.

Phase 4 : Détection d’Anomalies et Prise de Décision

Maintenant que nous avons un signal propre, nous pouvons calculer les résidus, c’est-à-dire la différence entre la donnée brute et le signal filtré. C’est fondamental pour l’alerte automatique.

# Calcul des résidus

df['Residuo'] = df['CR_Raw'] - df['CR_Kalman']

# Définition seuil d'anomalie (ex. 3 écarts-types)

soglia = df['Residuo'].std() * 3

# Identification jours anormaux

anomalie = df[abs(df['Residuo']) > soglia]

print(f"Jours avec anomalies significatives : {len(anomalie)}")

Si le résidu dépasse le seuil, cela signifie qu’il s’est passé quelque chose qui ne peut être expliqué par le bruit statistique normal. C’est seulement dans ce cas que le Spécialiste SEO ou le Marketing Manager doit intervenir.

Conclusions et Applications SEO

L’application de la théorie des signaux à l’analyse du taux de conversion transforme la façon dont nous interprétons les données web. Au lieu de courir après des fantômes ou de réagir à la panique d’une seule journée négative, nous obtenons :

- Clarté : Visualisation de la véritable tendance de croissance épurée de la saisonnalité.

- Automatisation : Systèmes d’alerte basés sur des écarts-types réels, non sur des sensations.

- Attribution : Capacité de corréler des modifications On-Page (ex. mise à jour Core Web Vitals) avec des variations structurelles du signal.

Intégrer des scripts Python de ce type dans les tableaux de bord d’entreprise ou dans les rapports Looker Studio (via BigQuery) représente l’avenir du Web Analytics : moins d’opinions, plus de mathématiques.

Foire aux questions

L’approche classique de l’analyse des données souffre souvent d’une interprétation erronée de la variance, confondant les fluctuations quotidiennes aléatoires avec des tendances structurelles. En appliquant des filtres mathématiques dérivés de l’ingénierie électronique aux données de GA4, il est possible de séparer le signal réel, déterminé par le SEO et l’UX, du bruit de fond causé par les bots ou la stochasticité, obtenant ainsi des insights plus fiables.

Le Filtre de Kalman est un algorithme récursif supérieur car il estime l’état du système en équilibrant l’incertitude de la mesure actuelle avec la prédiction historique. Contrairement aux moyennes mobiles qui peuvent souffrir de retards ou de lags, cette méthode est extrêmement réactive aux changements réels de la tendance mais ignore presque complètement les valeurs aberrantes d’un seul jour, offrant une vision plus précise.

Pour identifier une anomalie significative, on calcule les résidus, c’est-à-dire la différence mathématique entre la donnée brute et le signal filtré par l’algorithme. Si cette valeur dépasse un seuil statistique prédéfini, généralement calculé sur trois écarts-types, on est face à un événement anormal qui nécessite une intervention technique ou stratégique, excluant les faux positifs.

Pour répliquer la stack technologique décrite, Pandas est essentiel pour la manipulation des séries temporelles et NumPy pour le calcul numérique vectoriel. Pour la partie algorithmique avancée, on utilise SciPy ou PyKalman pour les filtres, tandis que Matplotlib et Seaborn sont fondamentaux pour visualiser graphiquement la distinction entre le signal propre et les données brutes bruitées.

La Moyenne Mobile Exponentielle, ou EMA, se différencie de la moyenne simple car elle attribue un poids plus important aux données les plus récentes. Ce mécanisme agit comme un filtre passe-bas qui réduit considérablement le retard dans la détection des tendances, permettant aux marketeurs de réagir plus rapidement aux changements structurels sans être trompés par la volatilité quotidienne.

Encore des doutes sur Analyse du Taux de Conversion : Guide du Traitement Numérique du Signal avec Python?

Tapez votre question spécifique ici pour trouver instantanément la réponse officielle de Google.

Avez-vous trouvé cet article utile ? Y a-t-il un autre sujet que vous aimeriez que je traite ?

Écrivez-le dans les commentaires ci-dessous ! Je m’inspire directement de vos suggestions.