En Bref (TL;DR)

L’adoption d’architectures hybrides sur AWS et GCP garantit la résilience opérationnelle requise par les réglementations comme le règlement DORA.

La gestion des données nécessite un équilibre stratégique entre cohérence et disponibilité en appliquant le théorème CAP aux configurations Actif-Actif ou Actif-Passif.

L’orchestration via Kubernetes et l’approche GitOps assurent un déploiement agnostique et efficace, atténuant les risques de latence entre différents fournisseurs.

Le diable est dans les détails. 👇 Continuez à lire pour découvrir les étapes critiques et les conseils pratiques pour ne pas vous tromper.

Dans le paysage fintech de 2026, l’architecture multi-cloud bancaire n’est plus une option exotique, mais une norme de facto pour garantir la résilience opérationnelle requise par les réglementations internationales (comme le règlement DORA dans l’UE). La dépendance à un seul fournisseur de Cloud représente aujourd’hui un Single Point of Failure (SPOF) inacceptable pour des services critiques comme les comparateurs de prêts hypothécaires en temps réel ou les Core Banking Systems.

Ce guide technique explore comment concevoir, mettre en œuvre et maintenir une infrastructure hybride distribuée entre Amazon Web Services (AWS) et Google Cloud Platform (GCP). Nous analyserons les défis d’ingénierie liés à la synchronisation des données, l’orchestration via Kubernetes et l’application des théorèmes fondamentaux des systèmes distribués pour équilibrer cohérence et disponibilité.

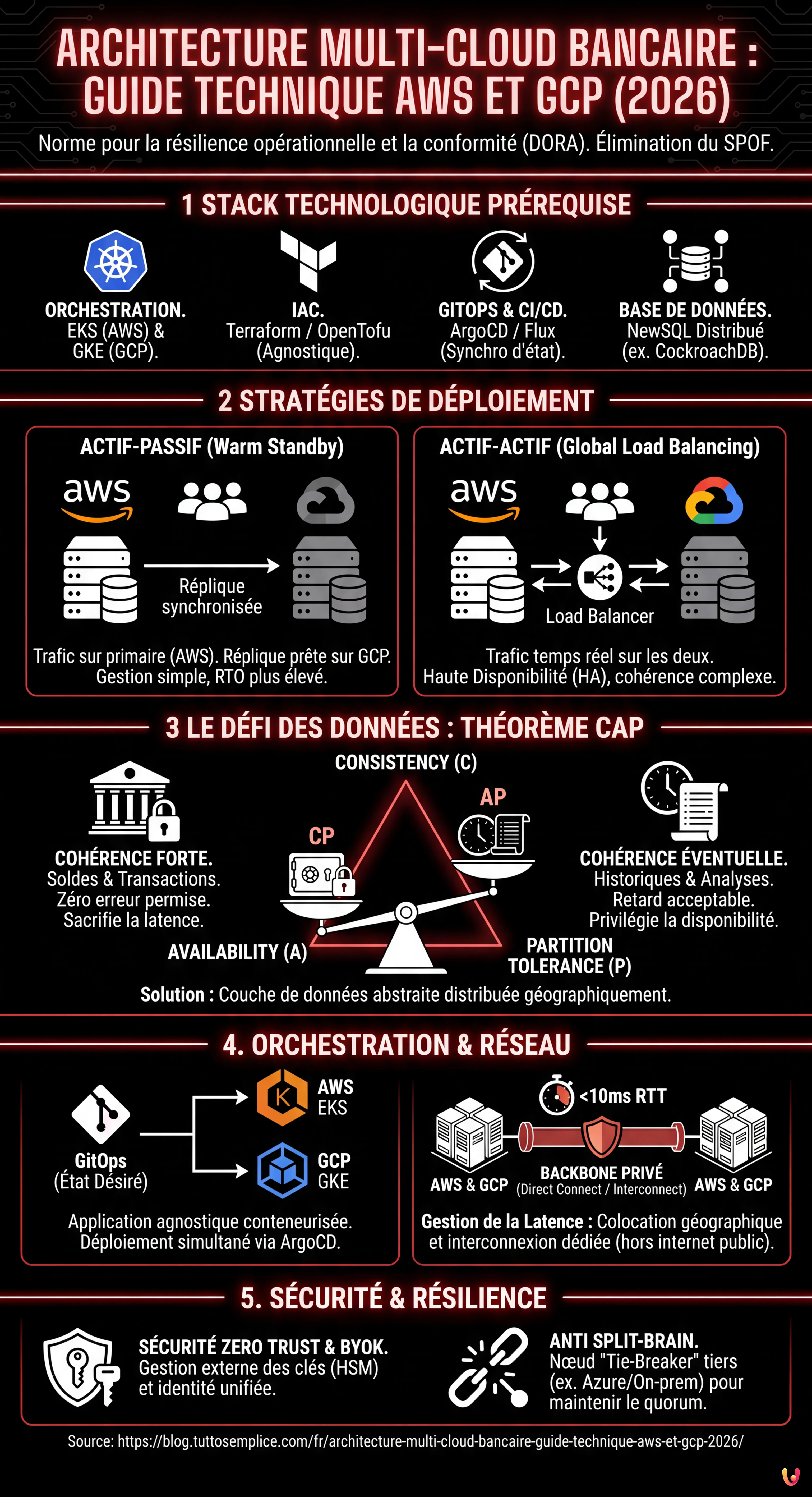

Prérequis et Stack Technologique

Pour mettre en œuvre les stratégies décrites, la connaissance et l’utilisation des composants suivants sont supposées :

- Orchestration : Kubernetes (EKS sur AWS, GKE sur GCP).

- IaC (Infrastructure as Code) : Terraform ou OpenTofu pour le provisionnement agnostique.

- CI/CD & GitOps : ArgoCD ou Flux pour la synchronisation de l’état des clusters.

- Réseau : AWS Direct Connect et Google Cloud Interconnect, gérés via BGP.

- Base de données : Solutions NewSQL distribuées (ex. CockroachDB) ou stratégies de réplication personnalisées.

1. Stratégies de Déploiement : Actif-Actif vs Actif-Passif

Le choix entre une configuration Actif-Actif et Actif-Passif définit l’ensemble de l’architecture multi-cloud bancaire. Dans le contexte financier, où le RPO (Recovery Point Objective) doit tendre vers zéro, les défis changent radicalement.

Scénario Actif-Passif (Warm Standby)

Dans ce scénario, AWS pourrait gérer le trafic primaire tandis que GCP maintient une réplique synchronisée de l’infrastructure, prête à monter en charge en cas de basculement (failover). C’est le choix conservateur pour réduire les coûts et la complexité de la gestion des conflits d’écriture.

- Pour : Simplicité dans la gestion de la cohérence des données (écriture sur un seul maître).

- Contre : Temps de RTO (Recovery Time Objective) plus élevés dus au temps de « chauffe » de la région secondaire.

Scénario Actif-Actif (Global Load Balancing)

Les deux fournisseurs servent le trafic en temps réel. C’est la configuration idéale pour la haute disponibilité (HA), mais elle introduit le défi complexe de la cohérence des données bidirectionnelle.

2. Le Défi des Données : Théorème CAP et Cohérence Éventuelle

Selon le Théorème CAP (Consistency, Availability, Partition Tolerance), en présence d’une partition réseau (P) entre AWS et GCP, un système bancaire doit choisir entre la Cohérence (C) et la Disponibilité (A).

Pour un système bancaire, le choix n’est pas binaire mais contextuel :

- Soldes et Transactions (Strong Consistency) : Nous ne pouvons pas permettre qu’un utilisateur dépense le même argent deux fois sur deux clouds différents. Ici, on sacrifie la latence ou la disponibilité pour garantir la cohérence (CP). On utilise des protocoles de consensus distribué comme Raft ou Paxos.

- Historique des Mouvements ou Analyse des Prêts (Eventual Consistency) : Il est acceptable que l’historique apparaisse avec quelques millisecondes de retard sur la région secondaire. Ici, nous privilégions la disponibilité (AP).

Implémentation Technique de la Synchronisation

Pour atténuer les risques de latence et de split-brain, l’approche moderne prévoit l’utilisation d’un Data Layer abstrait. Au lieu d’utiliser RDS (AWS) et Cloud SQL (GCP) nativement, on implémente des clusters de bases de données distribuées géographiquement comme CockroachDB ou YugabyteDB qui opèrent transversalement aux fournisseurs de cloud, gérant nativement la réplication synchrone et asynchrone.

3. Orchestration Agnostique avec Kubernetes

Pour éviter le vendor lock-in, l’application doit être conteneurisée et agnostique par rapport à l’infrastructure sous-jacente. Kubernetes agit comme une couche d’abstraction.

Gestion Multi-Cluster avec GitOps

Nous ne gérerons pas les clusters de manière impérative. En utilisant une approche GitOps avec ArgoCD, nous pouvons définir l’état souhaité de l’application dans un dépôt Git. ArgoCD se chargera d’appliquer les configurations simultanément sur EKS (AWS) et GKE (GCP).

# Exemple conceptuel d'ApplicationSet dans ArgoCD

apiVersion: argoproj.io/v1alpha1

kind: ApplicationSet

metadata:

name: banking-core-app

spec:

generators:

- list:

elements:

- cluster: aws-eks-prod

region: eu-central-1

- cluster: gcp-gke-prod

region: europe-west3

template:

# Configuration du déploiement...4. Réseau et Gestion de la Latence

La latence entre les fournisseurs de cloud est l’ennemi numéro un des architectures distribuées. Une transaction nécessitant un commit synchrone sur deux clouds différents subira inévitablement la latence du « round-trip time » (RTT) entre les centres de données.

Stratégies d’Atténuation

- Colocation Géographique : Sélectionner des régions AWS (ex. Francfort) et GCP (ex. Francfort) physiquement proches pour minimiser le RTT à < 10ms.

- Backbone Privé : Éviter l’internet public pour la synchronisation des bases de données. Utiliser des VPN Site-to-Site ou des solutions d’interconnexion dédiées via des partenaires neutres (ex. Equinix Fabric) qui relient AWS Direct Connect et Google Cloud Interconnect.

- Service Mesh (Istio/Linkerd) : Implémenter un Service Mesh fédéré pour gérer le routage intelligent du trafic, le basculement automatique des appels API et le mTLS (Mutual TLS) cross-cloud pour la sécurité.

5. Sécurité et Conformité (DORA & RGPD)

Dans une architecture multi-cloud bancaire, la surface d’attaque augmente. La sécurité doit être gérée selon le modèle Zero Trust.

- Gestion des Clés (BYOK) : Utiliser un système de gestion des clés externe (HSM en colocation ou services comme HashiCorp Vault) pour garder le contrôle des clés de chiffrement indépendamment du fournisseur de cloud.

- Identité Unifiée : Fédérer les identités (IAM) en utilisant un fournisseur d’identité central (ex. Okta ou Azure AD) pour garantir que les permissions sont cohérentes sur AWS et GCP.

6. Dépannage et Résolution de Problèmes Courants

Problème : Split-Brain dans la Base de Données

Symptôme : Les deux clouds perdent la connexion entre eux et acceptent tous deux des écritures divergentes.

Solution : Implémenter un « Tie-Breaker » ou un nœud observateur dans un troisième emplacement (ex. Azure ou un centre de données sur site) pour maintenir le quorum impair nécessaire aux protocoles de consensus.

Problème : Coûts d’Egress (Sortie de Données)

Symptôme : Factures élevées dues à la synchronisation continue des données entre AWS et GCP.

Solution : Optimiser la réplication des données. Ne répliquer que les données transactionnelles critiques en temps réel. Utiliser la compression et la déduplication. Négocier des tarifs d’egress dédiés avec les fournisseurs pour le trafic inter-région.

Conclusions

Construire une architecture multi-cloud bancaire nécessite un changement de paradigme : on passe de la gestion de serveurs à la gestion de services distribués. Bien que la complexité opérationnelle augmente, le gain en termes de résilience, de souveraineté des données et de pouvoir de négociation face aux fournisseurs justifie l’investissement pour les institutions financières modernes. La clé du succès réside dans l’automatisation rigoureuse (GitOps) et une compréhension profonde des modèles de cohérence des données.

Foire aux questions

L’adoption d’une architecture multi-cloud est devenue une norme de facto pour les institutions financières, principalement pour garantir la résilience opérationnelle et la conformité réglementaire. Des règlements comme le DORA dans l’Union européenne exigent d’atténuer les risques liés à la dépendance envers un seul fournisseur technologique. En utilisant plusieurs fournisseurs comme AWS et GCP, les banques éliminent le Single Point of Failure, assurant que des services critiques comme les Core Banking Systems restent opérationnels même en cas de pannes graves d’un fournisseur de cloud entier, augmentant ainsi la souveraineté sur les données et la continuité du service.

Le choix entre ces deux stratégies définit l’équilibre entre les coûts, la complexité et les temps de récupération. Dans la configuration Actif-Passif, un cloud gère le trafic tandis que l’autre maintient une réplique prête à prendre le relais, offrant une gestion plus simple de la cohérence des données mais des temps de rétablissement plus longs. À l’inverse, le scénario Actif-Actif distribue le trafic en temps réel sur les deux fournisseurs ; cette solution est idéale pour la haute disponibilité et pour réduire à zéro les temps d’arrêt, mais elle nécessite une gestion complexe de la synchronisation bidirectionnelle des données pour éviter les conflits d’écriture.

La gestion des données dans un environnement distribué repose sur le Théorème CAP, qui impose un choix contextuel entre cohérence et disponibilité en cas de partition réseau. Pour les données critiques comme les soldes et les transactions, il faut privilégier la cohérence forte en sacrifiant la latence, en utilisant des protocoles de consensus distribué. Pour les données moins sensibles, comme l’historique des mouvements, on peut opter pour une cohérence éventuelle. Technologiquement, cela se résout souvent en abstrayant la couche de données avec des bases de données distribuées géographiquement, comme CockroachDB, qui gèrent nativement la réplication entre différents fournisseurs.

La latence est le principal défi des architectures distribuées. Pour l’atténuer, la colocation géographique est fondamentale, c’est-à-dire sélectionner des régions des différents fournisseurs physiquement proches, comme Francfort pour les deux, afin de maintenir le temps de réponse sous les 10 millisecondes. De plus, il est déconseillé d’utiliser l’internet public pour la synchronisation des bases de données ; on préfère des backbones privés ou des solutions d’interconnexion dédiées via des partenaires neutres. L’utilisation d’un Service Mesh fédéré aide enfin à gérer le routage intelligent du trafic pour optimiser les performances.

Le Split-Brain se produit lorsque deux clouds perdent la connexion entre eux et commencent à accepter des écritures divergentes de manière indépendante. La solution technique standard prévoit l’implémentation d’un nœud observateur ou Tie-Breaker positionné dans un troisième emplacement neutre, qui peut être un autre fournisseur de cloud comme Azure ou un centre de données sur site. Ce troisième nœud sert à maintenir le quorum impair nécessaire aux protocoles de consensus, permettant au système de décider quelle version des données est la correcte et prévenant la corruption de la base de données.

Sources et Approfondissements

- Journal officiel de l’UE : Règlement (UE) 2022/2554 sur la résilience opérationnelle numérique du secteur financier (DORA)

- Autorité bancaire européenne (EBA) : Orientations sur les accords d’externalisation et le Cloud

- Wikipédia : Théorème CAP (Cohérence, Disponibilité, Tolérance au partitionnement)

- National Institute of Standards and Technology (NIST) : La définition standard du Cloud Computing

Avez-vous trouvé cet article utile ? Y a-t-il un autre sujet que vous aimeriez que je traite ?

Écrivez-le dans les commentaires ci-dessous ! Je m'inspire directement de vos suggestions.