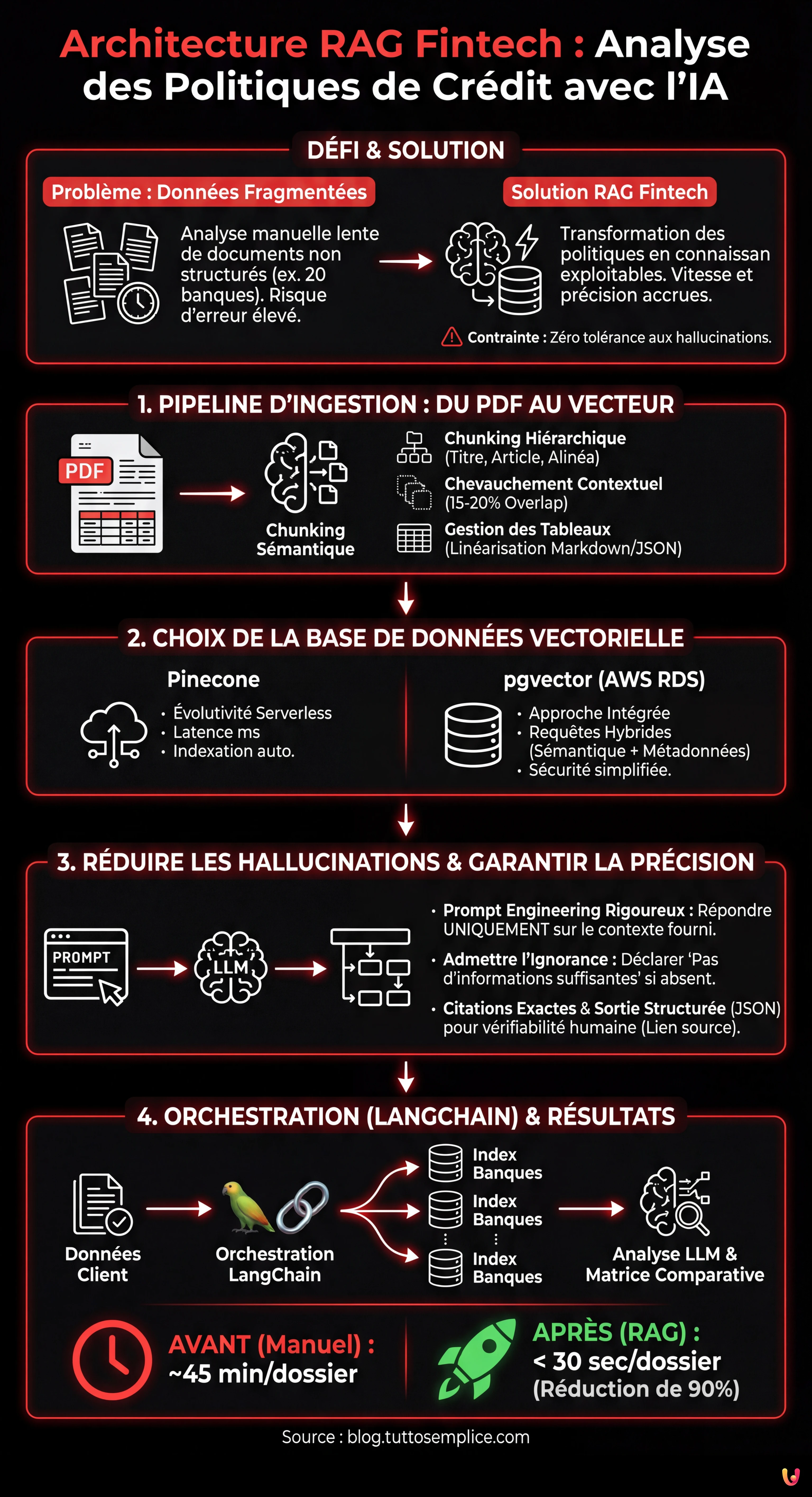

Dans le paysage financier actuel, la vitesse de traitement de l’information est devenue un avantage concurrentiel crucial. Pour les sociétés de courtage en crédit et les banques, le principal défi n’est pas le manque de données, mais leur fragmentation dans des documents non structurés. La mise en œuvre d’une architecture RAG fintech (Retrieval-Augmented Generation) représente la solution ultime pour transformer les manuels opérationnels et les politiques d’octroi de prêts en connaissances exploitables.

Imaginez un scénario courant : un courtier doit vérifier la faisabilité d’un prêt immobilier pour un client ayant des revenus étrangers en consultant les politiques de 20 établissements différents. Manuellement, cela nécessite des heures. Avec un système RAG bien conçu, comme le démontre l’évolution des plateformes CRM avancées de type BOMA, le temps est réduit à quelques secondes. Cependant, le secteur financier ne tolère aucune erreur : une hallucination du modèle linguistique (LLM) peut conduire à une décision erronée et à des risques de conformité.

Ce guide technique explore comment construire un pipeline RAG robuste, en se concentrant sur les spécificités du domaine bancaire : de la gestion des PDF complexes à la citation rigoureuse des sources.

Pipeline d’Ingestion : Du PDF au Vecteur

Le cœur d’une architecture RAG fintech efficace réside dans la qualité des données en entrée. Les politiques bancaires sont souvent distribuées au format PDF, riches en tableaux (ex. grilles LTV/Revenus), notes de bas de page et clauses juridiques interdépendantes. Un simple analyseur de texte échouerait à préserver la structure logique nécessaire.

Stratégies de Chunking Sémantique

Diviser le texte en segments (chunking) est une étape critique. Dans le contexte du crédit, couper un paragraphe en deux peut altérer le sens d’une règle d’exclusion. Selon les meilleures pratiques actuelles pour le traitement documentaire :

- Chunking Hiérarchique : Au lieu de diviser par un nombre fixe de tokens, il est essentiel de respecter la structure du document (Titre, Article, Alinéa). L’utilisation de bibliothèques comme LangChain ou LlamaIndex permet de configurer des splitters qui reconnaissent les en-têtes des documents juridiques.

- Chevauchement Contextuel (Overlap) : Il est conseillé de maintenir un chevauchement de 15 à 20 % entre les chunks pour garantir que le contexte ne se perde pas aux marges de la coupure.

- Gestion des Tableaux : Les tableaux doivent être extraits, linéarisés au format markdown ou JSON et incorporés comme unités sémantiques uniques. Si un tableau est brisé, le modèle ne sera pas en mesure d’associer correctement les lignes et les colonnes lors de la phase de récupération (retrieval).

Choix de la Base de Données Vectorielle : Pinecone vs pgvector

Une fois les chunks transformés en vecteurs numériques (embedding), il est nécessaire de les archiver dans une base de données vectorielle. Le choix de l’infrastructure impacte la latence et les coûts.

Pinecone : Évolutivité Serverless

Pour les projets nécessitant une mise en production rapide et une évolutivité automatique, Pinecone reste une référence standard. Son architecture serverless gère automatiquement l’indexation et offre des temps de réponse de l’ordre de la milliseconde, essentiels pour une expérience utilisateur fluide dans un CRM.

pgvector sur AWS RDS : L’Approche Intégrée

Cependant, pour les institutions financières qui utilisent déjà PostgreSQL sur AWS RDS pour les données transactionnelles, l’extension pgvector offre des avantages significatifs. Maintenir les vecteurs dans la même base de données que les données clients simplifie la gestion de la sécurité et permet des requêtes hybrides (ex. filtrer les vecteurs non seulement par similarité sémantique, mais aussi par métadonnées relationnelles comme "ID Banque" ou "Date Validité Politique"). Cela réduit la complexité de l’infrastructure et les coûts de sortie de données (data egress).

Réduire les Hallucinations : Prompt Engineering et Citations

Dans le domaine fintech, la précision n’est pas négociable. Une architecture RAG fintech doit être conçue pour admettre l’ignorance plutôt que d’inventer une réponse. L’ingénierie du prompt joue ici un rôle fondamental.

Il est nécessaire de mettre en œuvre un System Prompt rigoureux qui instruit le modèle à :

- Répondre exclusivement en se basant sur le contexte fourni (les chunks récupérés).

- Déclarer "Je n’ai pas d’informations suffisantes" si la politique ne couvre pas le cas spécifique.

- Fournir la citation exacte (ex. "Page 12, Article 4.2").

Techniquement, cela s’obtient en structurant la sortie du LLM non pas comme du texte libre, mais comme un objet structuré (JSON) qui doit contenir des champs séparés pour la réponse et pour les références à la source. Cela permet au frontend de l’application d’afficher à l’opérateur le lien direct vers le PDF original, garantissant la vérifiabilité humaine de la donnée.

Orchestration avec LangChain : Le Cas d’Usage Pratique

L’orchestration finale se fait via des frameworks comme LangChain, qui relient la récupération au modèle génératif. Dans un cas d’usage réel pour la pré-qualification de prêts immobiliers, le flux opérationnel est le suivant :

L’utilisateur saisit les données du client (ex. "Travailleur indépendant, régime forfaitaire, LTV 80%"). Le système convertit cette requête en un vecteur et interroge simultanément les index vectoriels de 20 établissements de crédit. Le système récupère les 3 chunks les plus pertinents pour chaque banque.

Ensuite, le LLM analyse les chunks récupérés pour déterminer l’éligibilité. Le résultat est une matrice comparative générée en temps réel, qui met en évidence quelles banques accepteraient le dossier et avec quelles limitations. Selon les données relevées lors du développement de solutions similaires, cette approche réduit les temps de pré-qualification de 90 %, passant d’une analyse manuelle de 45 minutes à une sortie automatique en moins de 30 secondes.

Conclusions

La mise en œuvre d’une architecture RAG fintech pour l’analyse des politiques de crédit n’est pas seulement un exercice technologique, mais un levier stratégique pour l’efficacité opérationnelle. La clé du succès ne réside pas dans le modèle de langage le plus puissant, mais dans le soin apporté au pipeline d’ingestion des données et dans la gestion rigoureuse du contexte. En utilisant des stratégies de chunking sémantique et des bases de données vectorielles optimisées, il est possible de créer des assistants virtuels qui non seulement comprennent le langage bancaire, mais agissent comme garants de la conformité, offrant des réponses précises, vérifiées et traçables.

Avez-vous trouvé cet article utile ? Y a-t-il un autre sujet que vous aimeriez que je traite ?

Écrivez-le dans les commentaires ci-dessous ! Je m'inspire directement de vos suggestions.