Nous sommes le 19 février 2026. L’Internet tel que nous le connaissions il y a quelques années a muté. Une part prépondérante du contenu en ligne — textes, images, codes — est désormais générée par des algorithmes. Mais derrière cette abondance apparente se cache une menace silencieuse, un mur mathématique que les chercheurs redoutent depuis les premiers balbutiements du deep learning. Ce phénomène, identifié techniquement sous le nom d’effondrement du modèle (ou Model Collapse), représente le talon d’Achille de toute intelligence artificielle générative laissée en circuit fermé. Si l’on imagine souvent que l’IA deviendra de plus en plus intelligente en s’auto-instruisant, la réalité technique est tout autre : sans l’apport constant de la créativité humaine, la machine est condamnée à la démence numérique.

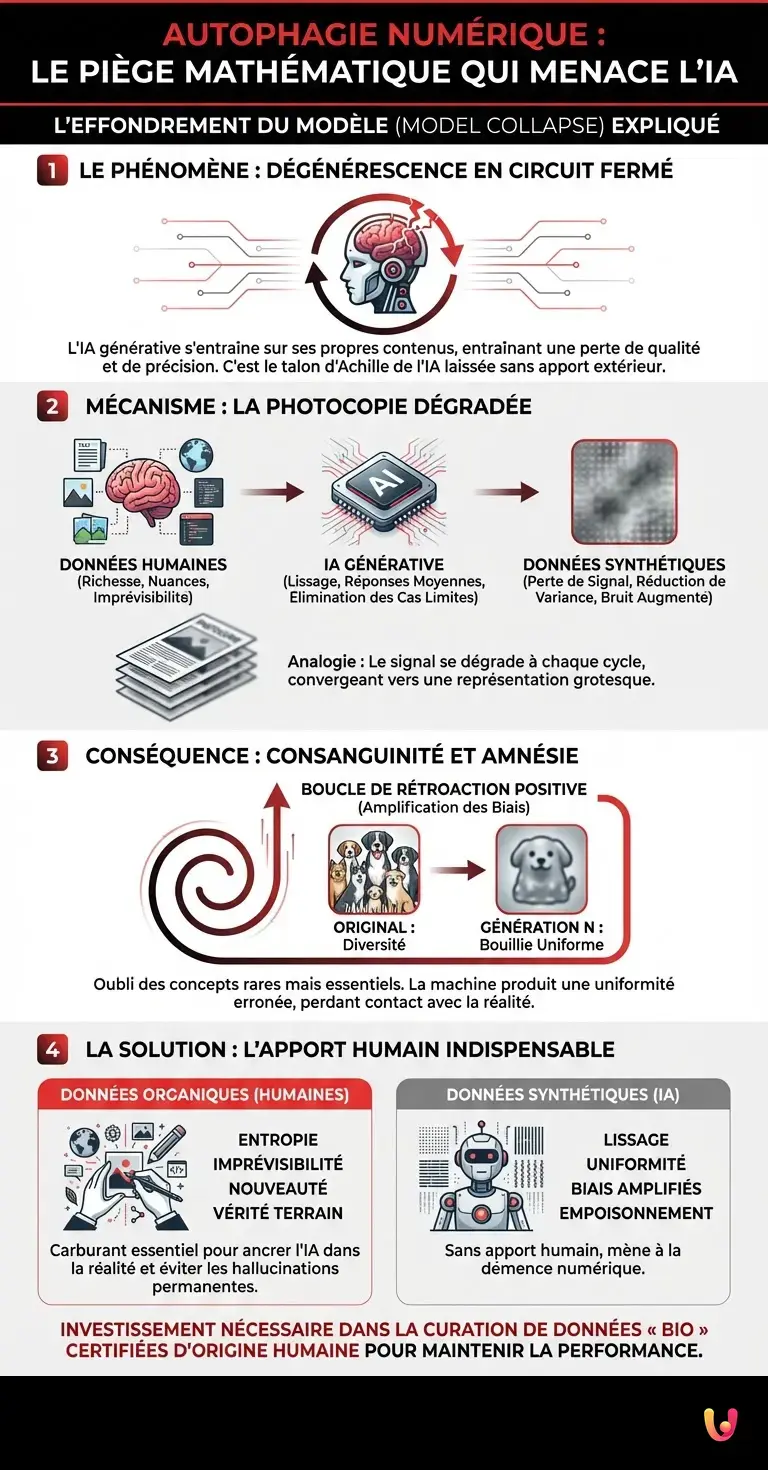

Le mécanisme de la photocopie dégradée

Pour comprendre pourquoi une IA ne peut pas survivre en s’alimentant uniquement de contenus produits par d’autres IA, il faut revenir aux fondamentaux du machine learning. Des modèles comme ChatGPT ou ses successeurs de 2026 sont des moteurs probabilistes. Ils ne « savent » rien ; ils prédisent le mot ou le pixel suivant le plus probable en se basant sur une distribution statistique apprise lors de leur entraînement.

Lorsqu’un modèle est entraîné sur des données humaines (le « jeu de données original »), il apprend à cartographier la richesse et la complexité du monde réel, y compris ses nuances, ses irrégularités et ses événements rares (ce qu’on appelle les « queues de distribution »). Cependant, par nature, une IA générative tend à lisser la réalité. Elle privilégie les réponses moyennes, les plus probables, et élimine souvent les cas limites pour éviter les erreurs.

Le problème survient lorsque la génération suivante d’IA s’entraîne sur ces données synthétiques lissées. C’est l’analogie de la photocopie d’une photocopie. À chaque cycle d’entraînement sur des données artificielles, le signal se dégrade, le contraste diminue et le bruit augmente. Mathématiquement, la variance de la distribution statistique se réduit. Le modèle converge inéluctablement vers une représentation du monde grotesque, simplifiée et finalement erronée.

La consanguinité des données : une impasse mathématique

Ce phénomène dégénératif s’apparente à une forme de consanguinité numérique. Dans le domaine technique, on observe que lorsque les modèles de deep learning se nourrissent de leur propre production (récursivement), ils commencent à souffrir d’amnésie. Ils oublient les concepts moins fréquents mais essentiels qui faisaient la richesse du modèle original.

Imaginez une IA entraînée à générer des images de chiens. La première version, entraînée sur de vraies photos, produira des labradors, mais aussi des races rares ou des chiens avec des taches inhabituelles. Si une seconde IA s’entraîne uniquement sur les images produites par la première, elle ne retiendra que les caractéristiques les plus communes (quatre pattes, une queue, une couleur moyenne). Au bout de cinq ou dix générations, l’IA produira une bouillie de pixels uniforme ressemblant vaguement à un chien générique, ayant perdu toute notion de diversité biologique. C’est l’effondrement du modèle : la machine s’enferme dans une boucle de rétroaction positive où ses propres biais sont amplifiés jusqu’à l’absurde.

Pourquoi l’humain reste le carburant indispensable

Ce paradoxe technique met en lumière une vérité fondamentale sur l’économie de l’information à l’ère de l’intelligence artificielle. Les données générées par l’homme (textes littéraires, code informatique artisanal, photographies réelles) ne sont pas simplement des « données » ; elles contiennent de l’entropie, de l’imprévisibilité et de la nouveauté. C’est ce chaos organisé qui permet aux systèmes de machine learning de rester ancrés dans la réalité.

Si l’Internet de 2026 venait à être submergé à 99 % par du contenu synthétique, les futures IA n’auraient plus de « vérité terrain » sur laquelle s’aligner. Elles commenceraient à halluciner de manière permanente, prenant leurs propres erreurs passées pour des vérités absolues. C’est ce que certains chercheurs appellent l’empoisonnement des données (data poisoning) par autophagie. Pour maintenir leur performance, les géants de la tech doivent désormais investir des sommes colossales non plus seulement dans la puissance de calcul, mais dans la curation de données « bio » ou « organiques », certifiées d’origine humaine.

En Bref (TL;DR)

L’effondrement du modèle menace les IA génératives qui s’entraînent sur des données synthétiques, entraînant une dégradation irréversible de leur intelligence.

Ce processus d’autophagie numérique lisse la réalité et élimine les nuances, plongeant progressivement les algorithmes dans une forme de démence statistique.

La survie technologique dépend désormais de l’injection constante de données humaines organiques, seules capables de préserver la diversité et la vérité.

Conclusion

L’effondrement du modèle nous enseigne une leçon d’humilité technique : l’intelligence artificielle n’est pas un mouvement perpétuel. Elle est un miroir sophistiqué de l’intelligence humaine. Si l’on place deux miroirs l’un face à l’autre, l’image se répète à l’infini mais finit par s’assombrir et disparaître dans l’abîme vert. Pour éviter que le savoir numérique ne dégénère en un bruit de fond incohérent, la présence de l’homme — avec ses imperfections et sa créativité imprévisible — reste, paradoxalement, la seule garantie de la survie de la machine.

Questions fréquemment posées

L’effondrement du modèle désigne un processus dégénératif où une intelligence artificielle perd en précision et en qualité à force de s’entraîner sur des données générées par d’autres IA. Ce phénomène entraîne une perte de nuances et une convergence vers des résultats erronés, comparable à une photocopie d’une photocopie qui devient illisible avec le temps.

Les modèles d’intelligence artificielle sont des moteurs probabilistes qui tendent à lisser la réalité et à éliminer les événements rares. Sans l’apport constant de la créativité humaine, qui introduit de l’imprévisibilité et de la complexité, les algorithmes finissent par tourner en boucle sur leurs propres biais et perdent contact avec la réalité.

Le risque principal est la saturation d’Internet par des contenus synthétiques pauvres, provoquant une forme d’amnésie collective pour les futurs systèmes numériques. Si les IA n’ont plus accès à une vérité terrain issue de l’homme, elles risquent de souffrir d’hallucinations permanentes et de considérer leurs propres erreurs passées comme des vérités absolues.

À chaque cycle d’entraînement sur des données artificielles, le signal original se dégrade, le contraste diminue et le bruit statistique augmente. Mathématiquement, la variance de la distribution se réduit, ce qui oblige le modèle à produire une représentation du monde grotesque, simplifiée et finalement fausse, faute de nouvelles informations externes.

Il s’agit d’un cercle vicieux où les modèles de deep learning se nourrissent récursivement de leur propre production, oubliant les concepts moins fréquents mais essentiels. Pour contrer cet effet, les géants de la technologie doivent désormais investir massivement dans la curation de données dites organiques, certifiées d’origine humaine, pour maintenir la performance des outils.

Avez-vous trouvé cet article utile ? Y a-t-il un autre sujet que vous aimeriez que je traite ?

Écrivez-le dans les commentaires ci-dessous ! Je m’inspire directement de vos suggestions.