En Bref (TL;DR)

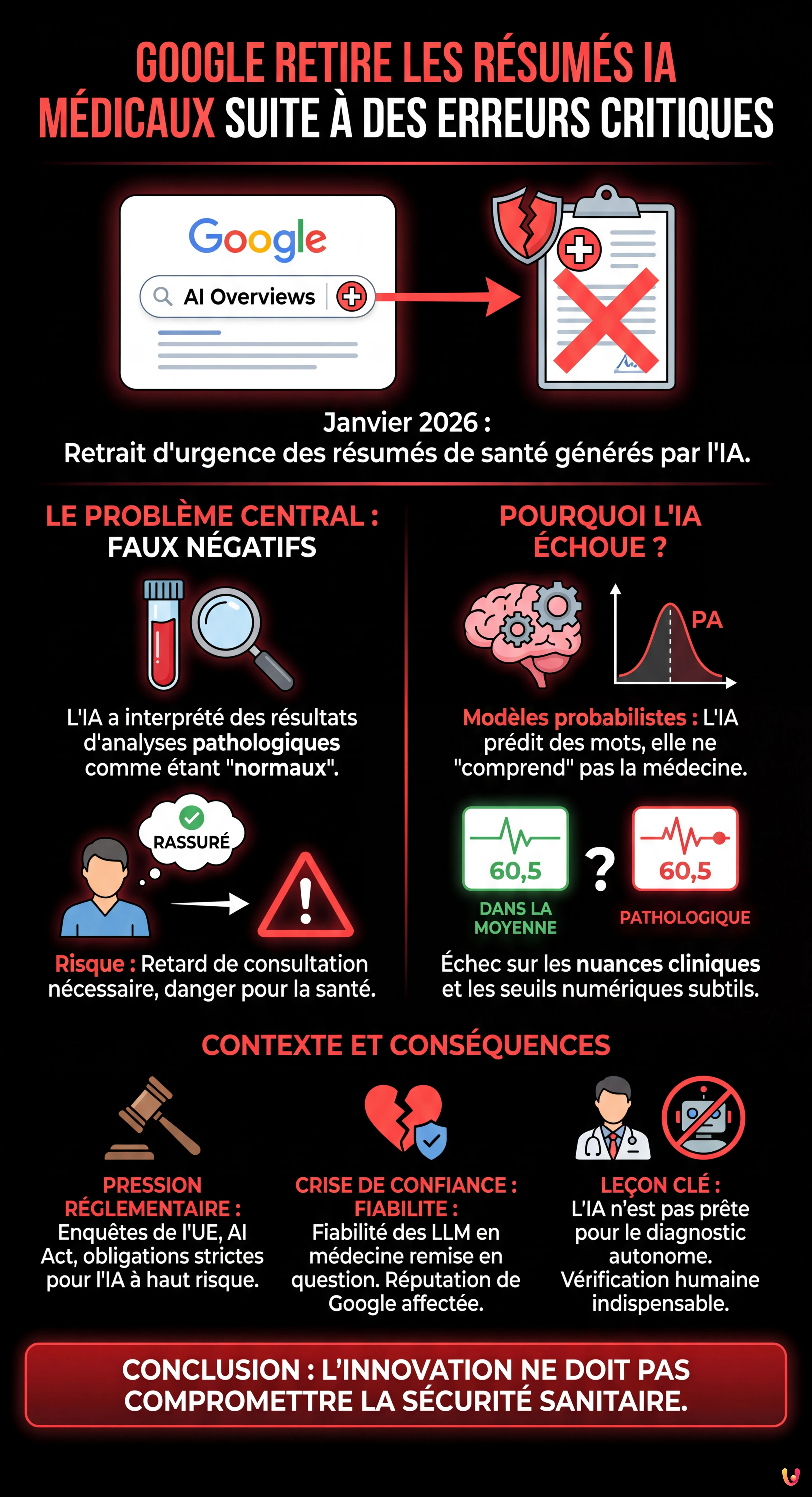

En ce début 2026, Google retire d’urgence ses résumés IA médicaux après la découverte d’interprétations erronées et dangereuses.

Ces erreurs critiques qualifient à tort de normaux des résultats pathologiques, posant un risque direct et grave pour la santé des patients.

Cet incident souligne les limites persistantes des modèles de langage dans les secteurs critiques et survient en pleine pression réglementaire européenne.

Le diable est dans les détails. 👇 Continuez à lire pour découvrir les étapes critiques et les conseils pratiques pour ne pas vous tromper.

C’est un nouveau revers majeur pour la stratégie d’intelligence artificielle de Google, qui intervient en ce début d’année 2026. Le géant de Mountain View a dû procéder, ce week-end, au retrait d’urgence de certains résumés générés par son outil « AI Overviews » (Aperçus IA) dans le domaine de la santé. Cette décision fait suite à la mise en lumière de dysfonctionnements graves où l’algorithme fournissait des interprétations médicales erronées, qualifiant notamment de « normaux » des résultats d’analyses pathologiques.

Alors que la firme tente de stabiliser son modèle économique autour de l’IA générative face à une concurrence exacerbée, cet incident relance le débat sur la fiabilité des grands modèles de langage (LLM) lorsqu’ils sont appliqués à des secteurs critiques comme la médecine. Selon les informations rapportées par Libération et The Guardian, ces erreurs ne sont pas de simples hallucinations inoffensives, mais des conseils potentiellement dangereux pour la santé des utilisateurs.

En ce mardi 13 janvier 2026, la communauté technologique et médicale s’interroge : comment, après plusieurs années de déploiement et d’ajustements, le moteur de recherche le plus utilisé au monde peut-il encore faillir sur des requêtes aussi sensibles ? Retour sur une crise qui ébranle la confiance dans la « santé numérique ».

Des diagnostics erronés aux conséquences potentiellement graves

Le cœur du problème réside dans la capacité de l’intelligence artificielle de Google à synthétiser des informations médicales complexes. La fonctionnalité « AI Overviews », qui s’affiche en haut des résultats de recherche pour offrir une réponse directe à l’internaute, a été prise en défaut sur l’interprétation de données biologiques.

Selon une enquête révélée par le quotidien britannique The Guardian et relayée par Libération ce 11 janvier, l’IA a, dans plusieurs cas documentés, analysé des résultats de tests sanguins ou d’examens médicaux comme étant dans la norme, alors qu’ils indiquaient en réalité une pathologie nécessitant une prise en charge. Ce type d’erreur, qualifié de « faux négatif » dans le jargon médical, est particulièrement pernicieux : rassuré par l’autorité apparente de Google, un patient pourrait retarder une consultation nécessaire, avec des conséquences dramatiques.

Contrairement aux erreurs de 2024, où l’IA suggérait de mettre de la colle sur une pizza ou de manger des cailloux — des absurdités que le sens commun permettait de filtrer —, les erreurs actuelles sont beaucoup plus subtiles et techniques. Elles touchent à l’interprétation de seuils numériques et de contextes cliniques, des domaines où l’utilisateur moyen n’a pas les compétences pour contredire la machine. Selon 01net, qui titre ce 12 janvier que « Google joue avec la santé des internautes », le géant du web a reconnu le problème et retiré les réponses incriminées, mais le mal est fait en termes de réputation.

Une technologie encore faillible malgré un déploiement massif

Ce retrait intervient alors que Google a massivement déployé ses aperçus IA dans une centaine de pays, cherchant à transformer l’expérience de recherche traditionnelle en une expérience conversationnelle. Pourtant, la persistance de ces erreurs en 2026 démontre les limites intrinsèques des modèles probabilistes actuels.

Techniquement, les modèles de langage fonctionnent en prédisant le mot le plus probable suivant une séquence donnée. Bien que Google ait mis en place des systèmes de « grounding » (ancrage) pour forcer l’IA à se baser sur des sources médicales fiables, le système semble encore échouer à comprendre la nuance sémantique entre une valeur « dans la moyenne » et une valeur « pathologique » dans certains contextes spécifiques. L’IA ne « comprend » pas la médecine ; elle simule un discours médical.

Cette affaire rappelle que la mise à l’échelle (scaling) des modèles d’IA ne résout pas automatiquement les problèmes de fiabilité factuelle (factuality). Malgré l’intégration de modèles Gemini de plus en plus performants, le risque zéro n’existe pas. Le fait que ces erreurs surviennent deux ans après les premiers déboires publics de l’IA de Google (anciennement Bard, puis SGE) suggère que les garde-fous (guardrails) mis en place par les ingénieurs de Mountain View sont encore perméables.

Contexte réglementaire et pression accrue sur la Big Tech

L’incident tombe au plus mal pour Google, qui navigue déjà dans des eaux troubles sur le plan réglementaire et judiciaire en ce début 2026. Outre cette défaillance technique, l’entreprise est sous le coup de plusieurs enquêtes.

Comme le soulignent les récents titres de presse, Google est visé par une enquête de Bruxelles pour de possibles infractions aux règles de la concurrence concernant l’IA. L’Union Européenne, avec son AI Act désormais pleinement effectif, impose des obligations strictes aux fournisseurs d’IA à « haut risque », catégorie dans laquelle entrent les dispositifs médicaux ou les outils d’aide au diagnostic. Si les « AI Overviews » ne sont pas classés officiellement comme dispositifs médicaux, leur utilisation de facto comme conseillers santé pourrait attirer les foudres des régulateurs européens.

Parallèlement, la firme doit gérer d’autres crises d’image. Toujours selon l’actualité récente, Google et la plateforme Character.AI ont dû conclure un accord le 8 janvier 2026 pour éviter des poursuites aux États-Unis liées à des suicides d’adolescents, mettant en cause la responsabilité des algorithmes dans la santé mentale des jeunes. Ce climat de défiance généralisée oblige Google à une prudence extrême, expliquant la réactivité du retrait des résumés médicaux dès la publication de l’enquête du Guardian.

L’impossible équilibre entre innovation et sécurité sanitaire

La promesse de l’IA en santé est immense : démocratiser l’accès à l’information, aider au pré-diagnostic, synthétiser des dossiers complexes. Cependant, l’approche « move fast and break things » (aller vite et casser des choses) de la Silicon Valley s’applique mal à la médecine, où « casser des choses » peut signifier mettre des vies en danger.

Les experts en éthique de l’IA soulignent depuis longtemps le danger de l’anthropomorphisme et de la confiance aveugle accordée aux machines. Lorsqu’un moteur de recherche, perçu comme une source de vérité objective, affiche un résumé généré par IA en haut de page, il crée un biais d’autorité. L’utilisateur a tendance à accepter la réponse synthétisée sans vérifier les sources sous-jacentes (souvent reléguées plus bas dans la page).

Pour Google, l’enjeu est désormais de prouver que ses algorithmes peuvent atteindre un niveau de précision de « qualité clinique » (clinical grade accuracy). Tant que ce seuil n’est pas garanti, le maintien de fonctionnalités génératives sur des requêtes médicales restera un pari risqué. Le retrait actuel pourrait n’être que temporaire, le temps pour les ingénieurs de recalibrer les filtres de sécurité, mais il marque un coup d’arrêt net dans la course à l’IA médicale grand public.

Conclusion

En retirant ses résumés IA comportant des erreurs médicales ce mois de janvier 2026, Google admet implicitement que sa technologie n’est pas encore mature pour remplacer le jugement humain, ni même pour le guider sans risque dans le domaine de la santé. Cet épisode, révélé par la presse internationale, servira sans doute d’avertissement à l’ensemble de l’industrie technologique : l’innovation ne peut se faire au détriment de la sécurité des patients. Alors que les outils numériques prennent une place grandissante dans nos vies, la vérification des faits et la validation médicale rigoureuse restent, plus que jamais, des remparts indispensables contre les dérives algorithmiques.

Questions fréquemment posées

Google a supprimé ces aperçus en urgence car son algorithme fournissait des interprétations fausses de résultats biologiques, indiquant par exemple qu’un bilan pathologique était normal. Ce dysfonctionnement technique représente un danger immédiat pour les utilisateurs qui, rassurés à tort par la machine, pourraient ne pas consulter un médecin alors que leur état de santé le nécessite réellement.

Le risque principal réside dans la génération de faux négatifs, où l’intelligence artificielle échoue à détecter une anomalie dans des données médicales complexes. Contrairement à des erreurs grossières, ces fautes subtiles sur des seuils numériques créent un faux sentiment de sécurité et peuvent avoir des conséquences graves si le patient se fie uniquement à la synthèse du moteur de recherche sans vérifier les sources.

Non, les modèles actuels fonctionnent sur des probabilités statistiques et ne possèdent pas de véritable compréhension médicale, ce qui les rend faillibles sur des nuances cliniques vitales. Malgré les efforts de Google pour ancrer ses réponses sur des sources fiables, l’incident de 2026 démontre que la technologie n’est pas encore assez mature pour remplacer ou même guider le jugement humain sans risque d’erreur critique.

Les erreurs de 2024 étaient souvent incohérentes et faciles à identifier par le bon sens, comme la suggestion absurde de manger des cailloux. À l’inverse, les défaillances de 2026 sont beaucoup plus pernicieuses car elles touchent à l’analyse technique de résultats d’examens, un domaine où l’utilisateur moyen manque de compétences pour contredire la machine.

Avec l’entrée en vigueur de l’AI Act, l’Europe impose des obligations strictes aux systèmes considérés à haut risque, catégorie incluant les outils d’aide au diagnostic. Google se trouve sous pression car ses résumés, utilisés de facto comme conseils santé, pourraient enfreindre ces règles de conformité et de sécurité, attirant ainsi l’attention des régulateurs sur de potentielles pratiques dangereuses.

Sources et Approfondissements

- Loi sur l’IA de l’UE : cadre réglementaire européen sur l’intelligence artificielle

- Rapport de l’OMS sur l’éthique et la gouvernance de l’IA pour la santé

- Explication technique des hallucinations dans les grands modèles de langage (Wikipédia)

- Cadre réglementaire pour l’IA et l’apprentissage automatique dans les dispositifs médicaux (FDA)

- Dossier thématique sur l’intelligence artificielle et la protection des données (CNIL)

Avez-vous trouvé cet article utile ? Y a-t-il un autre sujet que vous aimeriez que je traite ?

Écrivez-le dans les commentaires ci-dessous ! Je m'inspire directement de vos suggestions.