En Bref (TL;DR)

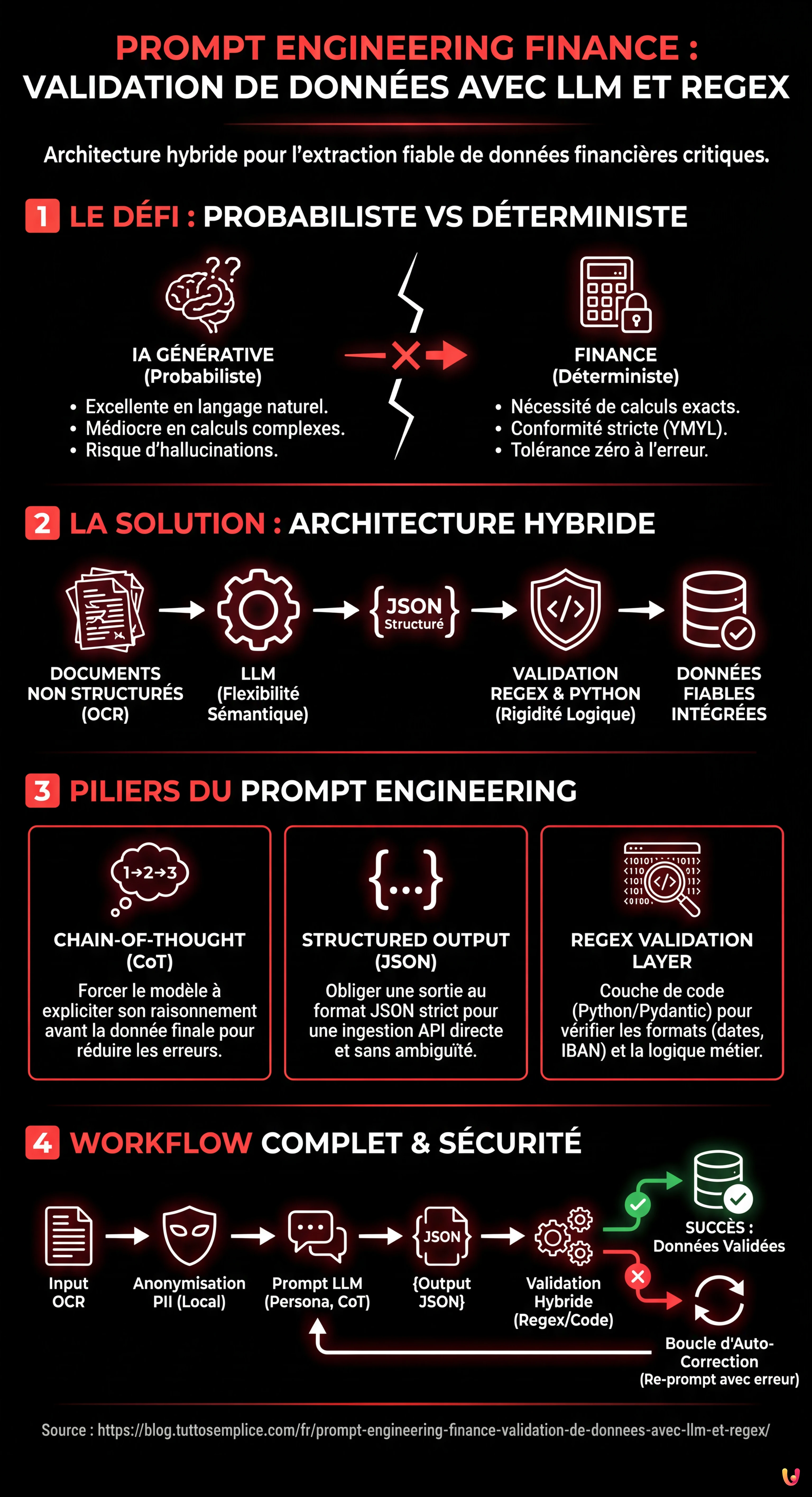

Surmonter la nature probabiliste des modèles génératifs est essentiel pour intégrer de manière fiable l’intelligence artificielle dans les processus décisionnels critiques.

Une approche hybride combine la flexibilité sémantique des LLM avec la rigidité logique des Expressions Régulières pour valider les données.

L’utilisation de Chain-of-Thought et de sorties JSON structurées garantit précision et conformité dans l’extraction automatique d’informations financières complexes.

Le diable est dans les détails. 👇 Continuez à lire pour découvrir les étapes critiques et les conseils pratiques pour ne pas vous tromper.

Dans le paysage fintech de 2026, l’adoption de l’Intelligence Artificielle Générative n’est plus une nouveauté, mais une norme opérationnelle. Cependant, le véritable défi ne réside pas dans l’implémentation d’un chatbot, mais dans l’intégration fiable des LLM (Large Language Models) dans les processus décisionnels critiques. Dans ce guide technique, nous explorerons le prompt engineering finance avec une approche d’ingénierie, en nous concentrant sur un cas d’usage spécifique et à haut risque : l’extraction et la validation des données pour l’instruction de prêts hypothécaires.

Nous aborderons le problème principal de l’IA dans le domaine financier : la nature probabiliste des modèles génératifs face à la nécessité déterministe des calculs bancaires. Comme nous le verrons, la solution réside dans une architecture hybride combinant la flexibilité sémantique de modèles comme GPT-4 (ou ultérieurs) avec la rigidité logique des Expressions Régulières (Regex) et des contrôles programmatiques.

Le Paradoxe de la Précision : Pourquoi les LLM échouent dans les calculs

Quiconque a travaillé avec l’IA générative sait que les modèles excellent dans la compréhension du langage naturel mais sont médiocres en arithmétique complexe ou dans le respect rigoureux de formats de sortie non standard. Dans un contexte YMYL (Your Money Your Life), une erreur dans le calcul du taux d’endettement n’est pas une hallucination acceptable ; c’est un risque de conformité et une perte économique potentielle.

Le prompt engineering finance ne concerne pas seulement l’écriture de phrases élégantes pour le modèle. Il s’agit de concevoir un système de Guardrails (garde-fous) qui contraignent le modèle à opérer dans des limites définies. L’approche que nous utiliserons repose sur trois piliers :

- Chain-of-Thought (CoT) : Forcer le modèle à expliciter son raisonnement avant de fournir la donnée finale.

- Structured Output (JSON) : Obliger le modèle à renvoyer des données structurées pour l’ingestion via API.

- Regex Validation Layer : Une couche de code Python qui vérifie si la sortie du LLM respecte les modèles formels (ex. IBAN, Numéro Fiscal, formats de date).

Phase 1 : Ingénierie du Prompt pour Documents Non Structurés

Imaginons devoir extraire des données d’une fiche de paie ou d’une expertise immobilière scannée (OCR). Le texte est sale, désordonné et plein d’abréviations. Un prompt générique échouerait. Nous devons construire un prompt structuré.

La Technique du “Persona” et du “Context Setting”

Le prompt doit définir clairement le rôle du modèle. Nous ne demandons pas un résumé, nous demandons une extraction de données ETL (Extract, Transform, Load).

SYSTEM ROLE:

Vous êtes un Analyste Crédit Senior spécialisé dans l'instruction de prêts. Votre tâche est d'extraire des données financières critiques à partir de texte non structuré provenant de documentation OCR.

OBJECTIF:

Identifier et normaliser le Revenu Net Mensuel et les dépenses récurrentes pour le calcul du taux d'endettement.

CONTRAINTES:

1. N'inventez pas de données. Si une donnée est absente, renvoyez "null".

2. Ignorez les bonus ponctuels, concentrez-vous sur la rémunération ordinaire.

3. La sortie DOIT être exclusivement au format JSON valide.Implémenter la Chain-of-Thought (CoT)

Pour augmenter la précision, nous utilisons la technique Chain-of-Thought. Nous demandons au modèle de “raisonner” dans un champ séparé du JSON avant d’extraire la valeur. Cela réduit considérablement les hallucinations sur les chiffres.

Exemple de structure du prompt utilisateur :

INPUT TEXT:

[Insérer ici le texte OCR de la fiche de paie...]

INSTRUCTIONS:

Analysez le texte étape par étape.

1. Identifiez toutes les entrées positives (salaire de base, indemnités).

2. Identifiez les retenues fiscales et sociales.

3. Excluez les remboursements de frais ou bonus non récurrents.

4. Calculez le net s'il n'est pas explicitement indiqué, sinon extrayez le "Net du mois".

OUTPUT FORMAT (JSON):

{

"reasoning": "Chaîne de texte où vous expliquez le raisonnement logique suivi pour identifier le net.",

"net_income_value": Float ou null,

"currency": "EUR",

"document_date": "YYYY-MM-DD"

}Phase 2 : Implémentation Python et Validation Hybride

Le prompt engineering finance est inutile sans un backend pour le soutenir. C’est ici qu’intervient l’approche hybride. Nous ne faisons pas aveuglément confiance au JSON du LLM. Nous le passons à travers un validateur basé sur Regex et Pydantic.

Code Python pour l’Intégration API

Ci-dessous un exemple de structuration de l’appel API (utilisant des bibliothèques standard comme openai et pydantic pour la validation des types) et d’intégration du contrôle Regex.

import openai

import json

import re

from pydantic import BaseModel, ValidationError, validator

from typing import Optional

# Définition du schéma de données attendu (Guardrail #1)

class FinancialData(BaseModel):

reasoning: str

net_income_value: float

currency: str

document_date: str

# Validateur Regex pour la date (Guardrail #2)

@validator('document_date')

def date_format_check(cls, v):

pattern = r'^d{4}-d{2}-d{2}$'

if not re.match(pattern, v):

raise ValueError('Format de date invalide. Requis YYYY-MM-DD')

return v

# Validateur logique pour le revenu (Guardrail #3)

@validator('net_income_value')

def realistic_income_check(cls, v):

if v 50000: # Seuils de sécurité pour alerte manuelle

raise ValueError('Valeur de revenu hors des paramètres standard (Détection d'Anomalie)')

return v

def extract_financial_data(ocr_text):

prompt = f"""

Analysez le texte OCR bancaire suivant et extrayez les données requises.

TEXT: {ocr_text}

Renvoyez UNIQUEMENT un objet JSON.

"""

try:

response = openai.ChatCompletion.create(

model="gpt-4-turbo", # Ou modèle équivalent 2026

messages=[

{"role": "system", "content": "Vous êtes un extracteur de données financières rigoureux."},

{"role": "user", "content": prompt}

],

temperature=0.0 # Température à 0 pour un déterminisme maximal

)

raw_content = response.choices[0].message.content

# Parsing et Validation

data_dict = json.loads(raw_content)

validated_data = FinancialData(**data_dict)

return validated_data

except json.JSONDecodeError:

return "Erreur : Le LLM n'a pas produit un JSON valide."

except ValidationError as e:

return f"Erreur de Validation des Données : {e}"

except Exception as e:

return f"Erreur générique : {e}"

# Exemple d'utilisation

# result = extract_financial_data("Fiche de paie mois Janvier... Net à payer : 2.450,00 euros...")

Phase 3 : Gestion des Hallucinations et Boucle de Correction

Que se passe-t-il si la validation échoue ? Dans un système de production avancé, nous implémentons un Self-Correction Loop (Boucle d’Auto-Correction). Si Pydantic lève une exception (ex. format de date erroné), le système peut automatiquement envoyer une nouvelle requête au LLM incluant l’erreur reçue.

Exemple de Prompt de Correction Automatique :

“Vous avez généré un JSON contenant une erreur. Le champ ‘document_date’ ne respectait pas le format YYYY-MM-DD. Corrigez la valeur et renvoyez à nouveau le JSON.”

Considérations sur la Confidentialité et la Sécurité (YMYL)

Lorsque l’on applique le prompt engineering à la finance, la gestion des données PII (Personally Identifiable Information) est critique. Avant d’envoyer tout texte OCR à une API publique (même entreprise), il est de bonne pratique d’appliquer une technique d’Anonymization Pre-Processing.

En utilisant des Regex locales (donc pas d’IA), on peut masquer les noms, numéros fiscaux et adresses en les remplaçant par des jetons (ex. [NOM_CLIENT_1]). Le LLM analysera la structure financière sans exposer l’identité réelle du demandeur de prêt, maintenant la conformité au RGPD.

Conclusions : L’Avenir de l’Instruction de Prêts

L’intégration entre le prompt engineering finance, la logique de programmation traditionnelle et la validation Regex représente la seule voie viable pour amener l’IA dans les processus centraux des banques. Il ne s’agit pas de remplacer l’analyste humain, mais de lui fournir des données pré-validées et normalisées, réduisant le temps de saisie de données de 80% et lui permettant de se concentrer sur l’évaluation du risque de crédit.

La clé du succès n’est pas un modèle plus intelligent, mais une ingénierie du prompt plus robuste et un système de contrôle plus rigide.

Foire aux questions

Le prompt engineering est essentiel pour transformer la nature probabiliste des modèles génératifs en résultats déterministes nécessaires aux banques. Grâce à l utilisation de garde-fous et d instructions structurées, on atténue les risques d hallucinations et on garantit que l extraction des données pour des processus critiques, comme l instruction de prêts, respecte des normes rigoureuses de conformité et de précision.

La solution réside dans une approche hybride qui combine la capacité sémantique de l IA avec la rigidité logique des Expressions Régulières (Regex) et des contrôles programmatiques. Au lieu de demander au modèle d effectuer des calculs complexes, on l utilise pour extraire des données structurées qui sont ensuite validées et traitées par une couche de code Python, assurant la précision requise dans le domaine financier.

La technique Chain-of-Thought améliore la précision de l extraction de données en obligeant le modèle à expliciter le raisonnement logique avant de fournir le résultat final. Dans le cas de documents non structurés comme les fiches de paie, cette méthode contraint l IA à identifier étape par étape les postes positifs et négatifs, réduisant significativement les erreurs d interprétation et les faux positifs dans les valeurs numériques.

Pour garantir la confidentialité et la conformité au RGPD, il est nécessaire d appliquer une technique d anonymisation en pré-traitement. Avant d envoyer les données à l API du modèle, on utilise des scripts locaux pour masquer les informations identifiables (PII) comme les noms et numéros fiscaux, permettant à l IA d analyser le contexte financier sans jamais exposer l identité réelle du demandeur.

Le Self-Correction Loop est un mécanisme automatisé qui gère les erreurs de sortie du modèle. Si le validateur (ex. Pydantic) détecte un format JSON erroné ou une donnée hors seuil, le système renvoie le prompt au LLM en incluant l erreur rencontrée, demandant au modèle de corriger spécifiquement ce paramètre. Ce cycle itératif augmente considérablement le taux de succès de l extraction automatique.

Avez-vous trouvé cet article utile ? Y a-t-il un autre sujet que vous aimeriez que je traite ?

Écrivez-le dans les commentaires ci-dessous ! Je m'inspire directement de vos suggestions.