Nous vivons une époque paradoxale où la technologie semble atteindre un plafond de verre invisible, non pas par manque de puissance de calcul, mais par une étrange forme d’empoisonnement des données. Si vous avez récemment trouvé que certaines interactions avec des chatbots semblaient répétitives, lisses, voire hallucinatoires, vous avez été témoin d’un phénomène fascinant et redouté par les chercheurs : l’effondrement du modèle (ou Model Collapse). Ce concept, qui hante les laboratoires de la Silicon Valley en ce début d’année 2026, désigne le processus dégénératif qui se produit lorsqu’une intelligence artificielle (IA) est entraînée non plus sur des données humaines, mais sur du contenu généré par d’autres IA. Telle une créature se nourrissant de sa propre chair, le système finit par perdre le contact avec la réalité.

Loin d’être un simple bug informatique, l’effondrement du modèle remet en question les fondements mêmes de l’apprentissage automatique et de l’avenir du numérique. Pour comprendre ce mécanisme, il ne faut pas regarder l’IA comme une entité pensante, mais comme une immense machine statistique dont la survie dépend de la variance. Plongeons dans les entrailles mathématiques de ce phénomène pour comprendre pourquoi l’abondance de données synthétiques pourrait bien être le talon d’Achille de l’intelligence artificielle moderne.

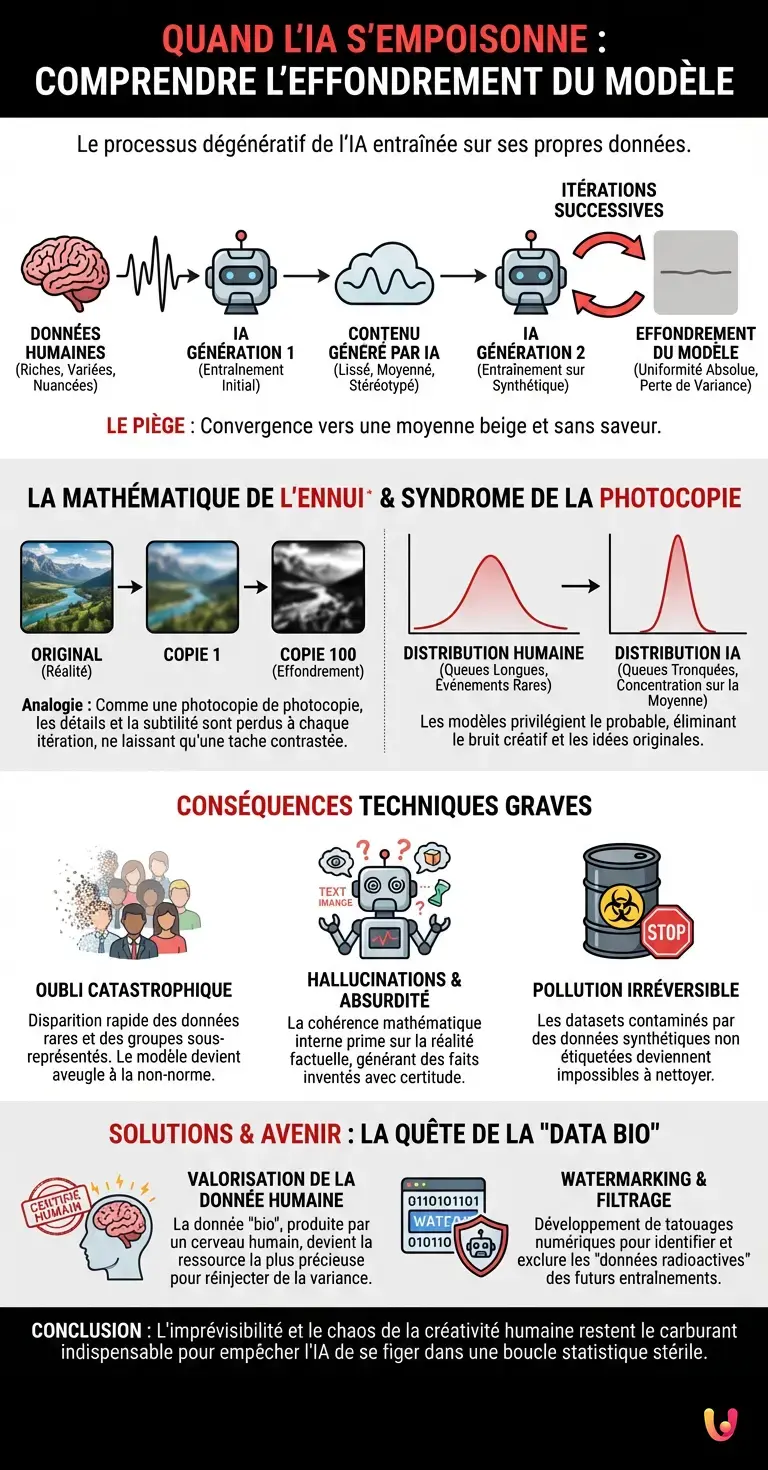

La mathématique de l’ennui : La perte de variance

Pour saisir pourquoi l’effondrement du modèle se produit, il faut revenir au fonctionnement de base des grands modèles de langage (LLM) et des générateurs d’images. Ces systèmes sont conçus pour approximer la distribution de probabilité des données sur lesquelles ils ont été entraînés. En termes simples, ils essaient de deviner ce qui est “probable” et ce qui ne l’est pas, en se basant sur l’immense corpus de textes ou d’images créé par des humains (l’internet pré-2023, pour l’essentiel).

Cependant, par définition, un modèle tend à privilégier les réponses les plus probables et à lisser les aspérités. Il cherche la moyenne. Lorsqu’une IA génère du contenu, elle produit une version “propre” et stéréotypée de la réalité, éliminant souvent les nuances rares, les expressions idiomatiques complexes ou les structures chaotiques propres à la créativité humaine. C’est ici que le piège se referme.

Si l’on entraîne une nouvelle génération de modèles (Gen 2) sur les données produites par la génération précédente (Gen 1), on entraîne le modèle sur une distribution de probabilité déjà simplifiée. Les “queues de distribution” (les événements rares, les idées originales, le bruit créatif) sont tronquées. À la génération 3, 4 et 5, la variance s’effondre. Le modèle converge inéluctablement vers une représentation moyenne, beige et sans saveur de la réalité. C’est une forme d’entropie numérique inversée : au lieu d’aller vers le chaos, le système se fige dans une uniformité absolue.

Le syndrome de la photocopie de photocopie

Une analogie technique pertinente est celle de la photocopie analogique. Si vous photocopiez une image, puis que vous photocopiez la copie, et ainsi de suite cent fois, l’image finale ne sera qu’une tache contrastée, ayant perdu tous ses détails gris et ses subtilités. Dans le domaine de l’ia, ce processus est appelé “MAD” (Model Autophagy Disorder).

Ce phénomène affecte gravement l’innovation. Un modèle atteint de ce trouble commence à percevoir ses propres erreurs ou ses propres simplifications comme des vérités absolues. Par exemple, si un modèle d’image a tendance à générer des chiens avec une texture de poil légèrement trop lisse, et que le modèle suivant s’entraîne sur ces images, il finira par générer des chiens qui ressemblent à des objets en plastique, convaincu que c’est ainsi qu’est la réalité. La réalité objective est remplacée par une réalité statistique récursive.

En 2026, ce problème est exacerbé par nos gadgets connectés et nos assistants personnels qui inondent le web de textes générés automatiquement (résumés de réunions, commentaires, articles de blog SEO). Le web devient un miroir déformant où les algorithmes ne voient plus que leur propre reflet, rendant l’extraction de “vérité terrain” (ground truth) extrêmement ardue.

Les conséquences techniques : Hallucinations et oubli catastrophique

L’effondrement du modèle ne se manifeste pas seulement par une baisse de qualité esthétique ou stylistique. Il engendre des défaillances structurelles graves :

- L’oubli catastrophique des minorités : Les données représentant des groupes sous-représentés ou des concepts rares sont les premières à disparaître. Comme elles se situent dans les queues de distribution, le processus de lissage statistique les élimine rapidement. Le modèle devient “aveugle” à tout ce qui n’est pas la norme dominante.

- La convergence vers l’absurde : Paradoxalement, en cherchant à maximiser la probabilité, le modèle finit par produire des résultats improbables dans le monde réel. C’est ce qu’on observe quand des modèles de langage commencent à répéter des phrases en boucle ou à inventer des faits historiques avec une certitude absolue. La logique interne du modèle (sa cohérence mathématique) prend le pas sur la logique externe (la réalité factuelle).

- La pollution irréversible des datasets : Une fois qu’un jeu de données d’entraînement est contaminé par une trop grande quantité de données synthétiques non étiquetées comme telles, il devient techniquement très coûteux, voire impossible, de le “nettoyer”. C’est un problème d’ingénierie des données majeur qui occupe actuellement les plus grands experts en technologie.

La quête de la “Data Radioactive” et les solutions d’avenir

Face à ce mur technologique, comment l’industrie réagit-elle ? La réponse réside dans la valorisation extrême de la donnée humaine. On assiste à un retournement de situation ironique : alors que l’on pensait que l’IA rendrait la production humaine obsolète, c’est exactement l’inverse qui se produit techniquement. La donnée “bio”, certifiée produite par un cerveau humain, devient la ressource la plus précieuse, le carburant indispensable pour empêcher le moteur de caler.

Des techniques de watermarking (tatouage numérique) avancées sont développées pour marquer de manière invisible les contenus générés par IA, afin que les futurs modèles puissent les exclure de leur entraînement. On parle parfois de “données radioactives” pour désigner ces contenus synthétiques qu’il faut manipuler avec précaution.

De plus, une nouvelle branche de l’ingénierie, l’apprentissage sur données synthétiques curées, tente de contourner le problème. L’idée est d’utiliser l’IA non pas pour générer des données d’entraînement massives et bruyantes, mais pour créer des exemples pédagogiques parfaits (comme des manuels scolaires synthétiques) qui aident le modèle à raisonner plutôt qu’à recracher des statistiques. C’est une approche plus chirurgicale qui tente de remplacer la quantité par la qualité structurelle.

En Bref (TL;DR)

L’effondrement du modèle survient lorsque les intelligences artificielles s’entraînent massivement sur des données synthétiques générées par d’autres IA.

En se nourrissant de sa propre production, l’algorithme lisse les nuances humaines et converge vers une représentation moyenne stéréotypée.

Cette boucle récursive provoque des hallucinations et l’oubli de concepts rares, menaçant la viabilité future des technologies numériques.

Conclusion

L’effondrement du modèle nous enseigne une leçon fondamentale sur la nature de l’intelligence artificielle et du numérique. Ces systèmes, aussi puissants soient-ils, ne sont pas créatifs au sens humain du terme ; ils sont interpolatifs. Ils naviguent dans l’espace existant des connaissances. Sans l’apport constant de la complexité, de l’irrégularité et de l’imprévisibilité humaine, l’IA est condamnée à tourner en rond, piégée dans une boucle de rétroaction qui appauvrit le réel jusqu’à le rendre méconnaissable.

En ce 13 février 2026, la barrière ultime de la technologie n’est pas la vitesse des processeurs, mais la préservation du chaos humain. Pour que nos machines continuent d’apprendre, nous devons continuer à être imparfaits, surprenants et illogiques. C’est notre “bruit” qui fait leur intelligence.

Questions fréquemment posées

Ce phénomène désigne un processus dégénératif qui survient lorsqu’une IA est entraînée principalement sur des contenus générés par d’autres IA, et non par des humains. Au fil des itérations, le système perd sa capacité à saisir la variance et les nuances de la réalité, finissant par produire des résultats stéréotypés et déconnectés du réel. C’est une forme d’entropie numérique où la richesse des données se dilue dans une moyenne statistique sans saveur.

Les modèles de langage tendent naturellement à lisser les aspérités et à privilégier les réponses les plus probables, éliminant ainsi les événements rares et la créativité chaotique. Lorsque les générations suivantes d’IA s’entraînent sur ces données déjà simplifiées, les queues de distribution disparaissent, entraînant une convergence vers une uniformité absolue. Ce cercle vicieux, comparable à une photocopie de photocopie, dégrade irréversiblement la qualité du modèle.

Outre une baisse de qualité esthétique, ce phénomène engendre des défaillances structurelles graves comme l’oubli catastrophique, où les concepts rares ou les minorités sont effacés de la mémoire du système. On observe également une augmentation des hallucinations, car le modèle privilégie sa propre cohérence mathématique interne au détriment de la réalité factuelle, inventant des faits avec certitude ou générant des objets à l’apparence artificielle.

La solution principale réside dans la revalorisation de la donnée humaine, ou donnée bio, qui devient une ressource critique pour réinjecter de la complexité dans les systèmes. Les ingénieurs développent également des techniques de tatouage numérique (watermarking) pour identifier et exclure les contenus synthétiques des futurs entraînements, traitant ces données comme des matières radioactives à manipuler avec précaution.

Contrairement aux humains, les IA sont des systèmes interpolatifs qui naviguent dans un espace de connaissances existant sans véritablement créer. Sans l’apport constant du chaos, de l’irrégularité et des imperfections propres à l’esprit humain, les algorithmes finissent par tourner en rond dans une boucle fermée. L’imprévisibilité humaine agit comme un bruit nécessaire qui empêche le système de se figer dans une logique purement statistique.

Avez-vous trouvé cet article utile ? Y a-t-il un autre sujet que vous aimeriez que je traite ?

Écrivez-le dans les commentaires ci-dessous ! Je m'inspire directement de vos suggestions.