In Breve (TL;DR)

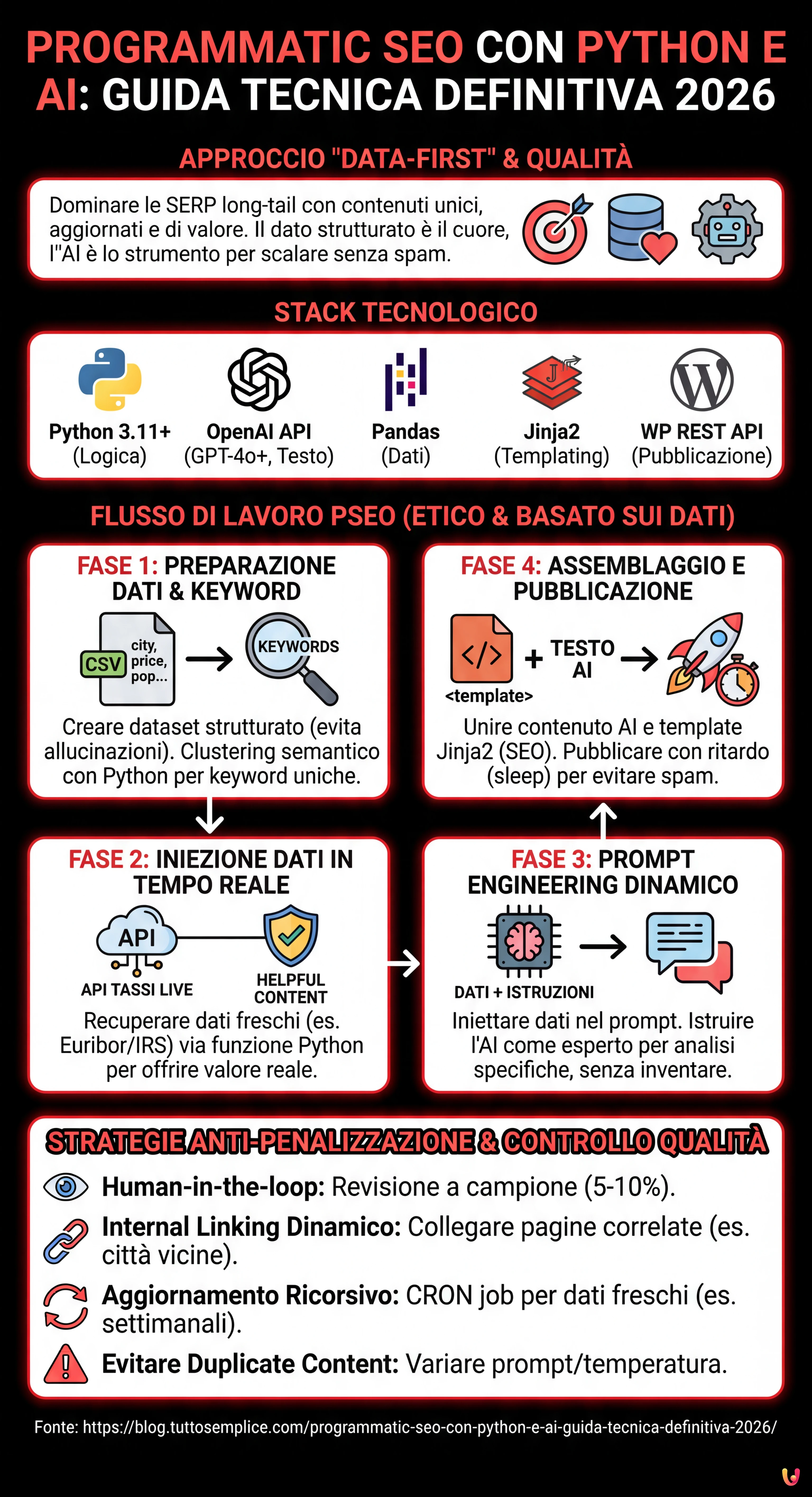

La Programmatic SEO moderna sfrutta Python e AI per dominare le query a coda lunga tramite contenuti etici e basati sui dati.

Una strategia vincente richiede l’iniezione di dati strutturati in tempo reale per offrire valore concreto ed evitare penalizzazioni dai motori di ricerca.

L’ingegnerizzazione di prompt dinamici combinata con API esterne trasforma dataset grezzi in landing page uniche ottimizzate per la conversione locale.

Il diavolo è nei dettagli. 👇 Continua a leggere per scoprire i passaggi critici e i consigli pratici per non sbagliare.

Siamo nel 2026 e il panorama del marketing digitale è cambiato radicalmente. La Programmatic SEO: Generazione Contenuti su Scala con l’ausilio di Python e delle moderne API di Intelligenza Artificiale non è più una tecnica riservata a giganti come TripAdvisor o Yelp, ma una necessità per chiunque voglia dominare le SERP su query a coda lunga (long-tail). Tuttavia, la linea tra una strategia vincente e lo spam penalizzante è sottile. Questa guida tecnica esplorerà come costruire un’architettura di pSEO (Programmatic SEO) etica, basata sui dati e guidata dalla qualità.

Cos’è la Programmatic SEO e perché l’approccio “Data-First” vince

La Programmatic SEO è il processo di creazione automatizzata di landing page su larga scala, mirate a migliaia di varianti di keyword a bassa concorrenza ma ad alta intenzione di conversione. A differenza del passato, dove si duplicavano pagine cambiando solo il nome della città, l’approccio moderno richiede contenuti unici, arricchiti semanticamente e aggiornati in tempo reale.

Il nostro caso studio pratico riguarderà il settore finanziario: genereremo pagine per la query “Mutuo tasso fisso [Città]”. L’obiettivo è fornire valore reale iniettando dati finanziari aggiornati (Euribor/IRS) specifici per il momento della consultazione.

Prerequisiti e Stack Tecnologico

Per seguire questa guida, è necessario disporre del seguente stack:

- Python 3.11+: Il motore logico dell’operazione.

- OpenAI API (GPT-4o o successivi): Per la generazione del testo narrativo e l’analisi semantica.

- Pandas: Per la manipolazione del dataset (il “database” delle nostre variabili).

- Jinja2: Motore di templating per strutturare l’HTML.

- WordPress REST API (o CMS headless equivalente): Per la pubblicazione automatica.

Fase 1: Preparazione del Dataset e Keyword Research Automatica

Il cuore della pSEO non è l’AI, ma il Dato. Senza un dataset strutturato, l’AI produrrà solo allucinazioni. Dobbiamo creare un CSV contenente le variabili che renderanno unica ogni pagina.

1.1 Struttura del Dataset (data.csv)

Immaginiamo un file con queste colonne:

city: Milano, Roma, Napoli…population: Dati demografici (utile per il contesto).avg_house_price: Prezzo medio al mq (dato proprietario o scrapato).local_branch_address: Indirizzo della filiale locale (se esistente).

1.2 Clustering Semantico con Python

Non vogliamo cannibalizzare le keyword. Usiamo Python per assicurarci che le varianti non siano troppo simili. Ecco uno snippet concettuale per generare i modificatori della keyword principale:

import pandas as pd

# Carichiamo i dati base

df = pd.read_csv('cities_italy.csv')

# Definiamo i pattern di keyword basati sull'intento

patterns = [

"Miglior mutuo tasso fisso a {city}",

"Preventivo mutuo casa {city} tasso aggiornato",

"Andamento prezzi case e mutui a {city}"

]

# Generazione delle combinazioni

keywords = []

for index, row in df.iterrows():

for p in patterns:

keywords.append({

"city": row['city'],

"keyword": p.format(city=row['city']),

"data_point": row['avg_house_price']

})

print(f"Generate {len(keywords)} potenziali landing page.")

Fase 2: Iniezione Dati in Tempo Reale (L’elemento “Helpful Content”)

Per evitare la penalizzazione “Thin Content” di Google, la pagina deve offrire un valore che una semplice AI non può inventare. In questo caso: i tassi di interesse aggiornati.

Creiamo una funzione Python che recupera il tasso Euribor/IRS del giorno. Questo dato verrà passato al prompt dell’AI per commentare la convenienza del mutuo oggi.

def get_current_euribor():

# Simulazione chiamata API a fornitore dati finanziari

# In produzione usare: requests.get('https://api.financial-data.com/euribor')

return {

"euribor_3m": 2.55,

"irs_10y": 2.80,

"date": "12 Gennaio 2026"

}

financial_data = get_current_euribor()

Fase 3: Il Prompt Engineering Dinamico

Non chiedete a ChatGPT di “scrivere un articolo”. Costruite il prompt iniettando i dati strutturati. Questo riduce le allucinazioni e garantisce che ogni pagina parli specificamente della città e dei tassi reali.

Ecco come strutturare la chiamata API:

import openai

client = openai.OpenAI(api_key="IL_TUO_TOKEN")

def generate_content(city, price_mq, rates):

prompt = f"""

Agisci come un consulente finanziario esperto per il mercato immobiliare italiano.

Scrivi una sezione HTML (h2, p, ul) per una landing page dedicata ai mutui a {city}.

DATI OBBLIGATORI DA INCLUDERE:

- Città: {city}

- Prezzo medio case: {price_mq}€/mq

- Tasso IRS 10 Anni (Oggi): {rates['irs_10y']}%

- Data rilevazione: {rates['date']}

ISTRUZIONI:

1. Analizza se conviene comprare casa a {city} considerando il prezzo al mq rispetto alla media nazionale.

2. Spiega come il tasso IRS del {rates['irs_10y']}% impatta una rata mensile media per questa specifica città.

3. Usa un tono professionale ma accessibile.

4. NON inventare dati non forniti.

"""

response = client.chat.completions.create(

model="gpt-4o",

messages=[{"role": "user", "content": prompt}],

temperature=0.7

)

return response.choices[0].message.content

Fase 4: Assemblaggio e Pubblicazione Automatica

Una volta generato il contenuto testuale (“Body Content”), dobbiamo inserirlo in un template HTML ottimizzato per la SEO tecnica (Schema Markup, Meta Tags, ecc.) e pubblicarlo.

4.1 Il Template Jinja2

Utilizziamo Jinja2 per separare la logica dalla struttura. Il template page_template.html potrebbe apparire così:

<!DOCTYPE html>

<html lang="it">

<head>

<title>Mutuo Tasso Fisso a {{ city }} - Aggiornamento {{ date }}</title>

<meta name="description" content="Scopri i tassi attuali per i mutui a {{ city }}. Analisi del mercato immobiliare locale e preventivi basati sull'IRS al {{ irs_rate }}%.">

</head>

<body>

<h1>Mutui Casa a {{ city }}: Analisi e Tassi {{ year }}</h1>

<div class="dynamic-content">

{{ ai_generated_content | safe }}

</div>

<div class="data-widget">

<h3>Dati di Mercato a {{ city }}</h3>

<ul>

<li><strong>Prezzo mq:</strong> {{ price }} €</li>

<li><strong>Trend:</strong> {{ trend }}</li>

</ul>

</div>

</body>

</html>

4.2 Lo Script di Pubblicazione

Infine, iteriamo sul DataFrame e pubblichiamo. Attenzione: Non pubblicate 5.000 pagine in un giorno. Google potrebbe interpretarlo come un attacco spam. Implementate un ritardo (sleep) o una schedulazione.

import time

import requests

from jinja2 import Template

# Carica template

with open('page_template.html') as f:

template = Template(f.read())

for index, row in df.iterrows():

# 1. Genera contenuto AI

ai_text = generate_content(row['city'], row['avg_house_price'], financial_data)

# 2. Renderizza HTML completo

final_html = template.render(

city=row['city'],

date=financial_data['date'],

irs_rate=financial_data['irs_10y'],

year="2026",

price=row['avg_house_price'],

trend="Stabile",

ai_generated_content=ai_text

)

# 3. Pubblica su WordPress (Esempio semplificato)

post_data = {

'title': f"Mutuo Tasso Fisso a {row['city']}",

'content': final_html,

'status': 'draft' # Meglio salvare come bozza per revisione umana a campione

}

# requests.post('https://tuosito.com/wp-json/wp/v2/posts', json=post_data, auth=...)

print(f"Pagina per {row['city']} creata.")

time.sleep(120) # Pausa di 2 minuti tra una generazione e l'altra

Strategie Anti-Penalizzazione e Controllo Qualità

La Programmatic SEO fallisce quando manca il controllo qualità. Ecco le regole d’oro per il 2026:

- Human-in-the-loop: Non pubblicare mai al 100% in automatico senza revisione a campione. Controlla almeno il 5-10% delle pagine generate.

- Internal Linking Dinamico: Usa Python per creare link tra città vicine (es. La pagina di “Monza” deve linkare a “Milano”). Questo crea cluster topici forti.

- Aggiornamento Ricorsivo: Lo script non deve girare una sola volta. Configura un CRON job che aggiorna i tassi (il numero nell’H1 e nel testo) ogni settimana. Google premia la “Freshness”.

- Evitare il Duplicate Content: Se due città hanno dati identici, l’AI potrebbe generare testo simile. Aumenta la “Temperature” dell’API o varia i prompt in base alla regione geografica.

Conclusioni

Implementare una strategia di Programmatic SEO nel 2026 richiede più competenze di ingegneria del software che di copywriting tradizionale. L’unione di Python per la gestione dei dati strutturati e delle API AI per la generazione di narrativa contestuale permette di scalare la visibilità organica in modo esponenziale. Tuttavia, ricordate sempre: l’obiettivo è rispondere all’intento di ricerca dell’utente meglio di quanto farebbe una pagina statica, fornendo dati iper-locali e aggiornati.

Domande frequenti

La Programmatic SEO è una tecnica avanzata che utilizza il codice e l’automazione per generare migliaia di landing page uniche su larga scala, mirate a parole chiave a coda lunga. A differenza della SEO tradizionale, che prevede la scrittura manuale di ogni singolo articolo, questo approccio sfrutta dataset strutturati e intelligenza artificiale per creare contenuti massivi ma pertinenti. Nel 2026, la differenza sostanziale risiede nell’approccio Data-First: non si tratta solo di duplicare pagine, ma di arricchirle semanticamente con dati aggiornati in tempo reale per soddisfare specifici intenti di ricerca locali.

Per implementare un’architettura pSEO efficace è necessario uno stack tecnologico ben definito. Il cuore del sistema è Python, utilizzato per la logica di automazione, affiancato dalla libreria Pandas per la gestione e la pulizia del dataset contenente le variabili. Per la generazione dei testi è indispensabile l’uso di API di Intelligenza Artificiale moderne, come GPT-4o, mentre Jinja2 è essenziale per il templating HTML. Infine, serve un collegamento via REST API a un CMS come WordPress per gestire la pubblicazione automatica dei contenuti generati.

Per evitare penalizzazioni legate allo spam o ai contenuti di scarso valore (Thin Content), è fondamentale iniettare dati unici e utili che l’AI non può inventare, come tassi finanziari aggiornati o statistiche locali specifiche. È inoltre necessario adottare una strategia Human-in-the-loop, revisionando a campione una percentuale delle pagine generate. Altre pratiche essenziali includono l’aggiornamento ricorsivo dei dati tramite script periodici e la creazione di una struttura di link interni dinamica che colleghi logicamente le pagine correlate.

L’iniezione di dati in tempo reale è l’elemento chiave che trasforma una pagina generata automaticamente in una risorsa di valore per l’utente (Helpful Content). Inserire informazioni dinamiche, come il tasso Euribor o l’IRS del giorno corrente, garantisce che il contenuto sia sempre fresco e accurato. Questo approccio riduce drasticamente le allucinazioni dell’intelligenza artificiale e segnala ai motori di ricerca che la pagina offre un servizio aggiornato, migliorando il posizionamento e la fiducia dell’utente.

Un prompt efficace per la pSEO non deve essere generico, ma deve includere istruzioni rigide e dati contestuali. Invece di chiedere semplicemente di scrivere un testo, bisogna passare all’AI le variabili esatte estratte dal dataset, come il nome della città, il prezzo al metro quadro o la data odierna. È consigliabile definire il ruolo dell’AI, ad esempio come consulente esperto, e imporre vincoli sulla struttura HTML dell’output. Questo metodo, definito Prompt Engineering Dinamico, assicura che ogni variante di pagina sia specifica e non una semplice duplicazione semantica.

Fonti e Approfondimenti

- Google Search Central: Politiche antispam per la ricerca web (Contenuti generati automaticamente)

- Agenzia delle Entrate: Banca dati OMI (Quotazioni immobiliari per il dataset prezzi)

- Banca d’Italia: Rilevazione tassi di interesse effettivi globali medi (TEGM) per mutui

- ISTAT: Dati ufficiali sulla popolazione residente e demografia (per arricchimento dataset)

- Python Software Foundation: Documentazione ufficiale del linguaggio Python

Hai trovato utile questo articolo? C'è un altro argomento che vorresti vedermi affrontare?

Scrivilo nei commenti qui sotto! Prendo ispirazione direttamente dai vostri suggerimenti.