Em Resumo (TL;DR)

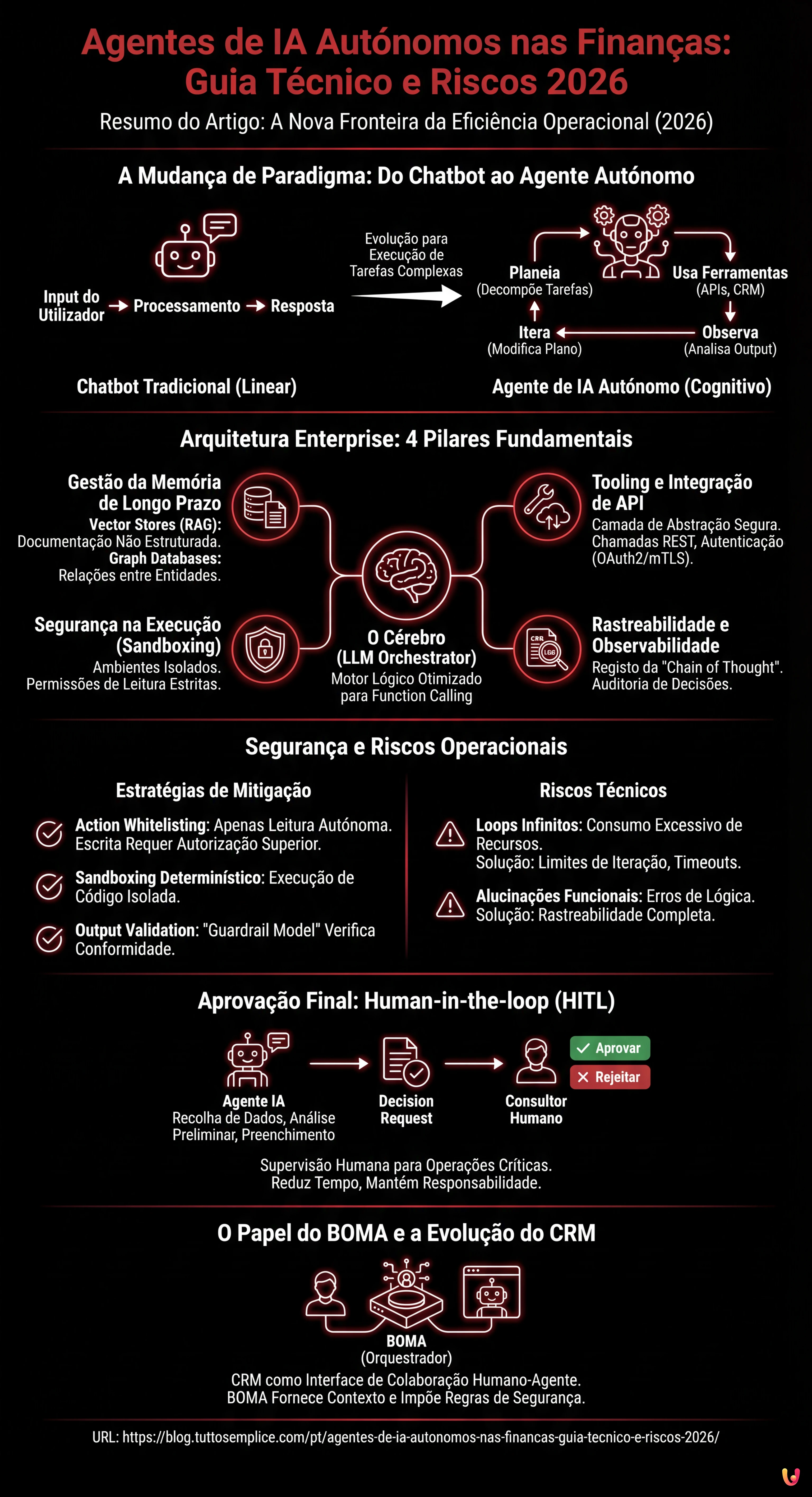

O setor financeiro de 2026 evolui para agentes de IA autónomos capazes de planear e executar ações complexas para além da simples conversação.

Uma arquitetura enterprise robusta deve integrar orquestração lógica, memória de longo prazo e conexões API seguras para gerir operações bancárias críticas.

A segurança operacional depende de controlos rigorosos de execução, sandboxing determinístico e rastreabilidade completa das decisões para garantir a conformidade.

O diabo está nos detalhes. 👇 Continue lendo para descobrir os passos críticos e as dicas práticas para não errar.

Estamos em 2026 e o paradigma do Serviço ao Cliente financeiro mudou definitivamente. Se até há dois anos o objetivo era implementar chatbots conversacionais capazes de responder a FAQs complexas, hoje a fronteira deslocou-se para os agentes de IA autónomos. Já não falamos de software que fala, mas de entidades digitais que agem. No contexto enterprise, e especificamente no setor bancário e segurador, a capacidade de uma IA executar tarefas complexas – como calcular uma prestação de crédito habitação personalizada, recuperar documentos em falta de bases de dados heterogéneas e agendar uma chamada com um consultor humano – representa o novo padrão de eficiência operacional.

Este guia técnico explora a arquitetura necessária para orquestrar estes agentes, analisando os desafios críticos ligados à segurança, à memória de longo prazo e à rastreabilidade das decisões num ambiente regulamentado.

Da Automação Estática ao Agente Autónomo: A Mudança de Paradigma

A diferença substancial entre um chatbot tradicional (mesmo baseado em LLM) e os agentes de IA autónomos reside no ciclo de execução. Enquanto um chatbot segue um padrão Input do Utilizador -> Processamento -> Resposta, um agente autónomo opera segundo um loop cognitivo mais complexo, frequentemente baseado no padrão ReAct (Reason + Act) ou em arquiteturas evoluídas derivadas de frameworks como LangChain ou AutoGPT.

Num cenário financeiro, o agente não se limita a dizer “Aqui está o formulário para o crédito habitação”. O agente:

- Planeia: Decompõe o pedido (“Quero renegociar o crédito habitação”) em subtarefas (Verificação de identidade, Análise da situação de dívida atual, Cálculo de novas taxas, Geração de proposta).

- Usa Ferramentas (Tools): Interroga as APIs do Core Banking, acede ao CRM, utiliza calculadoras financeiras.

- Observa: Analisa o output das tools (ex: “O cliente tem uma prestação em atraso”).

- Itera: Modifica o plano com base na observação (ex: “Antes de renegociar, propor plano de regularização para a prestação em atraso”).

Arquitetura Enterprise para Agentes Financeiros

Para implementar uma força de trabalho digital sintética num contexto como o bancário, não basta um script Python. É necessária uma arquitetura robusta composta por quatro pilares fundamentais.

1. O Cérebro (LLM Orchestrator)

O coração do sistema é um Large Language Model (LLM) otimizado para function calling. Em 2026, os modelos não são apenas geradores de texto, mas motores lógicos capazes de selecionar qual a ferramenta a utilizar entre centenas disponíveis. A orquestração ocorre através de frameworks que gerem o fluxo de pensamento do agente, garantindo que este permanece focado no objetivo.

2. Gestão da Memória de Longo Prazo

Um agente financeiro deve recordar. Não apenas a conversa atual (Short-term memory), mas o histórico do cliente (Long-term memory). Aqui a arquitetura divide-se:

- Vector Stores (RAG): Para recuperar apólices, contratos e documentação não estruturada.

- Graph Databases: Fundamentais para mapear as relações entre entidades (Cliente -> Conta -> Cotitular -> Fiador).

O desafio técnico é a coerência do estado: o agente deve saber que o documento carregado ontem é válido também para o pedido de hoje.

3. Tooling e Integração de API

Os agentes são inúteis sem mãos. Nas finanças, as “tools” são endpoints API seguros. A arquitetura deve prever uma camada de abstração que traduz a intenção do agente (“Verificar saldo”) numa chamada REST segura, gerindo a autenticação (OAuth2/mTLS) e a gestão de erros sem expor dados sensíveis no prompt.

Segurança na Execução: O Conceito de Sandboxing

A segurança é o principal obstáculo à adoção dos agentes de IA autónomos. Se um agente tem permissão para executar transferências ou alterar dados de registo, o risco de erros ou manipulações (Prompt Injection) é inaceitável.

As estratégias de mitigação em 2026 incluem:

- Action Whitelisting: O agente pode propor qualquer ação, mas pode executar autonomamente apenas ações de leitura (GET requests). As ações de escrita (POST/PUT/DELETE) requerem níveis de autorização superiores.

- Sandboxing Determinístico: A execução do código ou das queries SQL gerados pela IA ocorre em ambientes isolados e com permissões de apenas leitura estritamente limitadas ao contexto do cliente específico.

- Output Validation: Cada resposta do agente passa através de um “Guardrail Model”, um modelo mais pequeno e especializado que verifica a conformidade da resposta com as políticas da empresa antes que esta chegue ao utilizador.

Rastreabilidade e Observabilidade

Em caso de auditoria, o banco deve poder explicar por que o agente tomou uma decisão. Os logs tradicionais não bastam. É necessário implementar sistemas de LLM Observability que registem toda a “Chain of Thought” (Cadeia de Pensamento). Isto permite reconstruir o raciocínio lógico: “O agente negou a transação porque detetou um padrão de despesa anómalo na Tool X e aplicou a Política Y”.

Riscos Operacionais: Loops Infinitos e Alucinações Funcionais

Um risco técnico específico dos agentes autónomos é o loop infinito. Um agente pode entrar num círculo vicioso onde tenta recuperar um documento, falha, tenta novamente, falha de novo, consumindo tokens e recursos de API infinitamente. Para mitigar este risco, é essencial implementar:

- Max Iteration Limits: Um hard stop após um número pré-fixado de passos lógicos (ex: máx 10 passos para resolver um ticket).

- Time-to-Live (TTL) Execution: Timeouts rigorosos para cada chamada a ferramentas externas.

Human-in-the-loop: A Aprovação Final

Apesar da autonomia, as ações críticas requerem ainda a supervisão humana. A abordagem Human-in-the-loop (HITL) é o padrão para operações de alto impacto (ex: aprovação final de um empréstimo ou desbloqueio de uma conta suspensa).

Neste cenário, o agente prepara todo o trabalho pesado: recolhe os dados, faz a análise preliminar, preenche os formulários e apresenta ao consultor humano uma “Decision Request”. O humano deve apenas clicar em “Aprovar” ou “Rejeitar”, eventualmente adicionando notas. Isto reduz o tempo de processamento em 90%, mantendo a responsabilidade humana sobre as decisões finais.

O Papel do BOMA e a Evolução do CRM

Neste ecossistema, plataformas como o BOMA posicionam-se não mais como simples repositórios de dados, mas como orquestradores da força de trabalho digital. O CRM do futuro (e do presente 2026) é a interface onde humanos e agentes de IA autónomos colaboram. O BOMA atua como a camada de controlo que fornece aos agentes o contexto necessário (os dados do cliente) e impõe as regras de interação (as políticas de segurança), transformando o CRM de ferramenta passiva em colega ativo.

Conclusões

A adoção de agentes de IA autónomos no serviço ao cliente financeiro não é um simples upgrade tecnológico, mas uma reestruturação operacional. Requer uma governança rigorosa, uma arquitetura pensada para a falibilidade (graceful degradation) e uma segurança “by design”. As organizações que conseguirem equilibrar a autonomia dos agentes com o controlo humano definirão os novos padrões de eficiência e satisfação do cliente na próxima década.

Perguntas frequentes

A distinção fundamental reside na capacidade de execução operacional. Enquanto os chatbots seguem um ciclo linear de input e resposta conversacional, os agentes autónomos operam através de loops cognitivos complexos, frequentemente baseados no padrão ReAct, que lhes permitem planear, utilizar ferramentas externas e iterar as ações com base nos resultados. Não se limitam a fornecer informações, mas executam tarefas concretas como o cálculo de prestações ou a recuperação de documentos de bases de dados heterogéneas.

A segurança baseia-se em estratégias rigorosas como o Action Whitelisting, que limita a autonomia do agente apenas às operações de leitura, exigindo autorizações superiores para as alterações de dados. Além disso, utiliza-se o Sandboxing Determinístico para isolar a execução do código e modelos de validação do output, conhecidos como Guardrail Model, que verificam a conformidade das respostas com as políticas da empresa antes que estas cheguem ao utilizador final.

Apesar da elevada autonomia dos agentes, as decisões críticas como a aprovação de um empréstimo ou o desbloqueio de uma conta requerem a supervisão humana para garantir responsabilidade legal e conformidade. Neste modelo, o agente de IA realiza todo o trabalho preparatório de recolha e análise de dados, apresentando ao consultor humano um pedido de decisão final estruturado, reduzindo drasticamente os tempos de processamento sem eliminar o controlo humano.

Um dos principais riscos é o loop infinito, onde o agente continua a tentar uma ação falhada consumindo recursos e tokens. Para prevenir este fenómeno e as alucinações funcionais, é essencial implementar limites máximos de iteração para cada tarefa e timeouts rigorosos para as chamadas de API. Além disso, a rastreabilidade completa da cadeia de pensamento, ou Chain of Thought, permite auditar à posteriori as lógicas de decisão do algoritmo.

Uma arquitetura enterprise eficaz utiliza tanto a memória de curto prazo para a conversa corrente, como a de longo prazo para o histórico do cliente. Isto ocorre através de tecnologias distintas: os Vector Stores para recuperar documentação não estruturada como contratos e apólices, e os Graph Databases para mapear as relações complexas entre entidades, garantindo que o agente tenha sempre o contexto atualizado e coerente para operar.

Fontes e Aprofundamento

- Comissão Europeia: Lei da Inteligência Artificial (AI Act) e enquadramento regulamentar

- NIST: Framework de Gestão de Riscos de Inteligência Artificial (AI RMF)

- Autoridade Bancária Europeia (EBA): Inteligência Artificial e Machine Learning no setor bancário

- OCDE: Princípios globais sobre Inteligência Artificial e gestão de riscos

- Wikipedia: Definição e conceitos de Agentes Inteligentes

Achou este artigo útil? Há outro assunto que gostaria de me ver abordar?

Escreva nos comentários aqui em baixo! Inspiro-me diretamente nas vossas sugestões.