Em Resumo (TL;DR)

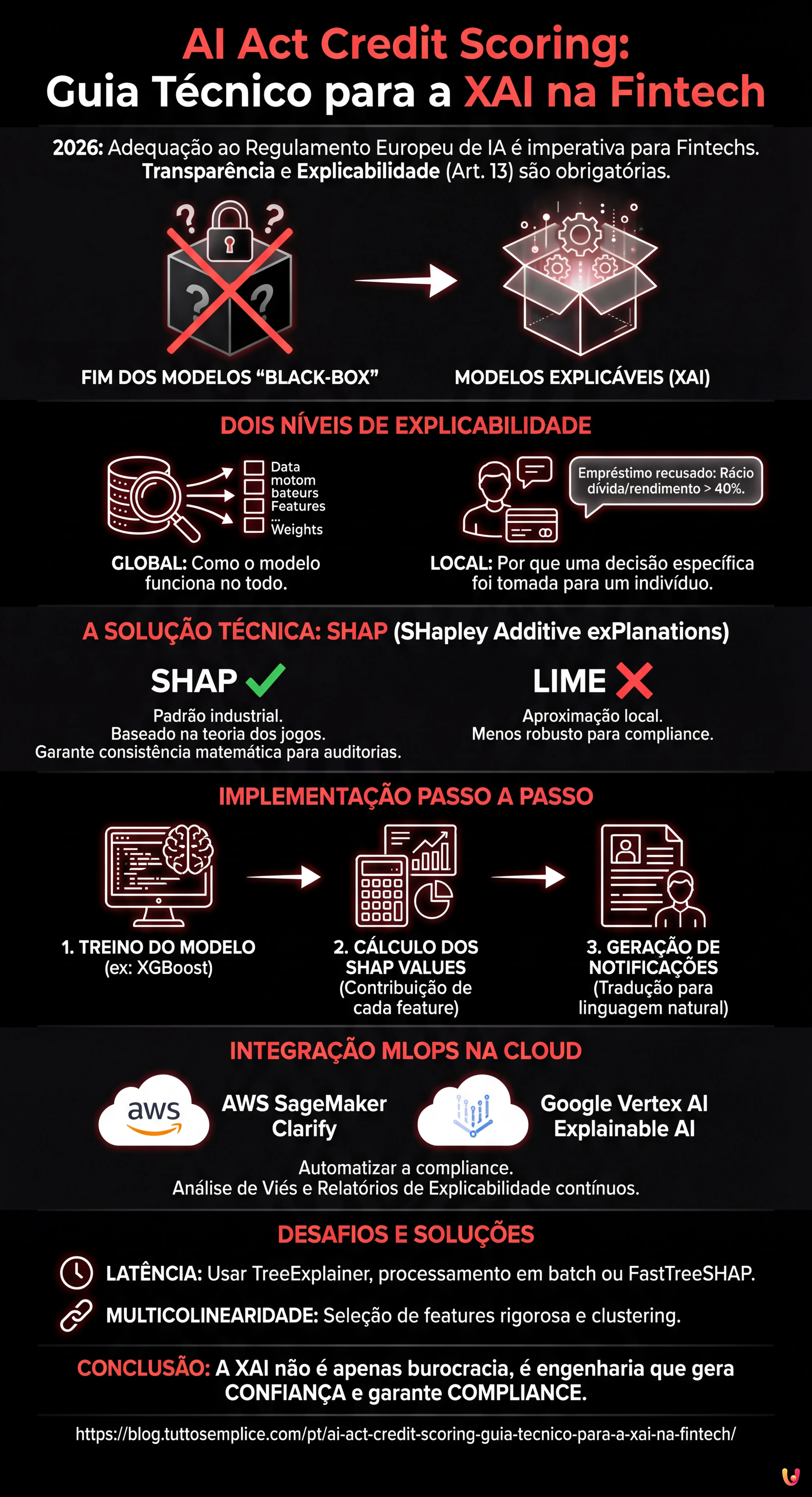

O Regulamento Europeu sobre Inteligência Artificial classifica o credit scoring como sistema de alto risco, impondo obrigações rigorosas de transparência e explicabilidade.

Os Data Scientists devem abandonar os modelos black-box adotando bibliotecas de Explainable AI como o SHAP para garantir decisões interpretáveis e matematicamente consistentes.

A integração de ferramentas como o AWS SageMaker Clarify nas pipelines MLOps permite automatizar a compliance normativa monitorizando viés e explicabilidade em produção.

O diabo está nos detalhes. 👇 Continue lendo para descobrir os passos críticos e as dicas práticas para não errar.

Estamos em 2026 e o panorama da Fintech europeia mudou radicalmente. Com a plena operacionalidade do Regulamento Europeu sobre Inteligência Artificial, a adequação dos sistemas de ai act credit scoring já não é um diferencial competitivo, mas um imperativo legal. Os sistemas de avaliação de mérito de crédito são classificados como High-Risk AI Systems (Sistemas de Alto Risco) de acordo com o Anexo III do AI Act. Isto impõe obrigações rigorosas em termos de transparência e explicabilidade (Artigo 13).

Para os CTOs, Data Scientists e engenheiros de MLOps, isto significa o fim dos modelos “black-box” imperscrutáveis. Já não basta que um modelo XGBoost ou uma Rede Neuronal tenha uma AUC (Area Under Curve) de 0.95; devem ser capazes de explicar por que motivo um empréstimo foi recusado a um cliente específico. Este guia técnico explora a implementação da Explainable AI (XAI) nas pipelines de produção, colmatando a lacuna entre a compliance normativa e a engenharia de software.

O Requisito de Transparência no AI Act para a Fintech

O AI Act estabelece que os sistemas de alto risco devem ser concebidos de forma a que o seu funcionamento seja suficientemente transparente para permitir aos utilizadores interpretar o output do sistema. No contexto do credit scoring, isto traduz-se em dois níveis de explicabilidade:

- Explicabilidade Global: Compreender como o modelo funciona no seu todo (quais as features que têm mais peso em geral).

- Explicabilidade Local: Compreender por que razão o modelo tomou uma decisão específica para um indivíduo único (ex. “O empréstimo foi recusado porque o rácio dívida/rendimento excede os 40%”).

O objetivo técnico é transformar vetores matemáticos complexos em notificações de ação adversa (Adverse Action Notices) compreensíveis e legalmente defensáveis.

Pré-requisitos e Stack Tecnológico

Para seguir este guia de implementação, pressupõe-se o conhecimento de Python e dos princípios básicos de Machine Learning. O stack de referência inclui:

- Bibliotecas ML: Scikit-learn, XGBoost ou LightGBM (padrão de facto para dados tabulares no credit scoring).

- Bibliotecas XAI: SHAP (SHapley Additive exPlanations) e LIME.

- Cloud Provider: AWS SageMaker ou Google Vertex AI (para a orquestração MLOps).

Abandonar a Black-Box: SHAP vs LIME

Embora existam modelos intrinsecamente interpretáveis (como as regressões logísticas ou as Decision Trees pouco profundas), muitas vezes estes sacrificam a precisão preditiva. A solução moderna é a utilização de modelos complexos (ensemble methods) combinados com métodos de interpretação model-agnostic.

Porquê escolher SHAP para o Credit Scoring

Entre as várias opções, o SHAP tornou-se o padrão industrial para o setor bancário. Ao contrário do LIME, que aproxima o modelo localmente, o SHAP baseia-se na teoria dos jogos cooperativos e garante três propriedades matemáticas fundamentais: local accuracy, missingness e consistency. Num contexto regulamentado como o do ai act credit scoring, a consistência matemática do SHAP oferece uma garantia maior em caso de auditoria.

Implementação Passo a Passo: De XGBoost a SHAP

Abaixo, um exemplo prático de como integrar o SHAP num modelo de scoring de risco.

1. Treino do Modelo

Suponhamos que treinámos um classificador XGBoost num dataset de pedidos de empréstimo.

import xgboost as xgb

import shap

import pandas as pd

# Carregamento de dados e treino (simplificado)

X, y = shap.datasets.adult() # Dataset exemplo

model = xgb.XGBClassifier().fit(X, y)2. Cálculo dos SHAP Values

Em vez de nos limitarmos à previsão, calculamos os valores de Shapley para cada instância. Estes valores indicam quanto cada feature contribuiu para deslocar a previsão em relação à média do dataset (base value).

# Inicialização do explainer

explainer = shap.TreeExplainer(model)

shap_values = explainer.shap_values(X)

# Exemplo: Explicação para o cliente ID 0

print(f"Base Value: {explainer.expected_value}")

print(f"SHAP Values Cliente 0: {shap_values[0]}")Se o Base Value (probabilidade média de incumprimento) for 0.20 e a previsão para o cliente for 0.65, os valores SHAP dir-nos-ão exatamente quais as variáveis que adicionaram esse +0.45 de risco (ex. +0.30 por atrasos passados, +0.15 por baixa antiguidade laboral).

Integração MLOps na Cloud: Automatizar a Compliance

Executar o SHAP num notebook é simples, mas o AI Act requer monitorização contínua e processos escaláveis. Eis como integrar a XAI em pipelines na cloud.

AWS SageMaker Clarify

A AWS oferece o SageMaker Clarify, um serviço nativo que se integra no ciclo de vida do modelo. Para configurá-lo:

- Configuração do Processador: Durante a definição do training job, configura-se um

SageMakerClarifyProcessor. - Análise de Viés (Bias): O Clarify calcula métricas de viés pré-treino (ex. desequilíbrios de classe) e pós-treino (ex. disparidade de precisão entre grupos demográficos), essencial para a equidade exigida pelo AI Act.

- Explainability Report: Define-se uma configuração SHAP (ex.

SHAPConfig) que gera automaticamente relatórios JSON para cada endpoint de inferência.

Google Vertex AI Explainable AI

De forma semelhante, a Vertex AI permite configurar a explanationSpec durante o carregamento do modelo. A Google suporta nativamente Sampled Shapley e Integrated Gradients. A vantagem aqui é que a explicação é devolvida diretamente na resposta da API juntamente com a previsão, reduzindo a latência.

Geração Automática das “Adverse Action Notices”

O passo final é traduzir os valores numéricos do SHAP em linguagem natural para o cliente final, satisfazendo a obrigação de notificação.

Imaginemos uma função Python que processa o output:

def gera_explicacao(shap_values, feature_names, threshold=0.1):

explicacoes = []

for value, name in zip(shap_values, feature_names):

if value > threshold: # Contributo positivo para o risco

if name == "num_atrasos_pagamento":

explicacoes.append("A presença de atrasos nos pagamentos recentes influenciou negativamente.")

elif name == "racio_divida_rendimento":

explicacoes.append("O rácio entre as suas dívidas e o rendimento é elevado.")

return explicacoesEsta camada de tradução semântica é o que torna o sistema conforme ao artigo 13 do AI Act, tornando o algoritmo transparente para o utilizador não técnico.

Resolução de Problemas e Desafios Comuns

Ao implementar sistemas de ai act credit scoring explicáveis, encontram-se frequentemente obstáculos técnicos:

1. Latência de Inferência

O cálculo dos valores SHAP, especialmente o método exato em árvores de decisão profundas, é computacionalmente dispendioso.

Solução: Utilizar TreeExplainer (otimizado para árvores) em vez de KernelExplainer. Em produção, calcular as explicações de forma assíncrona (batch processing) se não for necessária uma resposta em tempo real imediata para o utilizador, ou utilizar versões aproximadas como FastTreeSHAP.

2. Multicolinearidade

Se duas features forem altamente correlacionadas (ex. “Rendimento Anual” e “Rendimento Mensal”), o SHAP poderá dividir a importância entre as duas, tornando a explicação confusa.

Solução: Executar uma rigorosa Seleção de Features e remoção das features redundantes antes do treino. Utilizar técnicas de clustering hierárquico para agrupar features correlacionadas.

Conclusões

A adequação ao AI Act no setor do credit scoring não é apenas um exercício burocrático, mas um desafio de engenharia que eleva a qualidade do software financeiro. Ao implementar arquiteturas baseadas em XAI como SHAP e integrando-as em pipelines MLOps robustas no SageMaker ou Vertex AI, as empresas Fintech podem garantir não só a compliance legal, mas também uma maior confiança por parte dos consumidores. A transparência algorítmica é a nova moeda do crédito digital.

Perguntas frequentes

O regulamento de IA classifica os sistemas de avaliação de mérito de crédito como sistemas de alto risco de acordo com o Anexo III. Esta definição impõe às empresas Fintech obrigações severas de transparência e explicabilidade, forçando o abandono dos modelos de «caixa negra». É agora necessário que os algoritmos forneçam motivações compreensíveis para cada decisão tomada, especialmente em caso de recusa de um empréstimo.

A explicabilidade global permite compreender o funcionamento do modelo no seu todo, identificando quais as variáveis que têm mais peso em geral. A explicabilidade local, por outro lado, é fundamental para a compliance normativa, pois esclarece por que razão o modelo tomou uma decisão específica para um único cliente, permitindo gerar notificações precisas sobre as causas de um resultado negativo.

O SHAP tornou-se o padrão industrial porque se baseia na teoria dos jogos cooperativos e garante propriedades matemáticas como a consistência, essencial na fase de auditoria. Ao contrário do LIME, que fornece aproximações locais, o SHAP calcula o contributo exato de cada característica em relação à média, oferecendo uma justificação da pontuação de crédito legalmente mais sólida.

Para automatizar a compliance é possível utilizar serviços geridos como o AWS SageMaker Clarify ou o Google Vertex AI. Estas ferramentas integram-se no ciclo de vida do modelo para calcular métricas de viés e gerar automaticamente relatórios de explicabilidade SHAP para cada inferência, garantindo uma monitorização contínua sem intervenção manual excessiva.

O cálculo dos valores SHAP pode ser computacionalmente oneroso e atrasar as respostas. Para mitigar o problema, recomenda-se a utilização do TreeExplainer, que é otimizado para árvores de decisão, ou deslocar o cálculo para processos assíncronos em lote se não for necessária uma resposta imediata. Outra solução eficaz é a utilização de aproximações rápidas como o FastTreeSHAP.

Achou este artigo útil? Há outro assunto que gostaria de me ver abordar?

Escreva nos comentários aqui em baixo! Inspiro-me diretamente nas vossas sugestões.