Em Resumo (TL;DR)

A arquitetura dos sistemas distribuídos na cloud reflete à escala macroscópica as leis físicas fundamentais que governam o design dos circuitos integrados.

As restrições de hardware como o Fan-out e a propagação do sinal explicam perfeitamente os desafios modernos de load balancing e coerência de dados.

A otimização térmica dos processadores encontra o seu equivalente no FinOps, transformando a gestão energética do silício em estratégias para reduzir os custos da cloud.

O diabo está nos detalhes. 👇 Continue lendo para descobrir os passos críticos e as dicas práticas para não errar.

Estamos em 2026, e enquanto a inteligência artificial generativa reescreveu as regras da interação homem-máquina, as leis fundamentais da física e da lógica permanecem imutáveis. Para quem, como eu, iniciou a sua carreira com um ferro de soldar na mão e o esquema de um circuito integrado (IC) na mesa, o panorama atual do Cloud Computing não parece um mundo alienígena, mas sim uma evolução à escala macroscópica de problemas que já resolvemos à escala microscópica. No centro de tudo está a arquitetura de sistemas distribuídos: um conceito que hoje aplicamos a clusters globais, mas que nasce das interligações entre transístores numa bolacha de silício.

Neste ensaio técnico, exploraremos como a mentalidade sistémica necessária para projetar hardware fiável é a pedra angular para construir software resiliente. Analisaremos como as restrições físicas do silício encontram os seus análogos perfeitos nos desafios imateriais do SaaS moderno.

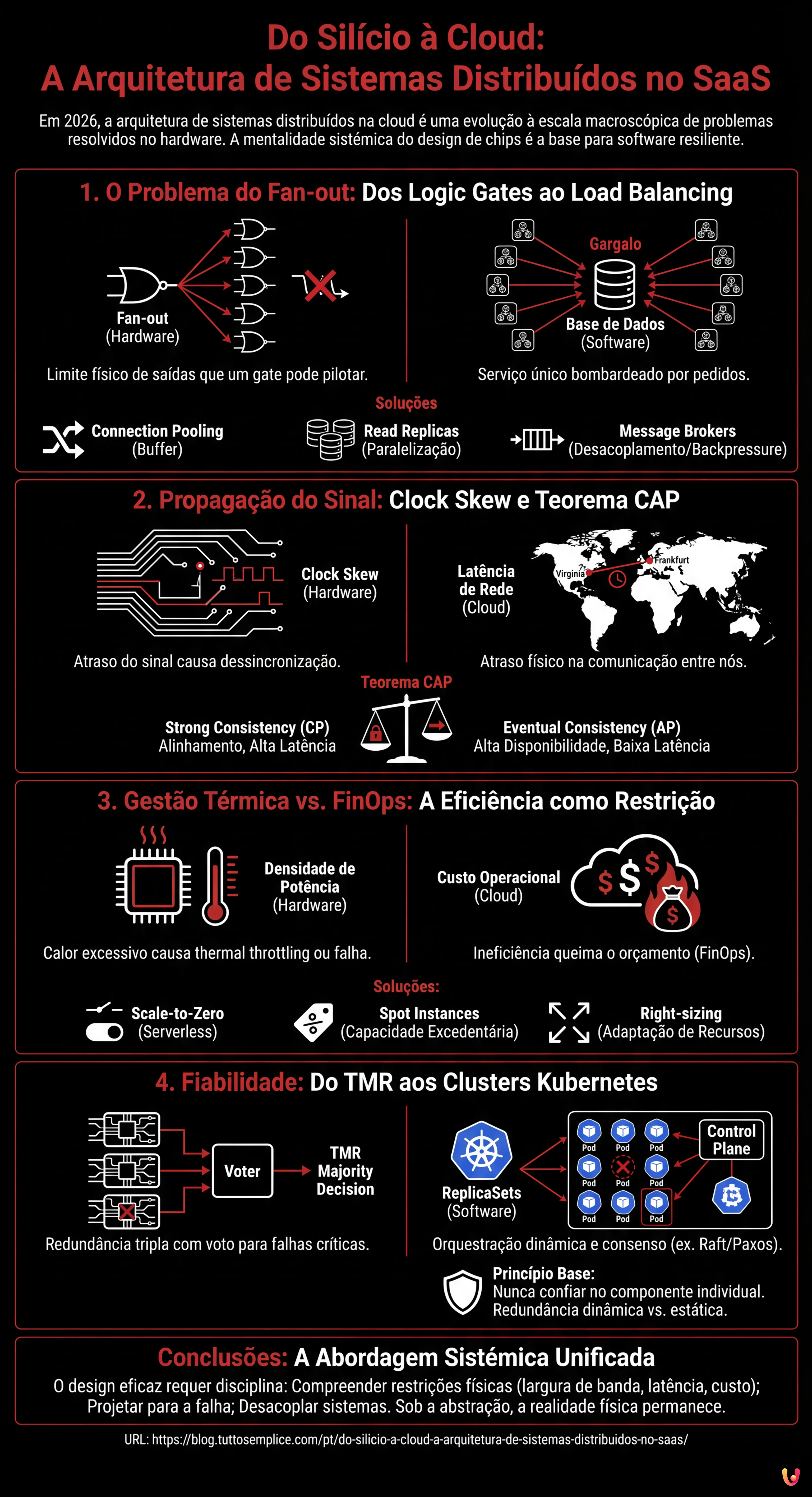

1. O Problema do Fan-out: Dos Logic Gates ao Load Balancing

Na engenharia eletrónica, o Fan-out define o número máximo de entradas lógicas que uma saída pode pilotar de forma fiável. Se um gate lógico tenta enviar um sinal a demasiados outros gates, a corrente divide-se excessivamente, o sinal degrada-se e a comutação (0 a 1 ou vice-versa) torna-se lenta ou indefinida. É um limite físico de capacidade de pilotagem.

O Análogo no Software: O Gargalo da Base de Dados

Na arquitetura de sistemas distribuídos, o conceito de Fan-out manifesta-se brutalmente quando um único serviço (ex. uma base de dados master ou um serviço de autenticação) é bombardeado por demasiados pedidos concorrentes dos microsserviços cliente. Tal como um transístor não pode fornecer corrente infinita, uma base de dados não tem conexões TCP ou ciclos de CPU infinitos.

A solução de hardware é a inserção de buffers para regenerar o sinal e aumentar a capacidade de pilotagem. No SaaS, aplicamos o mesmo princípio através de:

- Connection Pooling: Que atua como um buffer de corrente, mantendo as conexões ativas e reutilizáveis.

- Read Replicas: Que paralelizam a carga de leitura, semelhante à adição de estágios de amplificação em paralelo.

- Message Brokers (Kafka/RabbitMQ): Que desacoplam o produtor do consumidor, gerindo os picos de carga (backpressure) exatamente como um condensador de desacoplamento estabiliza a tensão durante os picos de absorção.

2. Propagação do Sinal: Clock Skew e Teorema CAP

Em circuitos de alta frequência, a velocidade da luz (ou melhor, a velocidade de propagação do sinal no cobre/ouro) é uma restrição tangível. Se uma pista no PCB for mais longa que outra, o sinal chega atrasado, causando problemas de sincronização conhecidos como Clock Skew. O sistema torna-se incoerente porque diferentes partes do chip veem a “realidade” em momentos diferentes.

A Tirania da Distância na Cloud

Na cloud, a latência de rede é o novo atraso de propagação. Quando projetamos uma arquitetura de sistemas distribuídos geo-redundante, não podemos ignorar que a luz demora tempo a viajar de Frankfurt até à Virgínia do Norte. Este atraso físico é a raiz do Teorema CAP (Consistency, Availability, Partition tolerance).

Um engenheiro eletrónico sabe que não pode ter um sinal perfeitamente síncrono num chip enorme sem abrandar o clock (sacrificando a performance pela coerência). Da mesma forma, um arquiteto de software deve escolher entre:

- Strong Consistency (CP): Esperar que todos os nós estejam alinhados (como um clock global lento), aceitando latência elevada.

- Eventual Consistency (AP): Permitir que os nós divirjam temporariamente para manter a alta disponibilidade e baixa latência, gerindo os conflitos a posteriori (semelhante a circuitos assíncronos ou self-timed).

3. Gestão Térmica vs. FinOps: A Eficiência como Restrição

A densidade de potência é o inimigo número um nos processadores modernos. Se não se dissipar o calor, o chip entra em thermal throttling (abranda) ou queima. O design VLSI (Very Large Scale Integration) moderno gira em torno do conceito de “Dark Silicon”: não podemos ligar todos os transístores simultaneamente porque o chip derreteria. Devemos ligar apenas o que é necessário, quando é necessário.

O Custo é o Calor da Cloud

No modelo SaaS, o “calor” é o custo operacional. Uma arquitetura ineficiente não derrete os servidores (o provider de cloud trata disso), mas queima o orçamento da empresa. O FinOps é a moderna gestão térmica.

Tal como um engenheiro de hardware usa o Clock Gating para desligar as partes do chip não utilizadas, um Cloud Architect deve implementar:

- Scale-to-Zero: Utilizando tecnologias Serverless (como AWS Lambda ou Google Cloud Run) para desligar completamente os recursos quando não há tráfego.

- Spot Instances: Aproveitar capacidade excedentária a baixo custo, aceitando o risco de interrupção, semelhante ao uso de componentes com tolerâncias mais amplas em circuitos não críticos.

- Right-sizing: Adaptar os recursos à carga real, evitando o over-provisioning que no mundo do hardware equivaleria a usar um dissipador de 1kg para um chip de 5W.

4. Fiabilidade: Do TMR aos Clusters Kubernetes

Em sistemas aviónicos ou espaciais, onde a reparação é impossível e a radiação pode inverter aleatoriamente um bit (Single Event Upset), utiliza-se a Triple Modular Redundancy (TMR). Três circuitos idênticos executam o mesmo cálculo e um circuito de voto (voter) decide o output baseando-se na maioria. Se um falhar, o sistema continua a funcionar.

A Orquestração da Resiliência

Esta é a essência exata de um cluster Kubernetes ou de uma base de dados distribuída com consenso Raft/Paxos. Numa arquitetura de sistemas distribuídos moderna:

- ReplicaSets: Mantêm múltiplas cópias (Pod) do mesmo serviço. Se um nó cai (falha de hardware), o Control Plane (o “voter”) apercebe-se e reprograma o pod noutro local.

- Quorum em Bases de Dados: Para confirmar uma escrita num cluster (ex. Cassandra ou etcd), exigimos que a maioria dos nós (N/2 + 1) confirme a operação. Isto é matematicamente idêntico à lógica de voto do TMR de hardware.

A diferença substancial é que no hardware a redundância é estática (cablada), enquanto no software é dinâmica e reconfigurável. No entanto, o princípio base permanece: nunca confiar no componente individual.

Conclusões: A Abordagem Sistémica Unificada

Passar do silício para a cloud não significa mudar de profissão, mas mudar de escala. O design de uma arquitetura de sistemas distribuídos eficaz requer a mesma disciplina necessária para o tape-out de um microprocessador:

- Compreender as restrições físicas (largura de banda, latência, custo/calor).

- Projetar para a falha (o componente irá partir-se, o pacote perder-se-á).

- Desacoplar os sistemas para evitar a propagação de erros.

Em 2026, as ferramentas tornaram-se incrivelmente abstratas. Escrevemos YAML que descrevem infraestruturas efémeras. Mas sob esses níveis de abstração, ainda há eletrões a correr, clocks a fazer tique-taque e buffers a encher. Manter a consciência desta realidade física é o que distingue um bom programador de um verdadeiro Arquiteto de Sistemas.

Perguntas frequentes

A arquitetura cloud é considerada uma evolução à escala macroscópica dos desafios microscópicos típicos dos circuitos integrados. Problemas físicos como a gestão do calor e a propagação do sinal no silício encontram uma correspondência direta na gestão de custos e na latência de rede do software, exigindo uma mentalidade sistémica semelhante para garantir resiliência e eficiência operacional.

O Fan-out no software manifesta-se quando um único serviço, como uma base de dados master, recebe um número excessivo de pedidos concorrentes, analogamente a um gate lógico que pilota demasiadas entradas. Para mitigar este gargalo, adotam-se soluções como o connection pooling, as réplicas de leitura e os message brokers, que funcionam como buffers para estabilizar a carga e prevenir a degradação do desempenho.

A latência de rede, comparável ao atraso de propagação do sinal nos circuitos eletrónicos, impede a sincronização instantânea entre nós geograficamente distantes. Esta restrição física obriga os arquitetos de software a escolher entre Strong Consistency, aceitando latências maiores para aguardar o alinhamento dos nós, ou Eventual Consistency, que privilegia a disponibilidade tolerando desalinhamentos temporários dos dados.

No modelo SaaS, o custo operacional representa o equivalente ao calor gerado nos processadores: ambos são fatores limitantes que devem ser controlados. As estratégias FinOps como o Scale-to-Zero e o Right-sizing refletem técnicas de hardware como o Clock Gating, desligando ou redimensionando os recursos não utilizados para otimizar a eficiência e impedir que o orçamento seja consumido inutilmente.

Os clusters Kubernetes aplicam de forma dinâmica os princípios da Triple Modular Redundancy utilizada nos sistemas críticos de hardware. Através do uso de ReplicaSets e algoritmos de consenso para as bases de dados distribuídas, o sistema monitoriza constantemente o estado dos serviços e substitui os nós falhados baseando-se em mecanismos de voto e maioria, assegurando a continuidade operacional sem pontos únicos de falha.

Fontes e Aprofundamento

- NIST: A Definição Oficial de Cloud Computing (SP 800-145)

- Wikipedia: Teorema CAP (Consistência, Disponibilidade e Tolerância à Partição)

- CISA: Arquitetura de Referência Técnica para Cloud e Resiliência

- Wikipedia: Conceito de Fan-out em Engenharia Eletrónica

- Wikipedia: Fundamentos de Sistemas Distribuídos

Achou este artigo útil? Há outro assunto que gostaria de me ver abordar?

Escreva nos comentários aqui em baixo! Inspiro-me diretamente nas vossas sugestões.