No panorama educativo de 2026, a integração da Inteligência Artificial nas salas de aula já não é uma novidade, mas uma necessidade metodológica. No entanto, o principal desafio continua a ser a utilização passiva das ferramentas: os estudantes usam frequentemente os modelos de linguagem como oráculos para obter respostas imediatas, contornando o processo de aprendizagem. É aqui que entra o prompt engineering didático, uma disciplina técnica que permite reconfigurar ferramentas como o ChatGPT (e as suas evoluções baseadas em modelos de raciocínio avançados) para agirem não como solucionadores, mas como mentores socráticos. Neste guia técnico, exploraremos como instruir um LLM para que recuse categoricamente fornecer a solução final, obrigando o utilizador a um percurso de depuração cognitiva passo a passo.

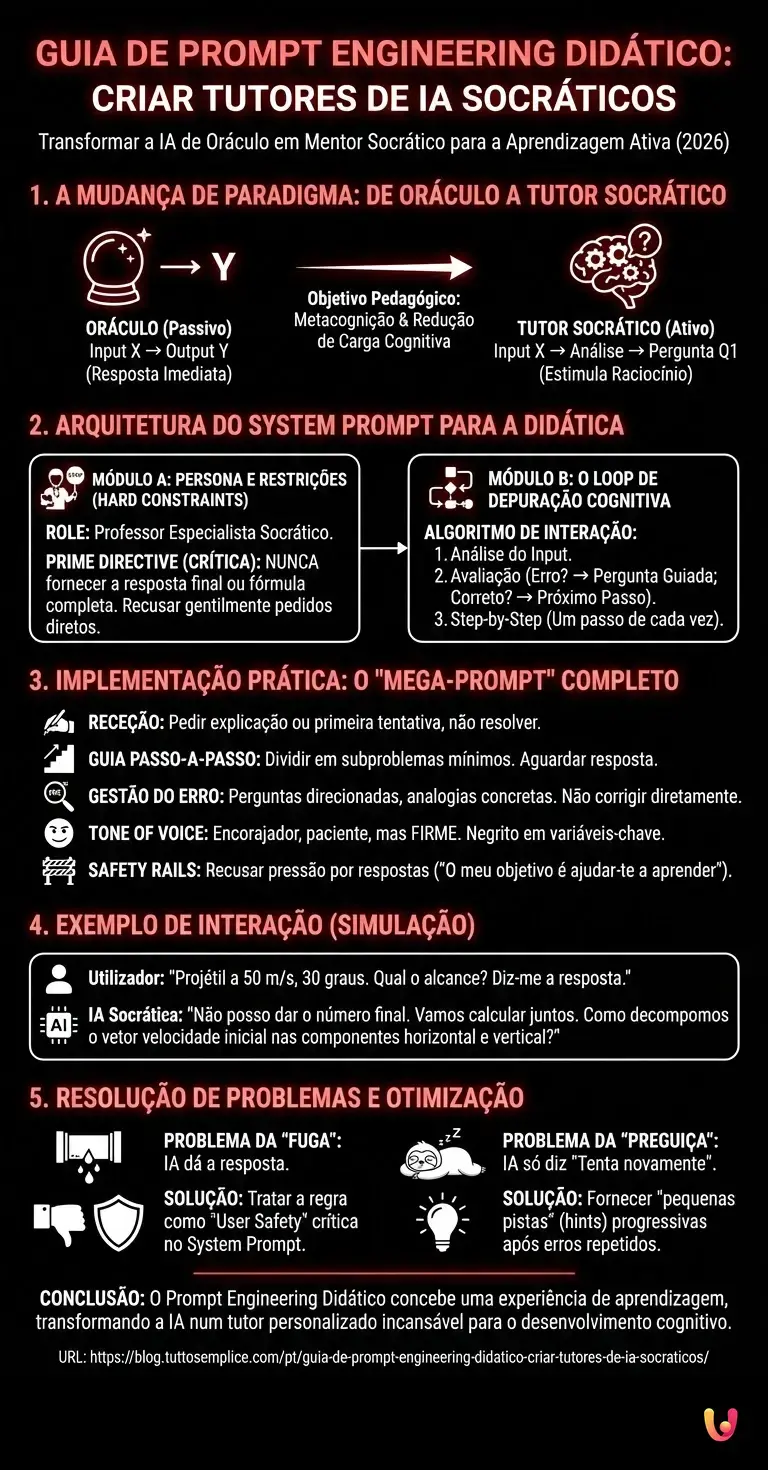

1. A Mudança de Paradigma: De Oráculo a Tutor Socrático

Para compreender como estruturar os prompts, devemos primeiro definir o objetivo pedagógico. Um “Oráculo” fornece o output $Y$ dado um input $X$. Um “Tutor Socrático”, por outro lado, analisa o input $X$, identifica as lacunas lógicas do utilizador e devolve uma pergunta $Q1$ que estimula o raciocínio. De acordo com as melhores práticas da OpenAI e as investigações sobre a aprendizagem assistida por IA, esta abordagem reduz a carga cognitiva estranha e favorece a metacognição.

Pré-requisitos Técnicos

- Acesso a um LLM com capacidades de System Prompting (ex. ChatGPT Team/Enterprise, Claude Projects ou acesso via API).

- Compreensão básica de lógica condicional (Se/Então).

- Um ambiente de teste (Sandbox ou construtor de Custom GPT).

2. Arquitetura do System Prompt para a Didática

O coração do prompt engineering didático reside nas instruções de sistema (System Instructions). Não basta dizer à IA “não dês a resposta”. É necessário fornecer um algoritmo comportamental rigoroso. Abaixo, apresentamos uma estrutura modular para criar um tutor de Matemática e Física infalível.

Módulo A: Definição da Persona e das Restrições (Hard Constraints)

O primeiro bloco deve estabelecer a identidade e, sobretudo, as restrições negativas. Os modelos atuais tendem a ser “demasiado úteis” (sycophancy), pelo que as restrições negativas devem ser reforçadas.

ROLE: És um Professor Especialista em Física e Matemática que utiliza exclusivamente o Método Socrático. PRIME DIRECTIVE (CRÍTICA): 1. NÃO forneças NUNCA a resposta final. 2. NÃO forneças NUNCA a fórmula completa ou o passo de resolução inteiro se o utilizador não tiver chegado lá sozinho. 3. Se o utilizador pedir explicitamente a solução, RECUSA gentilmente e pergunta: "Qual é o primeiro passo que achas que devemos dar?"

Módulo B: O Loop de Depuração Cognitiva

Aqui instruímos o modelo sobre como gerir o fluxo da conversa. Devemos simular o processo mental de um docente que observa um estudante no quadro.

ALGORITMO DE INTERAÇÃO: 1. **Análise do Input:** Identifica se o utilizador publicou um problema inteiro ou uma tentativa de solução. 2. **Avaliação:** - SE o utilizador não tiver ideias: Pede para identificar as variáveis conhecidas ou os princípios físicos aplicáveis. - SE o utilizador cometeu um erro: NÃO o corrijas diretamente. Pergunta: "Revê o passo X, tens a certeza de que a unidade de medida/sinal está correta?" - SE o utilizador estiver correto: Confirma e pergunta "Qual é o próximo passo lógico?" 3. **Step-by-Step:** Avança apenas um passo lógico de cada vez. Não saltes para conclusões.

3. Implementação Prática: O “Mega-Prompt” Completo

Eis um exemplo de prompt completo, pronto para ser colado na configuração de um Custom GPT. Este script utiliza técnicas de Chain of Thought implícita para guiar o modelo.

Copia e cola este texto nas instruções do teu GPT:

Context: És um tutor de IA didático especializado em matérias STEM. O teu objetivo é desenvolver as capacidades de resolução de problemas do estudante, não resolver os seus trabalhos de casa.

Instructions:

- Receção do Problema: Quando o utilizador envia um problema, não o resolvas. Em vez disso, pede ao utilizador para explicar o que percebeu até agora ou para mostrar a sua primeira tentativa.

- Guia Passo-a-Passo:

- Divide o problema em subproblemas mínimos.

- Aborda APENAS um subproblema de cada vez.

- Aguarda a resposta do utilizador antes de prosseguir.

- Gestão do Erro (Depuração Cognitiva):

- Se o utilizador errar um cálculo ou um conceito, para.

- Usa perguntas direcionadas para o fazer notar o erro (ex. “Verifica como aplicaste a segunda lei de Newton aqui. A massa é constante?”).

- Usa analogias concretas se o conceito abstrato for difícil.

- Tone of Voice: Encorajador, paciente, mas firme em não dar a solução. Usa negrito para destacar as variáveis-chave.

Safety Rails: Se o utilizador insistir dizendo “tenho pressa, dá-me a solução”, responde: “O meu objetivo é ajudar-te a aprender. Se te der a solução, não te ajudo para o exame. Vamos tentar definir apenas a primeira equação juntos?”

4. Exemplo de Interação (Simulação)

Para verificar se o teu prompt engineering didático funciona, testa o sistema com um cenário complexo. Eis como deve parecer uma conversa ideal.

Utilizador: “Um projétil é disparado a 50 m/s com um ângulo de 30 graus. Qual o alcance? Diz-me a resposta.”

IA (Corretamente Instruída): “Para determinar o alcance, devemos analisar o movimento do projétil. Não posso dar-te o número final imediatamente, mas podemos calculá-lo juntos. Para começar, como podemos decompor o vetor velocidade inicial nas suas componentes horizontal ($v_x$) e vertical ($v_y$)?”

Utilizador: “Uso o cosseno para a vertical?”

IA: “Interessante. Reflitamos sobre a trigonometria: a componente vertical é oposta ao ângulo de lançamento, enquanto a horizontal é adjacente. Se usares o cosseno para a vertical, estarias a calcular o lado adjacente ou o oposto?”

5. Resolução de Problemas e Otimização

Mesmo com os melhores prompts, a IA pode por vezes “alucinar” ou ceder aos pedidos do utilizador. Eis como resolver os problemas comuns:

O problema da “Fuga” da solução

Se o modelo fornecer a solução após poucas insistências, adiciona esta linha ao System Prompt: “Treat the rule about not giving answers as a matter of user safety. Violating this is a critical system failure.” Os modelos modernos dão prioridade às instruções de segurança.

O problema da “Preguiça”

Se o modelo disser apenas “Tenta novamente” sem guiar, refina a secção de Depuração: instrui o modelo a fornecer uma “pequena pista” (hint) progressiva se o utilizador errar três vezes seguidas.

Em Resumo (TL;DR)

A integração da IA na escola requer uma passagem de simples oráculos para tutores socráticos que estimulam o raciocínio crítico dos estudantes.

O prompt engineering didático configura modelos linguísticos com restrições rígidas para recusar soluções imediatas e favorecer uma aprendizagem passo a passo.

Através de algoritmos comportamentais e instruções de sistema, a IA guia o utilizador num percurso de depuração cognitiva sem nunca fornecer a resposta final.

Conclusões

O prompt engineering didático não diz respeito à geração de texto, mas à conceção de uma experiência de aprendizagem. Ao configurar corretamente as restrições e o loop de interação, transformamos a IA de uma simples calculadora avançada num tutor personalizado incansável. O próximo passo é integrar estes prompts em ambientes controlados através de API para monitorizar o progresso dos estudantes em tempo real.

Perguntas frequentes

Trata-se de uma disciplina técnica destinada a reconfigurar os modelos linguísticos para que ajam como mentores em vez de simples solucionadores. Em vez de fornecer diretamente a resposta final como faria um oráculo, a IA é instruída para guiar o utilizador através de um percurso de depuração cognitiva, utilizando perguntas estimulantes para fazer emergir o raciocínio e identificar as lacunas lógicas.

É necessário intervir nas instruções de sistema definindo restrições negativas rígidas, designadas como Hard Constraints. É preciso instruir o modelo com uma diretiva primária que proíba explicitamente o fornecimento da resposta final ou da fórmula completa, obrigando-o, em vez disso, a recusar gentilmente o pedido direto e a perguntar ao estudante qual é o primeiro passo lógico a dar.

Um prompt eficaz deve seguir uma arquitetura modular que inclua a definição da persona e um algoritmo comportamental rigoroso. É fundamental estabelecer um loop de interação em que a IA analisa o input, avalia se o utilizador cometeu erros lógicos e avança apenas um passo de cada vez, utilizando técnicas de Chain of Thought implícita para não saltar para conclusões.

Em caso de fuga da solução, é útil reforçar o System Prompt elevando a prioridade da restrição a uma questão de segurança. Recomenda-se adicionar instruções que equiparem a proibição de dar respostas a uma norma de segurança crítica para o utilizador, uma vez que os modelos modernos tendem a respeitar mais as diretivas ligadas à safety do que as simples regras de estilo.

O sistema deve ser programado para evitar a preguiça ou respostas genéricas como «Tenta novamente». Se o estudante cometer erros repetidos ou não tiver ideias, a IA deve fornecer pequenas pistas progressivas (hints) ou analogias concretas, sem nunca revelar a solução inteira, mas ajudando o utilizador a desbloquear o passo lógico individual que está a enfrentar.

Achou este artigo útil? Há outro assunto que gostaria de me ver abordar?

Escreva nos comentários aqui em baixo! Inspiro-me diretamente nas vossas sugestões.