Em Resumo (TL;DR)

A abordagem FinOps transforma a infraestrutura cloud de centro de custo em recurso estratégico, focando-se na sustentabilidade económica das transações individuais.

A utilização de instâncias Spot e o auto-scaling baseado em métricas personalizadas garantem elevado desempenho reduzindo drasticamente as despesas de computação.

Uma gestão rigorosa do tráfego de dados e das tags permite identificar os custos invisíveis e otimizar a margem da empresa.

O diabo está nos detalhes. 👇 Continue lendo para descobrir os passos críticos e as dicas práticas para não errar.

No panorama tecnológico de 2026, para um empreendedor técnico ou um CTO de uma realidade Fintech, a infraestrutura já não é apenas um centro de custo, mas um ativo estratégico que determina a margem do negócio. A otimização de custos cloud já não diz respeito simplesmente à redução da fatura no final do mês; é uma disciplina de engenharia complexa que requer uma abordagem cultural conhecida como FinOps. Em ambientes de alta carga, onde a escalabilidade deve garantir a continuidade operacional financeira (pense-se no trading de alta frequência ou na gestão de hipotecas em tempo real), cortar custos sem critério é um risco inaceitável.

Este guia técnico explora como aplicar metodologias FinOps avançadas em plataformas como AWS e Google Cloud, superando o conceito básico de rightsizing para abraçar arquiteturas elásticas, tiering inteligente de armazenamento e gestão granular do tráfego de dados.

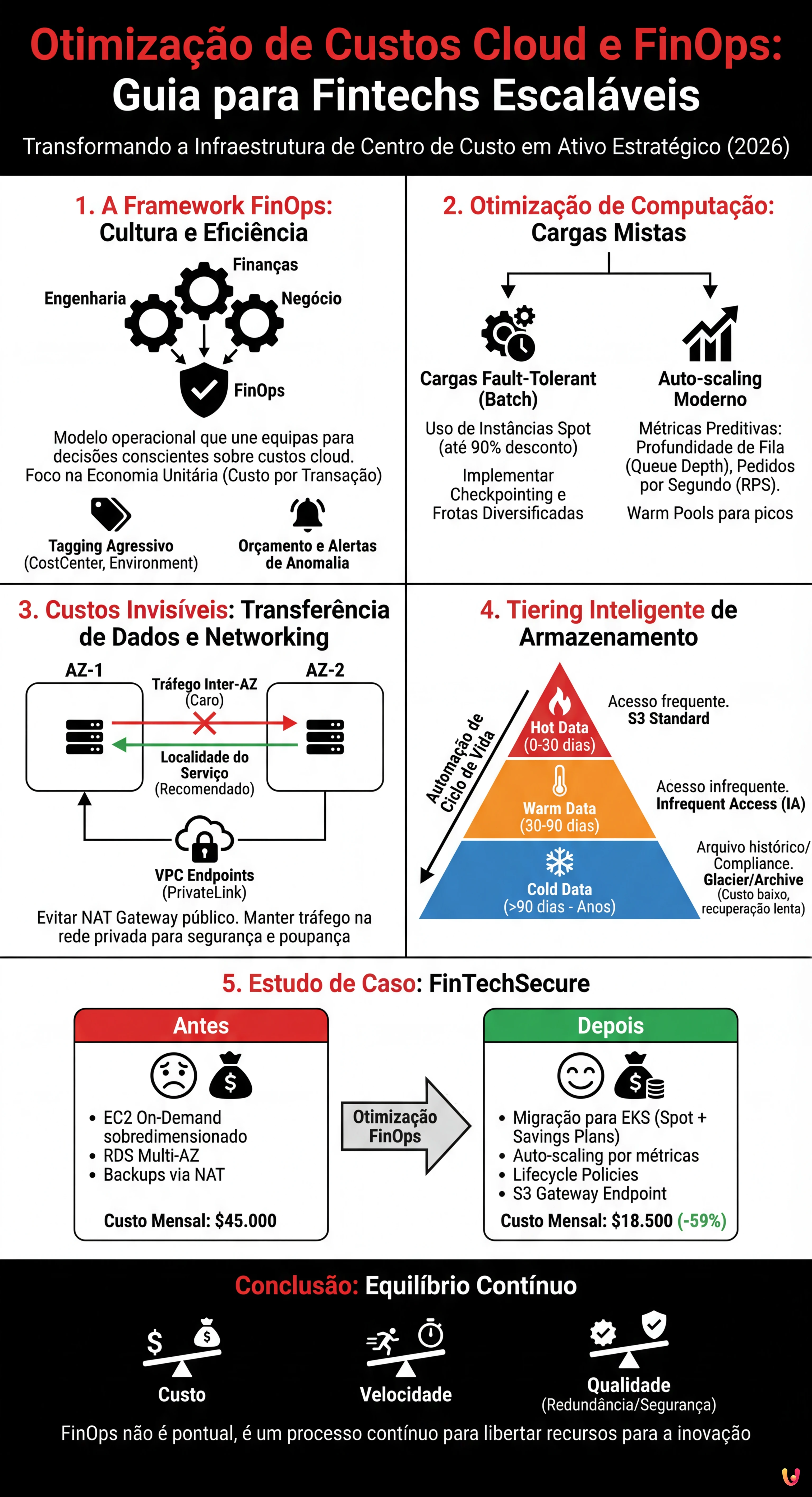

1. A Framework FinOps: Para Além da Poupança, Rumo à Eficiência

Segundo a FinOps Foundation, o FinOps é um modelo operacional para a cloud que combina sistemas, boas práticas e cultura para aumentar a capacidade de uma organização compreender os custos da cloud e tomar decisões de negócio conscientes. Numa Fintech, isto significa que cada engenheiro deve estar ciente do impacto económico de uma linha de código ou de uma escolha arquitetural.

Pré-requisitos para a Otimização

Antes de implementar alterações técnicas, é necessário estabelecer uma base de observabilidade:

- Estratégia de Tagging Agressiva: Cada recurso deve ter tags obrigatórias (ex:

CostCenter,Environment,ServiceOwner). Sem isto, a atribuição de custos é impossível. - Orçamento e Alertas: Configuração de AWS Budgets ou GCP Budget Alerts não apenas em limites fixos, mas em anomalias de tendência (ex: um pico repentino de chamadas API).

- Economia Unitária (Unit Economics): Definir o custo por transação ou por utilizador ativo. O objetivo não é baixar o custo total se o negócio crescer, mas baixar o custo unitário.

2. Otimização de Computação: Estratégias para Cargas de Trabalho Mistas

A maior rubrica de despesa está frequentemente ligada aos recursos de computação (EC2 na AWS, Compute Engine na GCP). Eis como otimizar em cenários de alta carga.

Uso Estratégico de Instâncias Spot

As Instâncias Spot (ou Preemptible VMs na GCP) oferecem descontos até 90%, mas podem ser terminadas pelo fornecedor com pouco aviso prévio. No âmbito Fintech, o uso das Spot é frequentemente temido devido à criticidade dos dados, mas é um receio infundado se gerido arquiteturalmente.

Cenário de Aplicação: Processamento em Batch Noturno.

Consideremos o cálculo dos juros sobre hipotecas ou a geração de relatórios normativos que ocorre todas as noites. Esta é uma carga de trabalho fault-tolerant (tolerante a falhas).

- Estratégia: Utilizar frotas de instâncias Spot para os nós de trabalho (worker nodes) que processam os dados, mantendo as instâncias On-Demand apenas para a orquestração (ex: o nó mestre de um cluster Kubernetes ou EMR).

- Implementação: Configurar a aplicação para gerir o “checkpointing”. Se uma instância Spot for terminada, o job deve retomar a partir do último checkpoint guardado numa base de dados ou no S3/GCS, sem perda de dados.

- Diversificação: Não apostar num único tipo de instância. Utilizar Spot Fleets que requerem diversas famílias de instâncias (ex: m5.large, c5.large, r5.large) para minimizar o risco de indisponibilidade simultânea.

Auto-scaling Baseado em Métricas Personalizadas

O auto-scaling baseado na CPU é obsoleto para aplicações modernas. Frequentemente, uma CPU a 40% esconde uma latência inaceitável para o utilizador final.

Para uma plataforma Fintech escalável, as políticas de scaling devem ser agressivas e preditivas:

- Métricas de Fila (Queue Depth): Se utilizarem Kafka ou SQS/PubSub, escalem com base no número de mensagens na fila ou no consumer lag. É inútil adicionar servidores se a fila estiver vazia, mas é vital adicioná-los instantaneamente se a fila ultrapassar as 1000 mensagens, independentemente da CPU.

- Pedidos por Segundo (RPS): Para as API Gateway, escalem com base no throughput dos pedidos.

- Warm Pools: Manter um pool de instâncias pré-inicializadas (em estado stopped ou hibernate) para reduzir os tempos de arranque durante os picos de tráfego de mercado (ex: abertura da bolsa).

3. Transferência de Dados e Networking: Os Custos Invisíveis

Muitas empresas concentram-se na computação e ignoram o custo do movimento de dados, que pode representar 20-30% da fatura em arquiteturas de microsserviços.

Otimização do Tráfego Inter-AZ e Inter-Region

Numa arquitetura de alta disponibilidade, os dados viajam entre diferentes Zonas de Disponibilidade (AZ). A AWS e a GCP cobram este tráfego.

- Localidade do Serviço (Service Locality): Tentem manter o tráfego dentro da mesma AZ quando possível. Por exemplo, certifiquem-se de que o microsserviço A na AZ-1 chama preferencialmente a instância do microsserviço B na AZ-1.

- VPC Endpoints (PrivateLink): Evitem passar pelo NAT Gateway para alcançar serviços como S3 ou DynamoDB. O uso de VPC Endpoints mantém o tráfego na rede privada do fornecedor, reduzindo os custos de processamento de dados do NAT Gateway (que são significativos para altos volumes) e melhorando a segurança.

4. Tiering de Armazenamento: Gestão do Ciclo de Vida do Dado Financeiro

As normativas financeiras (RGPD, PCI-DSS, MiFID II) impõem a conservação dos dados por anos. Manter tudo em armazenamento de alto desempenho (ex: S3 Standard) é um desperdício enorme.

Tiering Inteligente e Políticas de Ciclo de Vida

A otimização de custos cloud passa pela automação do ciclo de vida do dado:

- Hot Data (0-30 dias): Logs transacionais recentes, dados ativos. Storage Standard.

- Warm Data (30-90 dias): Histórico recente para apoio ao cliente. Infrequent Access (IA).

- Cold Data (90 dias – 10 anos): Backups históricos, logs de auditoria. Utilizar classes como S3 Glacier Deep Archive ou GCP Archive. O custo é uma fração do standard, mas o tempo de recuperação é de horas (aceitável para uma auditoria).

- Automação: Utilizar S3 Intelligent-Tiering para mover automaticamente os dados entre os tiers com base nos padrões de acesso reais, sem ter de escrever scripts complexos.

5. Estudo de Caso: Otimização da Infraestrutura “FinTechSecure”

Analisemos um caso teórico baseado em cenários reais de migração e otimização.

Situação Inicial:

A startup “FinTechSecure” gere pagamentos P2P. A infraestrutura está na AWS, inteiramente baseada em instâncias EC2 On-Demand sobredimensionadas para gerir os picos da Black Friday, com base de dados RDS Multi-AZ. Custo mensal: $45.000.

Análise FinOps:

1. As instâncias EC2 têm uma média de utilização de CPU de 15%.

2. Os logs de acesso são conservados no S3 Standard indefinidamente.

3. O tráfego de dados através do NAT Gateway é altíssimo devido aos backups para o S3.

Intervenções Executadas:

- Computação: Migração das cargas stateless para contentores (EKS) utilizando Instâncias Spot para 70% dos nós e Savings Plans para os restantes 30% (nós base). Implementação de auto-scaling baseado em métricas personalizadas (número de transações em fila).

- Armazenamento: Ativação de Lifecycle Policy para mover os logs para Glacier após 30 dias e eliminá-los após 7 anos (compliance).

- Networking: Implementação de S3 Gateway Endpoint para eliminar os custos de NAT Gateway para o tráfego em direção ao armazenamento.

Resultado Final:

O custo mensal desceu para $18.500 (-59%), mantendo o mesmo SLA de disponibilidade (99.99%) e melhorando a velocidade de scaling durante os picos imprevistos.

Conclusões

A otimização de custos cloud no âmbito Fintech não é uma atividade pontual, mas um processo contínuo. Requer o equilíbrio de três variáveis: custo, velocidade e qualidade (redundância/segurança). Ferramentas como as Instâncias Spot, as políticas de Lifecycle e uma monitorização granular permitem construir infraestruturas resilientes que escalam economicamente juntamente com o negócio. Para o empreendedor técnico, dominar o FinOps significa libertar recursos financeiros para reinvestir em inovação e desenvolvimento de produto.

Perguntas frequentes

O FinOps é um modelo operacional cultural que une engenharia, finanças e negócio para otimizar a despesa na cloud. Nas empresas Fintech, esta abordagem é crucial porque transforma a infraestrutura de simples centro de custo em ativo estratégico, permitindo calcular o impacto económico de cada escolha técnica (Unit Economics) e garantindo que a escalabilidade tecnológica seja financeiramente sustentável mesmo durante picos de mercado de alta carga.

Embora as Instâncias Spot possam ser terminadas com pouco aviso prévio, podem ser utilizadas em segurança no âmbito financeiro para cargas de trabalho tolerantes a falhas, como o cálculo noturno de juros ou a elaboração de relatórios. A estratégia correta prevê a implementação de checkpointing para guardar os progressos, o uso de frotas mistas de instâncias para diversificar o risco e a manutenção de nós On-Demand para a orquestração do cluster.

O auto-scaling baseado apenas na percentagem de CPU é frequentemente obsoleto para as modernas plataformas Fintech. É preferível adotar estratégias agressivas baseadas em métricas personalizadas como a profundidade das filas (Queue Depth) dos sistemas de mensagens ou o número de pedidos por segundo (RPS). Além disso, a utilização de Warm Pools com instâncias pré-inicializadas ajuda a gerir latências zero durante a abertura dos mercados ou eventos de tráfego repentino.

Os custos de networking podem representar até 30% da fatura cloud. Para reduzi-los, é necessário otimizar a Localidade do Serviço mantendo o tráfego entre microsserviços dentro da mesma Zona de Disponibilidade. Além disso, é fundamental utilizar VPC Endpoints (PrivateLink) para a ligação a serviços geridos como o armazenamento, evitando assim os dispendiosos encargos de processamento de dados associados ao uso de NAT Gateways públicos.

Para respeitar normativas como o RGPD ou PCI-DSS sem desperdiçar orçamento, é essencial implementar o tiering inteligente de armazenamento. Os dados ativos (Hot) permanecem em armazenamento standard, enquanto os logs históricos e os backups (Cold) são movidos automaticamente através de Lifecycle Policies para classes de arquivo profundo como Glacier ou Archive, que têm custos extremamente reduzidos mas tempos de recuperação mais longos, ideais para auditorias raras.

Achou este artigo útil? Há outro assunto que gostaria de me ver abordar?

Escreva nos comentários aqui em baixo! Inspiro-me diretamente nas vossas sugestões.