Em Resumo (TL;DR)

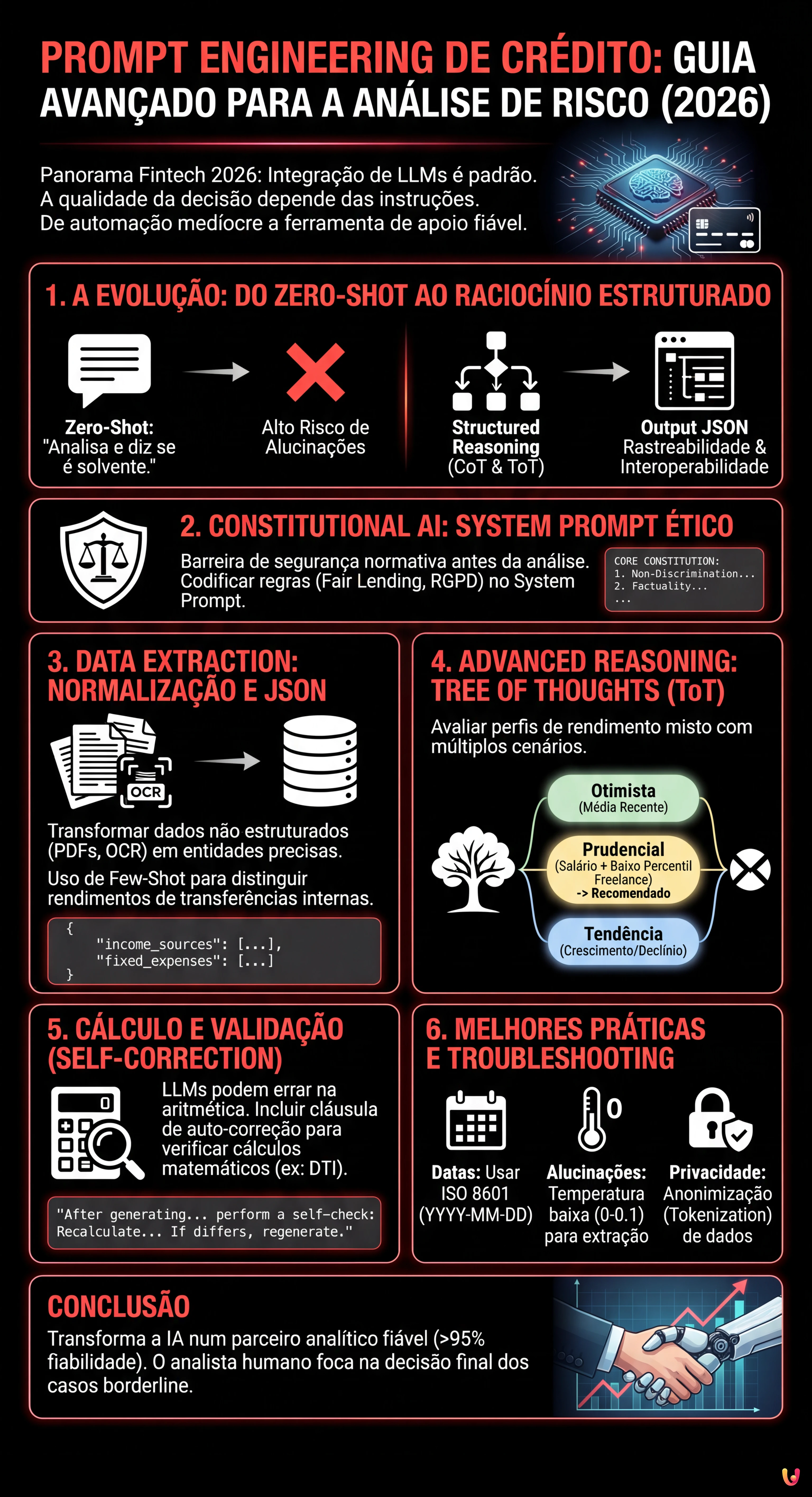

A evolução do prompt engineering financeiro requer arquiteturas cognitivas complexas para transformar a automação num apoio à decisão fiável e rastreável.

A adoção da Constitutional AI define perímetros éticos e normativos rigorosos no System Prompt para garantir imparcialidade e respeito pelas regras.

Estratégias avançadas como a Tree of Thoughts permitem estruturar dados financeiros ambíguos e calcular cenários de risco ponderados e prudentes.

O diabo está nos detalhes. 👇 Continue lendo para descobrir os passos críticos e as dicas práticas para não errar.

No panorama fintech de 2026, a integração de Large Language Models (LLM) nos fluxos de trabalho financeiros é já um padrão consolidado. No entanto, a diferença entre uma automação medíocre e uma ferramenta de apoio à decisão fiável reside inteiramente na qualidade das instruções fornecidas. O prompt engineering de crédito já não diz respeito à simples interrogação de um modelo, mas sim à conceção de arquiteturas cognitivas capazes de gerir a ambiguidade intrínseca dos dados financeiros.

Este guia técnico destina-se a Cientistas de Dados, Analistas de Risco de Crédito e programadores Fintech que necessitam de ir além dos prompts básicos para implementar lógicas de raciocínio complexo (Reasoning Models) na avaliação do mérito creditício.

1. A Evolução: Do Zero-Shot ao Raciocínio Estruturado

Até há poucos anos, a abordagem padrão era pedir ao modelo: “Analisa este extrato bancário e diz-me se o cliente é solvente”. Esta abordagem Zero-Shot é hoje considerada negligente no âmbito bancário devido à elevada taxa de alucinações e à falta de rastreabilidade do raciocínio.

Para uma análise de risco robusta, devemos adotar técnicas avançadas como a Chain-of-Thought (CoT) e a Tree of Thoughts (ToT), encapsuladas em outputs estruturados (JSON) para garantir a interoperabilidade com os sistemas bancários legados.

2. Constitutional AI: O System Prompt Ético e Normativo

Antes de analisar os números, é imperativo estabelecer o perímetro ético. Em linha com os princípios da Constitutional AI (popularizada por laboratórios como a Anthropic e agora padrão da indústria), o System Prompt deve agir como uma barreira de segurança normativa. Não basta dizer “não sejas racista”; é necessário codificar as normativas (ex: Fair Lending, RGPD).

Template de System Prompt para Compliance

You are a Senior Credit Risk Analyst AI, acting as an impartial assistant to a human underwriter.

CORE CONSTITUTION:

1. **Non-Discrimination:** You must NEVER use demographic data (name, gender, ethnicity, zip code) as a factor in risk assessment, even if present in the input text.

2. **Factuality:** You must only calculate metrics based on the provided transaction data. Do not infer income sources not explicitly listed.

3. **Explainability:** Every conclusion regarding debt-to-income (DTI) ratio must be accompanied by a step-by-step calculation reference.

OUTPUT FORMAT:

All responses must be valid JSON adhering to the schema provided in the user prompt.3. Data Extraction: Normalização de Extratos Bancários Não Padronizados

O principal desafio no prompt engineering de crédito é a variabilidade dos dados de entrada (PDFs digitalizados, CSVs desorganizados). O objetivo é transformar texto não estruturado em entidades financeiras precisas.

Utilizaremos uma abordagem Few-Shot Prompting para ensinar o modelo a distinguir entre rendimentos reais e transferências internas (giros), que muitas vezes inflacionam artificialmente o rendimento auferido.

Técnica de Extração JSON

Aqui está um exemplo de prompt para extrair e categorizar as transações:

**TASK:** Extract financial entities from the following OCR text of a bank statement.

**RULES:**

- Ignore internal transfers (labeled "GIRO", "TRANSFERÊNCIA").

- Categorize "Transferência Salário" or "Vencimento" as 'SALARY'.

- Categorize recurring negative transactions matching loan providers as 'DEBT_REPAYMENT'.

**INPUT TEXT:**

[Inserir aqui o texto bruto do OCR]

**REQUIRED OUTPUT (JSON):**

{

"income_sources": [

{"date": "YYYY-MM-DD", "amount": float, "description": "string", "category": "SALARY|DIVIDEND|OTHER"}

],

"fixed_expenses": [

{"date": "YYYY-MM-DD", "amount": float, "description": "string", "category": "MORTGAGE|LOAN|RENT"}

]

}4. Advanced Reasoning: Gestão de Rendimento Misto (CoT & ToT)

A verdadeira prova de fogo é o cálculo do rendimento disponível para perfis híbridos (ex: trabalhador por conta de outrem com atividade independente/Recibos Verdes). Aqui, um prompt linear falha. Devemos usar a Tree of Thoughts para explorar diferentes interpretações da estabilidade financeira.

Aplicação da Tree of Thoughts (ToT)

Em vez de pedir um único valor, pedimos ao modelo para gerar três cenários de avaliação e depois convergir para o mais prudente.

Prompt Estruturado ToT:

**SCENARIO:** The applicant has a mixed income: fixed salary + variable freelance invoices.

**INSTRUCTION:** Use a Tree of Thoughts approach to evaluate the monthly disposable income.

**BRANCH 1 (Optimistic):** Calculate average income over the last 12 months, assuming freelance work continues at current pace.

**BRANCH 2 (Pessimistic/Prudential):** Consider only the fixed salary and the lowest 20% percentile of freelance months. Discount freelance income by 30% for tax estimation.

**BRANCH 3 (Trend-Based):** Analyze the slope of income over the last 6 months. Is it declining or growing?

**SYNTHESIS:** Compare the three branches. Recommend the 'Prudential' figure for the Debt-to-Income (DTI) calculation but note the 'Trend' if positive.

**OUTPUT:**

{

"analysis_branches": {

"optimistic_monthly": float,

"prudential_monthly": float,

"trend_direction": "positive|negative|neutral"

},

"final_recommendation": {

"accepted_monthly_income": float,

"reasoning_summary": "string"

}

}Esta abordagem força o modelo a simular o raciocínio de um analista humano experiente que pondera os riscos antes de definir o número final.

5. Cálculo de Índices e Validação (Self-Correction)

Uma vez estabelecido o rendimento (denominador) e as dívidas existentes (numerador), o cálculo da Taxa de Esforço (DTI) é matemático. No entanto, os LLM podem errar nos cálculos aritméticos. Em 2026, é prática comum invocar ferramentas externas (Code Interpreter ou Python Sandbox) através do prompt, mas se for utilizado um modelo puro, é necessário um passo de Self-Correction.

Adicionar esta cláusula no final do prompt:

“After generating the JSON, perform a self-check: Recalculate (Total_Debt / Accepted_Income) * 100. If the result differs from your JSON output, regenerate the JSON with the corrected value.”

6. Troubleshooting e Melhores Práticas

- Gestão de Datas: Os LLM confundem frequentemente os formatos de data (US vs EU). Especificar sempre

ISO 8601 (YYYY-MM-DD)no system prompt. - Alucinações sobre Nomes: Se o OCR estiver “sujo”, o modelo pode inventar nomes de bancos. Definir a

temperaturepara 0 ou 0.1 para tarefas de extração. - Privacidade: Garantir que os dados enviados via API são anonimizados (Tokenization) antes de serem inseridos no prompt, a menos que se utilize uma instância LLM on-premise ou Enterprise com acordos de não-treino.

Conclusões

O prompt engineering de crédito avançado transforma a IA de um simples leitor de documentos num parceiro analítico. Utilizando estruturas como a Tree of Thoughts e restrições constitucionais rígidas, é possível automatizar a pré-análise de situações financeiras complexas com um grau de fiabilidade superior a 95%, deixando ao analista humano apenas a decisão final sobre os casos borderline.

Perguntas frequentes

O prompt engineering no setor do crédito é a conceção avançada de arquiteturas cognitivas para Large Language Models, destinada a avaliar o mérito creditício com precisão. Ao contrário da abordagem padrão ou Zero-Shot, que se limita a interrogar o modelo de forma direta arriscando alucinações, esta metodologia utiliza técnicas como a Chain-of-Thought e outputs estruturados em JSON. O objetivo é transformar a IA de um simples leitor numa ferramenta de apoio à decisão capaz de gerir a ambiguidade dos dados financeiros e garantir a rastreabilidade do raciocínio.

O método Tree of Thoughts é fundamental para gerir perfis financeiros complexos, como aqueles com rendimentos mistos de trabalho dependente e independente. Em vez de pedir um único valor imediato, esta técnica instrui o modelo a gerar múltiplos ramos de raciocínio, simulando cenários otimistas, pessimistas e baseados em tendências históricas. O sistema compara depois estas variantes para convergir numa recomendação final prudencial, replicando o processo mental de um analista humano experiente que avalia diversas hipóteses antes de decidir.

A Constitutional AI age como uma barreira de segurança ética e normativa inserida diretamente no System Prompt do modelo. Esta técnica impõe regras invioláveis antes mesmo de iniciar a análise dos dados, como a proibição absoluta de utilizar informações demográficas para evitar discriminações e a obrigação de se basear exclusivamente em dados factuais presentes nas transações. Desta forma, codificam-se diretivas como o Fair Lending e o RGPD diretamente na lógica da inteligência artificial, assegurando que cada output está em conformidade com os padrões legais do setor.

Para minimizar as alucinações durante o processamento de documentos não estruturados como PDFs ou digitalizações OCR, utilizam-se configurações específicas e técnicas de prompting. É essencial definir a temperatura do modelo para valores próximos de zero para reduzir a criatividade e adotar o Few-Shot Prompting, fornecendo exemplos concretos de como distinguir rendimentos reais de transferências internas. Além disso, o uso de outputs forçados em formato JSON ajuda a canalizar as respostas para esquemas rígidos, prevenindo a invenção de dados ou nomes de instituições bancárias inexistentes.

Apesar das capacidades linguísticas avançadas, os modelos LLM podem cometer erros em cálculos aritméticos puros, como a determinação da taxa de esforço (DTI). A self-correction é uma cláusula inserida no final do prompt que obriga o modelo a executar uma verificação autónoma do resultado matemático acabado de gerar. Se o recálculo diferir do output inicial, o sistema é instruído a regenerar a resposta correta, garantindo que os dados numéricos utilizados para a avaliação do risco são matematicamente coerentes e fiáveis.

Achou este artigo útil? Há outro assunto que gostaria de me ver abordar?

Escreva nos comentários aqui em baixo! Inspiro-me diretamente nas vossas sugestões.