En Bref (TL;DR)

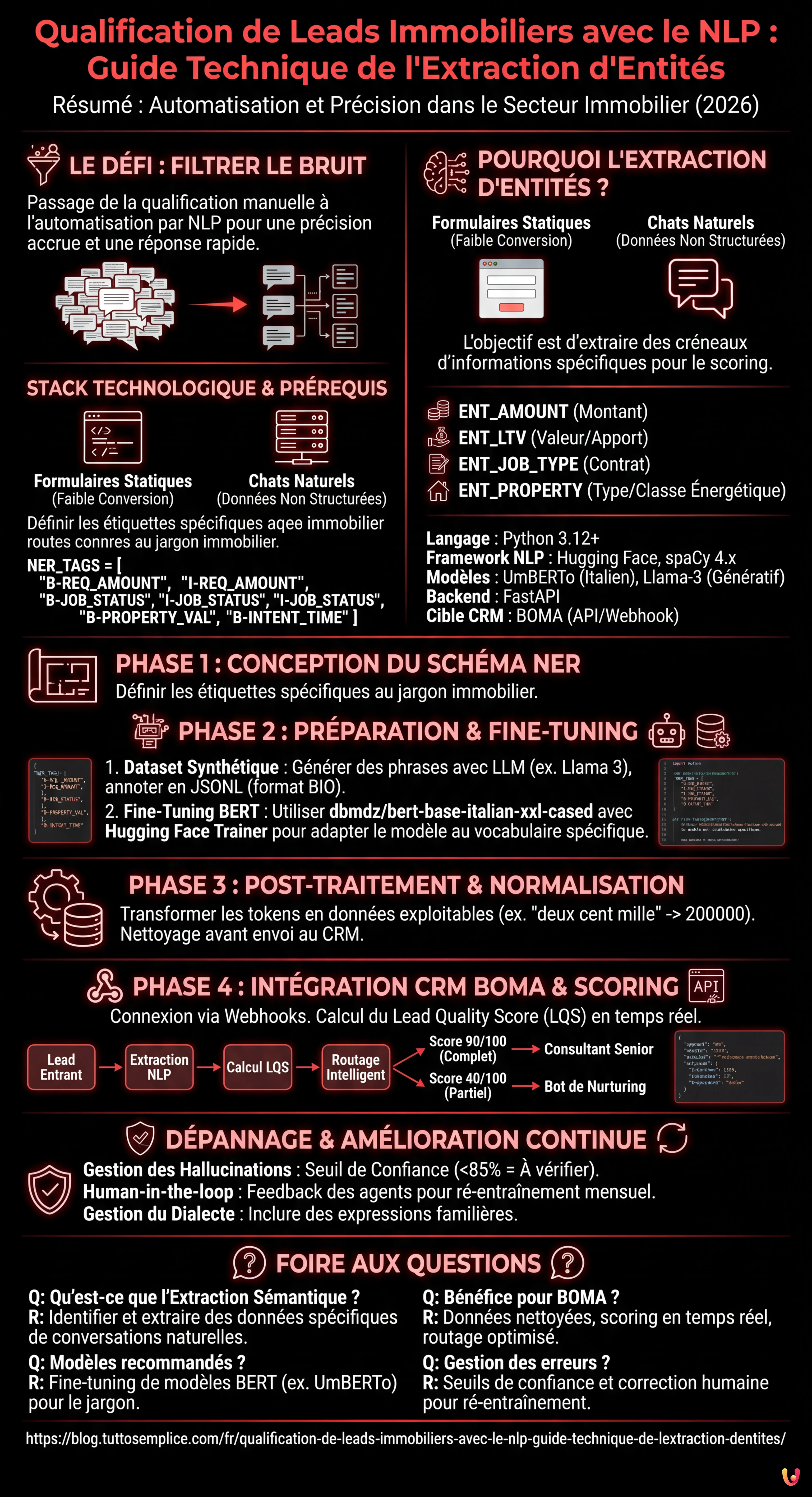

L’automatisation via le NLP transforme la qualification des leads immobiliers, dépassant les formulaires statiques pour extraire des données précises de conversations naturelles.

Le fine-tuning de modèles BERT permet de créer des systèmes NER personnalisés capables d’identifier montants, professions et types de biens.

La normalisation des données extraites et l’intégration directe dans le CRM BOMA optimisent le calcul de la notation de crédit et la gestion commerciale.

Le diable est dans les détails. 👇 Continuez à lire pour découvrir les étapes critiques et les conseils pratiques pour ne pas vous tromper.

Dans le paysage concurrentiel de 2026, la vitesse de réponse n’est plus le seul facteur déterminant dans le secteur du crédit et de l’immobilier. Le véritable défi réside dans la précision et la capacité à filtrer le bruit. La qualification de leads immobiliers est passée d’une tâche manuelle effectuée par des centres d’appels à un processus automatisé guidé par des algorithmes de Traitement du Langage Naturel (NLP). Dans ce guide technique, nous explorerons comment construire un système de Reconnaissance d’Entités Nommées (NER) personnalisé pour extraire des données structurées de conversations non structurées et les intégrer directement dans le CRM BOMA.

Pourquoi l’Extraction d’Entités change la Qualification des Leads Immobiliers

Les formulaires statiques sur les sites web (Nom, Prénom, Téléphone) ont des taux de conversion de plus en plus bas. Les utilisateurs préfèrent interagir via des chats naturels ou des messages vocaux. Cependant, cela génère des données non structurées difficiles à traiter. C’est là qu’intervient l’Extraction d’Entités Sémantique.

L’objectif n’est pas seulement de comprendre l’intention (ex. “je veux un prêt”), mais d’extraire des créneaux d’informations spécifiques nécessaires au calcul de la notation de crédit ou à la faisabilité de l’achat. Un système bien conçu doit identifier :

- ENT_AMOUNT : Le montant demandé (ex. “j’ai besoin de 200k”).

- ENT_LTV : Le Loan-to-Value implicite ou la valeur du bien.

- ENT_JOB_TYPE : Le type de contrat (ex. “CDI”, “Auto-entrepreneur”).

- ENT_PROPERTY : Type de bien et classe énergétique.

Prérequis et Stack Technologique

Pour suivre ce guide, une connaissance intermédiaire de Python et des principes de Machine Learning est nécessaire. Nous utiliserons la stack suivante, standardisée pour 2026 :

- Langage : Python 3.12+

- Framework NLP : Hugging Face Transformers, spaCy 4.x

- Modèles de Base :

UmBERTo(pour l’italien) ou versions quantifiées deLlama-3-8B-Instructpour les tâches génératives. - Backend : FastAPI pour l’exposition du modèle.

- Cible CRM : BOMA (via API REST/Webhook).

Phase 1 : Conception du Schéma des Entités

Avant d’écrire du code, nous devons définir ce que notre modèle doit chercher. Dans le contexte des prêts immobiliers, le jargon est spécifique. Un modèle générique échouerait à distinguer entre “apport” et “mensualité”.

Définissons les étiquettes pour notre dataset d’entraînement :

NER_TAGS = [

"O", # Outside (aucune entité)

"B-REQ_AMOUNT", # Début montant demandé

"I-REQ_AMOUNT", # Intérieur montant demandé

"B-JOB_STATUS", # Début statut professionnel

"I-JOB_STATUS", # Intérieur statut professionnel

"B-PROPERTY_VAL", # Valeur du bien

"B-INTENT_TIME" # Délai souhaité (ex. "acte d'ici mars")

]

Phase 2 : Préparation du Dataset et Fine-Tuning

Pour obtenir une qualification de leads immobiliers précise, nous ne pouvons pas nous fier à des modèles généralistes zero-shot pour l’extraction massive, car ils sont coûteux et lents. La meilleure solution est le fine-tuning d’un modèle basé sur BERT.

1. Création du Dataset Synthétique

Si vous ne disposez pas d’historiques de chat conformes au RGPD, vous pouvez générer un dataset synthétique en utilisant un LLM (comme Meta AI Llama 3) pour créer des milliers de variations de phrases typiques :

“Je suis fonctionnaire et je cherche un prêt pour une maison de 250 000 euros, j’ai 50k d’apport.”

Annotez ces phrases au format JSONL standard pour l’entraînement (format BIO).

2. Fine-Tuning avec Hugging Face

Nous utiliserons dbmdz/bert-base-italian-xxl-cased comme base, étant l’un des modèles les plus performants sur la syntaxe (dans le cas d’un traitement en italien). Voici un snippet simplifié pour la boucle d’entraînement :

from transformers import AutoTokenizer, AutoModelForTokenClassification, TrainingArguments, Trainer

model_name = "dbmdz/bert-base-italian-xxl-cased"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForTokenClassification.from_pretrained(model_name, num_labels=len(NER_TAGS))

args = TrainingArguments(

output_dir="./boma-ner-v1",

evaluation_strategy="epoch",

learning_rate=2e-5,

per_device_train_batch_size=16,

num_train_epochs=5,

weight_decay=0.01,

)

# En supposant que 'tokenized_datasets' soit déjà préparé

trainer = Trainer(

model=model,

args=args,

train_dataset=tokenized_datasets["train"],

eval_dataset=tokenized_datasets["validation"],

tokenizer=tokenizer,

)

trainer.train()

Ce processus adapte les poids du modèle pour reconnaître spécifiquement des termes comme “rachat”, “taux fixe” ou “conseiller” dans le contexte de la phrase.

Phase 3 : Post-Traitement et Normalisation

Le modèle NER renvoie des tokens et des étiquettes. Pour la qualification de leads immobiliers, nous devons transformer "deux cent mille euros" en 200000 (Integer). Cette phase de normalisation est critique pour peupler la base de données.

Nous utilisons des bibliothèques comme word2number ou des regex personnalisées pour nettoyer la sortie du modèle avant l’envoi au CRM.

Phase 4 : Intégration dans le CRM BOMA

Une fois que le modèle est exposé via API (ex. sur un conteneur Docker), nous devons le connecter au flux d’entrée des leads. L’intégration avec BOMA se fait généralement via des webhooks qui se déclenchent à la réception d’un nouveau message.

Logique de Scoring et de Routage

Tous les leads ne se valent pas. En utilisant les données extraites, nous pouvons calculer un Lead Quality Score (LQS) en temps réel :

- Lead A (Score 90/100) : Données complètes (Travail, Montant, Bien), LTV Routage immédiat vers le Consultant Senior.

- Lead B (Score 40/100) : Données partielles, LTV > 95%, CDD. -> Routage vers le Bot de Nurturing automatique.

Voici un exemple de payload JSON à envoyer aux API de BOMA :

{

"lead_source": "Whatsapp_Business",

"message_body": "Bonjour, je voudrais des infos pour un prêt première maison, je suis infirmier",

"extracted_data": {

"job_type": "infirmier",

"job_category": "fonction_publique",

"intent": "achat_residence_principale"

},

"ai_score": 75,

"routing_action": "assign_to_human"

}

Dépannage : Gestion des Hallucinations et Ambiguïtés

Même les meilleurs modèles peuvent se tromper. Voici comment atténuer les risques :

- Seuil de Confiance (Confidence Threshold) : Si le modèle extrait une entité avec une confiance inférieure à 85%, le système doit marquer le champ comme “À vérifier” dans le CRM BOMA, nécessitant une intervention humaine.

- Human-in-the-loop : Implémenter un mécanisme de feedback où les agents immobiliers peuvent corriger l’étiquetage dans le CRM. Ces données corrigées doivent réintégrer le dataset d’entraînement pour le ré-entraînement mensuel du modèle.

- Gestion du Dialecte : Entraîner le modèle sur des datasets qui incluent des expressions familières ou régionales souvent utilisées dans les chats informels.

Conclusions

L’implémentation d’un système d’Extraction d’Entités pour la qualification de leads immobiliers n’est plus un exercice académique, mais une nécessité opérationnelle. En automatisant l’extraction des données critiques (LTV, travail, budget) et en les intégrant directement dans BOMA, les agences peuvent réduire le temps de premier contact de plusieurs heures à quelques secondes, en attribuant les dossiers les plus complexes aux meilleurs consultants et en laissant à l’IA la gestion du tri initial.

Foire aux questions

Il s’agit d’un processus basé sur le NLP qui identifie et extrait des données spécifiques, comme le montant du prêt ou le type de contrat, à partir de conversations naturelles et non structurées. Contrairement aux formulaires statiques, cette technologie permet de comprendre l’intention de l’utilisateur et de remplir automatiquement les champs nécessaires au calcul de la notation de crédit directement dans le CRM.

Pour obtenir de hautes performances sur la syntaxe (notamment italienne comme cité dans le guide), le meilleur choix se porte sur le fine-tuning de modèles basés sur BERT comme UmBERTo ou dbmdz bert-base-italian. Ces modèles sont supérieurs aux solutions généralistes zero-shot car ils peuvent être entraînés pour reconnaître le jargon spécifique du secteur du crédit, en distinguant des termes techniques comme « mensualité », « apport » ou « rachat ».

En intégrant un modèle d’extraction d’entités via API ou Webhook, BOMA peut recevoir des données déjà nettoyées et normalisées. Cela permet d’attribuer un score de qualité au lead en temps réel et d’acheminer automatiquement les contacts : les profils complets vont aux consultants seniors, tandis que les partiels sont gérés par des bots de nurturing, optimisant le temps de l’équipe de vente.

Un système bien conçu extrait des entités critiques comme le montant demandé, la valeur du bien pour le calcul du Loan-to-Value, le type de contrat de travail et la classe énergétique de la maison. Ces données, définies comme des slots d’information, sont essentielles pour déterminer immédiatement la faisabilité du dossier sans longues entrevues préliminaires.

Il est nécessaire d’implémenter un seuil de confiance, par exemple à 85 pour cent, en dessous duquel le système signale la donnée comme étant à vérifier manuellement. De plus, on adopte une approche human-in-the-loop où les corrections apportées par les agents immobiliers sont sauvegardées et réutilisées pour le réentraînement périodique du modèle, améliorant sa précision dans le temps.

Avez-vous trouvé cet article utile ? Y a-t-il un autre sujet que vous aimeriez que je traite ?

Écrivez-le dans les commentaires ci-dessous ! Je m'inspire directement de vos suggestions.