En Bref (TL;DR)

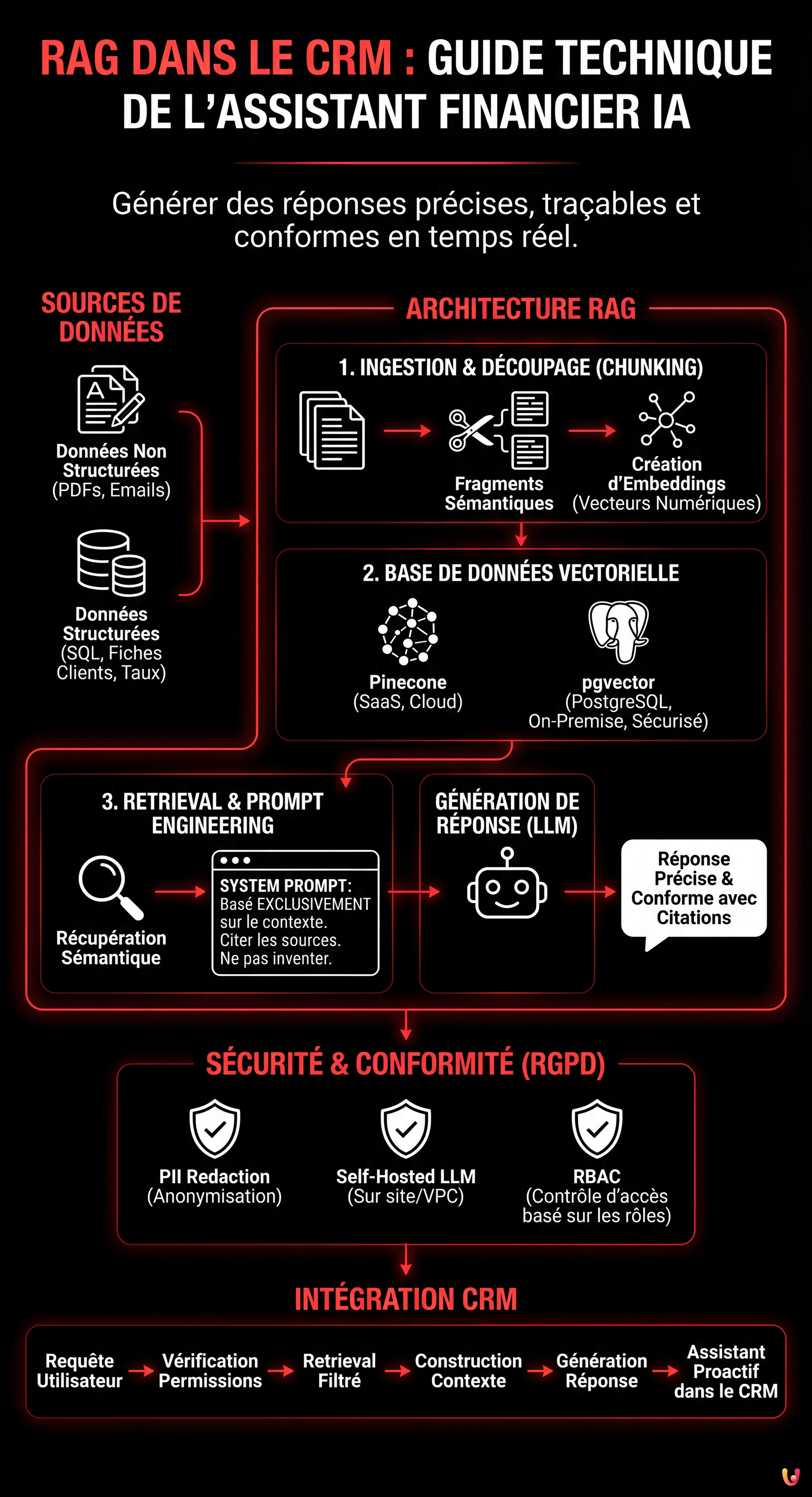

L’architecture RAG renforce les CRM financiers en consultant les réglementations et les données clients en temps réel pour générer des réponses précises et sans hallucinations.

Le pipeline technique intègre l’ingestion sémantique, les bases de données vectorielles et le prompt engineering pour transformer des documents complexes en conseils financiers sûrs et totalement traçables.

L’utilisation stratégique de pgvector et du chunking avancé permet de construire des assistants virtuels capables de pré-qualifier des leads et de gérer des prêts hypothécaires en garantissant la conformité.

Le diable est dans les détails. 👇 Continuez à lire pour découvrir les étapes critiques et les conseils pratiques pour ne pas vous tromper.

Nous sommes en 2026 et l’intégration de l’Intelligence Artificielle dans les systèmes d’entreprise n’est plus une nouveauté, mais une norme opérationnelle. Cependant, dans le secteur de la fintech et de l’immobilier, le défi n’est pas seulement de générer du texte, mais de générer des réponses précises, traçables et conformes. C’est là qu’intervient l’architecture RAG dans le CRM (Retrieval-Augmented Generation). Contrairement à un LLM générique qui se base uniquement sur son jeu d’entraînement (souvent daté), un système RAG permet à votre CRM propriétaire (comme BOMA ou des solutions personnalisées) de consulter en temps réel la documentation réglementaire, les taux d’intérêt actuels et l’historique du client avant de formuler une réponse.

Dans cette analyse technique approfondie (deep dive), nous explorerons comment construire un assistant financier intelligent capable de pré-qualifier des leads et de fournir des conseils sur les prêts hypothécaires, en minimisant les hallucinations et en garantissant une sécurité maximale des données.

L’Architecture RAG dans le Contexte Financier

L’implémentation du RAG dans le CRM nécessite un pipeline robuste composé de trois phases principales : Ingestion (préparation des données), Retrieval (récupération sémantique) et Generation (synthèse de la réponse). Dans le contexte d’un CRM financier, les données ne sont pas seulement du texte libre, mais une combinaison de :

- Données Non Structurées : PDF de réglementations bancaires, politiques de crédit, transcriptions d’emails.

- Données Structurées : Fiches clients, scoring de crédit, ratios LTV (Loan-to-Value) présents dans la base de données SQL.

L’objectif est de transformer ces données en vecteurs numériques (embeddings) que le LLM peut « comprendre » et interroger.

Étape 1 : Ingestion de Données et Découpage Stratégique (Chunking)

La première étape est la transformation de la documentation (ex. « Guide des Prêts 2026.pdf ») en fragments gérables. Nous ne pouvons pas passer un manuel entier de 500 pages dans la fenêtre de contexte du LLM. Nous devons diviser le texte en chunks.

Pour les documents financiers, un découpage basé purement sur les caractères est risqué car il pourrait couper une clause légale en deux. Nous utilisons une approche sémantique ou récursive.

Exemple de Code : Pipeline d’Ingestion avec LangChain

Voici comment implémenter une fonction Python pour traiter les documents et créer des embeddings en utilisant OpenAI (ou des modèles open-source équivalents).

from langchain_community.document_loaders import PyPDFLoader

from langchain_text_splitters import RecursiveCharacterTextSplitter

from langchain_openai import OpenAIEmbeddings

import os

# Configuration de la clé API (gérée via variables d'environnement pour la sécurité)

os.environ["OPENAI_API_KEY"] = "sk-..."

def process_financial_docs(file_path):

# 1. Chargement du document

loader = PyPDFLoader(file_path)

docs = loader.load()

# 2. Découpage Stratégique (Chunking)

# Taille de fragment de 1000 tokens avec chevauchement de 200 pour maintenir le contexte entre les fragments

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=1000,

chunk_overlap=200,

separators=["nn", "n", " ", ""]

)

splits = text_splitter.split_documents(docs)

# 3. Création des Embeddings

# Nous utilisons text-embedding-3-small pour un bon équilibre coût/performance

embeddings = OpenAIEmbeddings(model="text-embedding-3-small")

return splits, embeddingsÉtape 2 : Choix et Gestion de la Base de Données Vectorielle

Une fois les embeddings créés, où les stockons-nous ? Le choix de la base de données vectorielle est critique pour les performances du RAG dans le CRM.

- Pinecone : Solution gérée (SaaS). Excellente pour la scalabilité et la vitesse, mais les données résident sur des clouds tiers. Idéal si la politique de l’entreprise le permet.

- pgvector (PostgreSQL) : Le choix préféré pour les CRM propriétaires qui utilisent déjà Postgres. Permet d’exécuter des requêtes hybrides (ex. « trouver des documents sémantiquement similaires » ET « appartenant au client ID=123 »).

Si nous construisons un assistant financier interne, pgvector offre l’avantage de maintenir les données vectorielles dans le même périmètre de sécurité que les données financières structurées.

Étape 3 : Retrieval et Prompt Engineering Anti-Hallucination

Le cœur du système est la récupération des informations pertinentes. Lorsqu’un opérateur demande au CRM : « Le client Rossi peut-il accéder au Prêt Jeunes avec un ISEE de 35k ? », le système doit récupérer les politiques relatives au « Prêt Jeunes » et les limites ISEE.

Cependant, récupérer les données ne suffit pas. Nous devons instruire le LLM de ne pas inventer. Cela s’obtient via un System Prompt rigoureux.

Exemple de Prompt Engineering Avancé

Nous utilisons un modèle qui force l’IA à citer ses sources ou à admettre son ignorance.

SYSTEM_PROMPT = """

Vous êtes un Assistant Financier Senior intégré au CRM BOMA.

Votre tâche est de répondre aux questions en vous basant EXCLUSIVEMENT sur le contexte fourni ci-dessous.

RÈGLES OPÉRATIONNELLES :

1. Si la réponse n'est pas présente dans le contexte, vous devez répondre : "Je suis désolé, les politiques actuelles ne couvrent pas ce cas spécifique."

2. N'inventez pas de taux d'intérêt ou de règles non écrites.

3. Citez toujours le document de référence (ex. [Politique Hypothécaire v2.4]).

4. Gardez un ton professionnel et formel.

CONTEXTE :

{context}

QUESTION UTILISATEUR :

{question}

"""Étape 4 : Sécurité, PII et Conformité RGPD

Intégrer le RAG dans le CRM financier comporte des risques énormes liés à la confidentialité. Nous ne pouvons pas envoyer de données sensibles (PII – Personally Identifiable Information) comme des codes fiscaux, des noms complets ou des soldes bancaires directement aux API d’OpenAI ou d’Anthropic sans précautions, surtout sous le RGPD.

Stratégies de Protection (Guardrails)

- PII Redaction (Anonymisation) : Avant d’envoyer le prompt au LLM, utiliser des bibliothèques comme Microsoft Presidio pour identifier et masquer les données sensibles. « Mario Rossi » devient « <PERSON> ».

- Self-Hosted LLM : Pour une sécurité maximale, évaluer l’utilisation de modèles open-source comme Llama 3 ou Mistral, hébergés sur des serveurs propriétaires (on-premise ou VPC privé). Cela garantit qu’aucune donnée ne quitte jamais l’infrastructure de l’entreprise.

- Role-Based Access Control (RBAC) : Le système RAG doit respecter les permissions du CRM. Un agent junior ne doit pas pouvoir interroger des vecteurs relatifs à des documents réservés à la direction. Ce filtre doit être appliqué au niveau de la requête sur la base de données vectorielle (Metadata Filtering).

Étape 5 : Orchestration et Intégration dans le CRM

La dernière pièce est l’intégration dans le frontend du CRM. L’assistant ne doit pas être seulement un chat, mais un agent proactif. Voici un exemple logique de la structure de l’appel :

def get_crm_answer(user_query, user_id):

# 1. Vérification des permissions utilisateur

user_permissions = db.get_permissions(user_id)

# 2. Récupération des documents pertinents (Retrieval) avec filtres de sécurité

docs = vector_store.similarity_search(

user_query,

k=3,

filter={"access_level": {"$in": user_permissions}}

)

# 3. Construction du contexte

context_text = "nn".join([d.page_content for d in docs])

# 4. Génération de la Réponse (Generation)

response = llm_chain.invoke({"context": context_text, "question": user_query})

return responseConclusions : L’Avenir du CRM Financier

Implémenter le RAG dans le CRM transforme une base de données statique en un consultant dynamique. Pour les institutions financières, cela signifie réduire les temps d’intégration des nouveaux employés (qui ont un accès instantané à toute la base de connaissances de l’entreprise) et garantir que chaque réponse donnée au client est conforme aux dernières réglementations en vigueur.

La clé du succès ne réside pas dans le modèle le plus puissant, mais dans la qualité du pipeline de données et la rigueur des protocoles de sécurité. En 2026, la confiance est l’actif le plus précieux, et une architecture RAG bien conçue est le meilleur outil pour la préserver.

Foire aux questions

Alors qu’un LLM générique se base sur des données d’entraînement statiques et souvent datées, une architecture RAG (Retrieval-Augmented Generation) intégrée au CRM permet de consulter en temps réel des documents d’entreprise, des taux d’intérêt actuels et l’historique des clients. Cette approche garantit des réponses basées sur des données propriétaires à jour, réduisant le risque d’informations obsolètes et améliorant la conformité réglementaire dans les conseils financiers.

La protection des données personnelles se fait par plusieurs stratégies défensives. Il est essentiel d’appliquer des techniques de PII Redaction pour anonymiser les noms et codes fiscaux avant qu’ils n’atteignent le modèle IA. De plus, l’utilisation de modèles open-source hébergés sur des serveurs propriétaires et l’implémentation de contrôles d’accès basés sur les rôles (RBAC) assurent que les informations sensibles ne quittent jamais l’infrastructure de l’entreprise et ne sont accessibles qu’au personnel autorisé.

Pour les documents juridiques et financiers, la division du texte basée purement sur les caractères est déconseillée car elle risque de couper des clauses importantes. La stratégie optimale prévoit un découpage sémantique ou récursif, qui maintient unis les paragraphes logiques et utilise un système de chevauchement (overlap) entre les fragments. Cette méthode préserve le contexte nécessaire pour que l’intelligence artificielle puisse interpréter correctement les réglementations lors de la phase de récupération.

L’utilisation de pgvector sur PostgreSQL est souvent préférable pour les CRM propriétaires car elle permet de maintenir les données vectorielles (embeddings) dans le même périmètre de sécurité que les données structurées des clients. Contrairement aux solutions SaaS externes, cette configuration facilite l’exécution de requêtes hybrides combinant la recherche sémantique avec des filtres SQL traditionnels, offrant un meilleur contrôle sur la confidentialité et réduisant la latence réseau.

Le Prompt Engineering avancé agit comme un filtre de sécurité en instruisant le modèle de se baser exclusivement sur le contexte fourni. Grâce à un System Prompt rigoureux, on impose à l’assistant de citer les sources documentaires spécifiques pour chaque affirmation et d’admettre explicitement son ignorance si la réponse n’est pas présente dans les politiques de l’entreprise, empêchant ainsi la génération de taux ou de règles financières inexistants.

Sources et Approfondissements

- Commission Européenne : Le cadre juridique sur l’intelligence artificielle (AI Act)

- CNIL : Intelligence artificielle et protection des données personnelles

- Gouvernance des algorithmes d’intelligence artificielle dans le secteur financier (ACPR)

- Wikipedia : Définition de l’architecture RAG (Retrieval-Augmented Generation)

Avez-vous trouvé cet article utile ? Y a-t-il un autre sujet que vous aimeriez que je traite ?

Écrivez-le dans les commentaires ci-dessous ! Je m'inspire directement de vos suggestions.