No panorama atual da intermediação de crédito, considerar a Lead Generation como uma simples atividade de marketing é um erro estratégico fatal. Estamos na era da Engenharia de Leads, onde o fluxo de aquisição de clientes deve ser tratado como um sistema de controlo de ciclo fechado. Este guia técnico explorará como projetar e implementar um motor de lead scoring preditivo dentro de um ecossistema CRM avançado, como o BOMA, transformando dados comportamentais brutos em probabilidades matemáticas de concessão de crédito habitação.

O objetivo não é mais gerar contactos, mas prever a faturação. Utilizando algoritmos de Machine Learning e uma arquitetura de dados sólida, passaremos da intuição subjetiva dos comerciais para uma abordagem determinística baseada em dados.

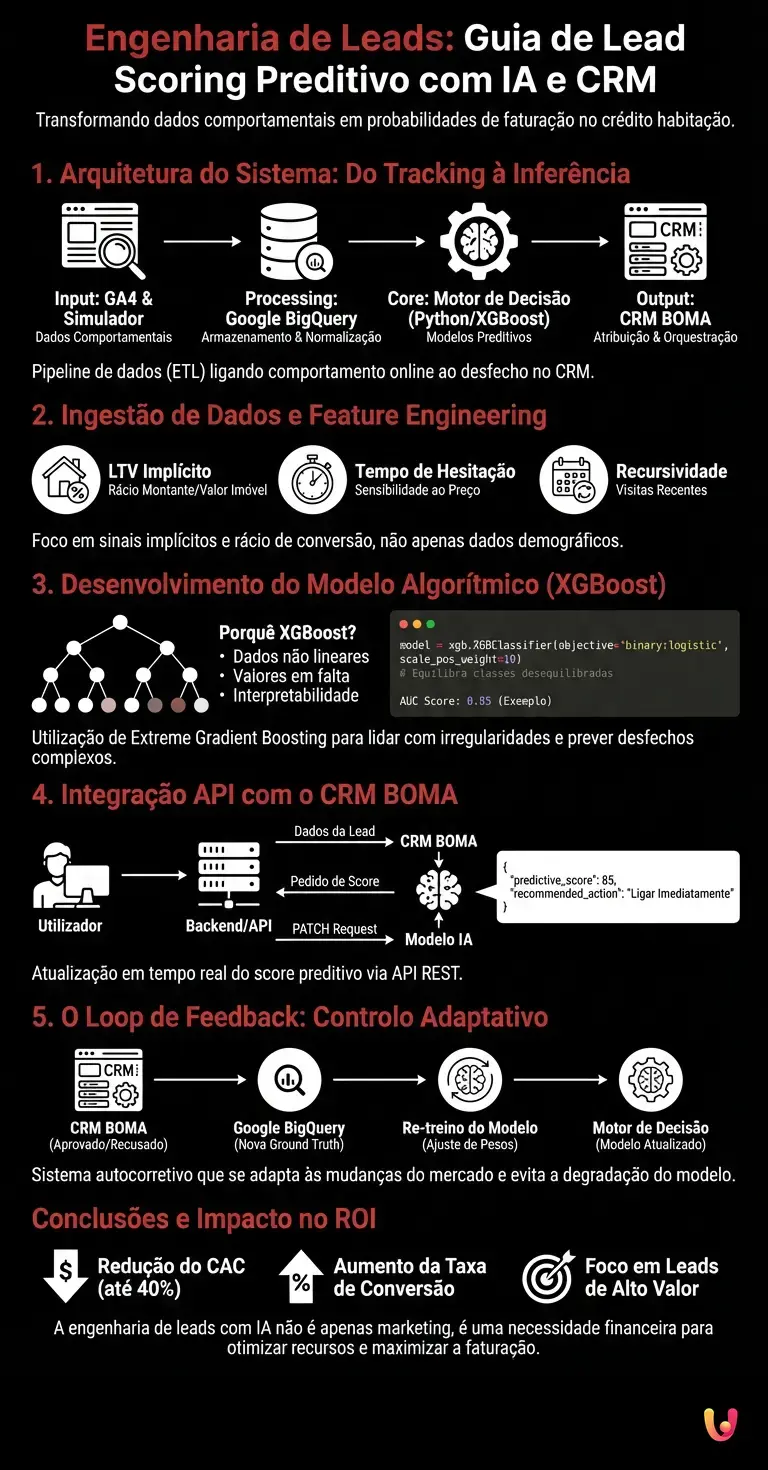

1. Arquitetura do Sistema: Do Tracking à Inferência

Para construir um modelo de scoring eficaz, devemos primeiro estabelecer uma pipeline de dados (ETL) que ligue o comportamento do utilizador no website com o desfecho real do processo no CRM. A arquitetura proposta baseia-se em três pilares:

- Fonte de Dados (Input): Google Analytics 4 (GA4) para os dados comportamentais e os logs do simulador de crédito habitação.

- Data Warehouse (Processing): Google BigQuery para o armazenamento e normalização dos dados.

- Motor de Decisão (Core): Scripts Python (alojados em Cloud Functions ou Vertex AI) que executam modelos XGBoost.

- Destino (Output): O CRM BOMA, que recebe a pontuação e orquestra a atribuição da lead.

Pré-requisitos Técnicos

Antes de prosseguir, certifique-se de que tem acesso a:

- Conta Google Cloud Platform com BigQuery ativado.

- Exportação diária (ou streaming) do GA4 para o BigQuery configurada.

- Acesso API ao CRM BOMA (ou ao seu CRM proprietário).

- Ambiente Python 3.9+ com bibliotecas

pandas,scikit-learn,xgboost.

2. Ingestão de Dados e Feature Engineering

O lead scoring preditivo não se baseia apenas em dados demográficos (idade, rendimento), mas sobretudo em sinais implícitos. No setor do crédito habitação, a forma como um utilizador interage com o simulador é um proxy da sua intenção de compra e da sua elegibilidade.

Extração do BigQuery

Precisamos de extrair as sessões do utilizador e transformá-las em features. Eis uma query SQL de exemplo para extrair métricas comportamentais:

SELECT

user_pseudo_id,

COUNTIF(event_name = 'view_mortgage_simulator') as simulator_interactions,

AVG(SAFE_CAST(event_params.value.string_value AS FLOAT64)) as avg_loan_amount,

MAX(event_timestamp) - MIN(event_timestamp) as session_duration_micros,

COUNTIF(event_name = 'download_pdf_guide') as high_intent_actions

FROM

`project_id.analytics_123456.events_*`

WHERE

_TABLE_SUFFIX BETWEEN '20251201' AND '20260131'

GROUP BY

user_pseudo_id

Definição das Features Críticas

Para um modelo de scoring no crédito, as variáveis (features) mais preditivas que devemos arquitetar incluem:

- Loan-to-Value (LTV) Implícito: Se o utilizador insere no simulador um montante solicitado e um valor do imóvel, o rácio é um forte indicador de viabilidade.

- Tempo de Hesitação: Um tempo excessivo na página das taxas pode indicar sensibilidade ao preço (price sensitivity).

- Recursividade: Número de visitas nos últimos 30 dias.

3. Desenvolvimento do Modelo Algorítmico (XGBoost)

Porquê usar XGBoost (Extreme Gradient Boosting) em vez de uma simples regressão logística? Porque os dados comportamentais são frequentemente não lineares e contêm muitos valores em falta. As árvores de decisão gerem melhor estas irregularidades e oferecem uma maior interpretabilidade através da feature importance.

Implementação Python

Abaixo um exemplo de código para treinar o modelo. Assumimos que temos um DataFrame df que une os dados do GA4 com o desfecho histórico dos processos (0 = perdido, 1 = concedido) exportado do CRM.

import xgboost as xgb

from sklearn.model_selection import train_test_split

from sklearn.metrics import roc_auc_score

# Separação de Features e Target

X = df.drop(['conversion_flag', 'user_id'], axis=1)

y = df['conversion_flag']

# Split do dataset

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# Configuração do modelo XGBoost

model = xgb.XGBClassifier(

objective='binary:logistic',

n_estimators=100,

learning_rate=0.05,

max_depth=6,

scale_pos_weight=10 # Crucial para datasets desequilibrados (poucos créditos concedidos face às leads)

)

# Treino

model.fit(X_train, y_train)

# Avaliação

preds = model.predict_proba(X_test)[:, 1]

print(f"AUC Score: {roc_auc_score(y_test, preds)}")

O parâmetro scale_pos_weight é fundamental no setor do crédito, onde a taxa de conversão real pode ser inferior a 2-3%. Isto equilibra o peso dos erros nas classes positivas.

4. Integração API com o CRM BOMA

Uma vez que o modelo gera uma probabilidade (ex. 0.85), esta deve ser enviada para o CRM em tempo real ou em batch. No contexto do BOMA, utilizaremos as API REST para atualizar o campo personalizado predictive_score.

Workflow de Atualização

- O utilizador preenche o formulário de pedido de simulação.

- O backend envia os dados para o CRM e simultaneamente interroga o nosso modelo (exposto via API Flask/FastAPI).

- O modelo calcula o score baseando-se no histórico de navegação (recuperado via

client_idou cookie). - O sistema envia um pedido PATCH para o CRM.

Exemplo de Payload JSON para o BOMA:

{

"lead_id": "102938",

"custom_fields": {

"predictive_score": 85,

"score_cluster": "HOT",

"recommended_action": "Call_Immediately"

}

}

5. O Loop de Feedback: Controlo Adaptativo

O verdadeiro poder da engenharia de sistemas reside no feedback. Um modelo estático degrada-se com o tempo (model drift). É necessário configurar um processo inverso:

Todas as noites, um script deve extrair do CRM BOMA o estado atualizado dos processos (ex. “Análise”, “Aprovação”, “Recusada”) e carregá-lo no BigQuery. Estes dados tornam-se a nova Ground Truth para o re-treino do modelo.

- Se o modelo tinha previsto 90/100 para uma lead que foi depois recusada por “Rendimento Insuficiente”, o algoritmo aprenderá a penalizar combinações semelhantes de features nas iterações futuras.

- Isto cria um sistema autocorretivo que se adapta às mudanças do mercado (ex. aperto nas políticas de crédito dos bancos).

Conclusões e Impacto no ROI

Implementar um sistema de lead scoring predittivo não é um exercício académico, mas uma necessidade financeira. Ao deslocar os recursos do call center para as leads com score > 70, as empresas de intermediação de crédito podem reduzir o custo de aquisição de cliente (CAC) até 40% e aumentar a taxa de conversão nos processos trabalhados.

A integração entre GA4, BigQuery e um CRM evoluído como o BOMA representa o estado da arte em 2026. Já não se trata de ligar a todos os contactos o mais depressa possível, mas de ligar aos contactos certos, com a oferta certa, no momento certo, guiados pela matemática.

Perguntas frequentes

O lead scoring preditivo é uma metodologia que utiliza algoritmos de Machine Learning para calcular a probabilidade matemática de um contacto se transformar em faturação. No setor do crédito, este sistema analisa os comportamentos do utilizador, como a interação com o simulador, para atribuir uma pontuação de prioridade, permitindo aos consultores concentrarem-se apenas nos processos com alta probabilidade de concessão.

Prefere-se o XGBoost porque os dados comportamentais online são frequentemente não lineares e fragmentados. Ao contrário da regressão clássica, as árvores de decisão deste algoritmo gerem melhor os valores em falta e oferecem uma maior interpretabilidade das variáveis, resultando mais eficazes na previsão de desfechos complexos como a aprovação de um crédito habitação.

Um modelo robusto requer a combinação de dados de navegação, provenientes de ferramentas como o Google Analytics 4, e dados históricos sobre os desfechos dos processos presentes no CRM. As features mais preditivas incluem a taxa de esforço implícita, o tempo de hesitação nas ofertas e a frequência das visitas ao site nos últimos 30 dias.

A arquitetura prevê a extração dos dados brutos do GA4 para o BigQuery para armazenamento. Posteriormente, scripts Python processam estes dados gerando um score que é enviado em tempo real para o CRM BOMA através de API. Isto permite atualizar a ficha de cliente com uma pontuação preditiva e sugerir ao comercial a melhor ação a empreender.

O feedback loop é um processo que reimporta o desfecho real das vendas do CRM para o modelo de inteligência artificial. Isto permite ao sistema autocorrigir-se: se uma lead com pontuação alta não converte, o algoritmo aprende a penalizar perfis semelhantes no futuro, reduzindo o custo de aquisição de cliente e aumentando a eficiência operacional do call center.

Achou este artigo útil? Há outro assunto que gostaria de me ver abordar?

Escreva nos comentários aqui em baixo! Inspiro-me diretamente nas vossas sugestões.